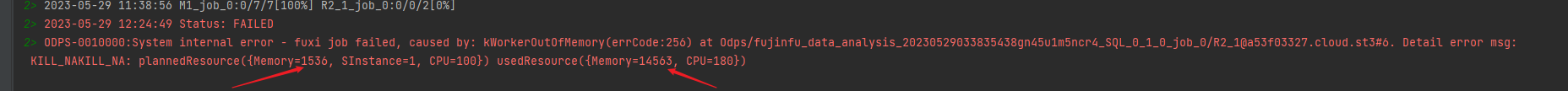

这个是代表我们公司使用的maxcompute内核太小了吗?

这个是代表我们公司使用的maxcompute内核太小了吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要判断您公司使用的MaxCompute内核是否太小,需要结合具体的使用场景、任务负载以及资源分配情况进行分析。以下是一些可能影响性能的关键因素和排查方法:

1. 资源分配不足

MaxCompute的计算资源以CU(Compute Unit)为单位进行分配,1 CU = 4 GB内存 + 1 CPU Core。如果您的任务经常出现以下问题,可能是资源分配不足导致的: - 内存不足:任务报错java.lang.OutOfMemoryError或Cannot allocate memory。 - 解决方案:调整相关参数,例如spark.executor.memory、spark.driver.memory等,增加Executor或Driver的内存。 - CPU使用率过高:通过Logview 2.0查看作业详情时,发现CPU使用量接近申请的CPU量(cpu_plan),但实际使用量(cpu_usage)较低。 - 解决方案:增加Processor数量以提升CPU资源。

2. 存储与计算瓶颈

- 磁盘空间不足:任务报错

No space left on device。- 解决方案:调整

spark.hadoop.odps.cupid.disk.driver.device_size参数,增加本地磁盘大小;或者增加Executor数量以分散Shuffle数据的压力。

- 解决方案:调整

- 数据倾斜:单个Executor处理的数据量过大,导致任务运行缓慢或失败。

- 解决方案:对数据进行重分区,或者增加

spark.executor.instances参数以提高并发度。

- 解决方案:对数据进行重分区,或者增加

3. 任务优化不足

- 小文件问题:如果输入数据中存在大量小文件,可能导致任务启动时间过长或运行效率低下。

- 解决方案:通过合并小文件或使用DataWorks的自定义资源组来优化任务调度。

- SQL查询优化:GROUP BY操作可能导致数据分布不均,影响压缩比和存储效率。

- 解决方案:在写入数据时进行局部排序,提高数据压缩比。

4. 外部表性能问题

如果您使用的是外部表(如HBase、OSS、Tablestore等),可能会因为网络延迟或远程读取导致性能下降。 - 常见现象:查询外部表的速度远低于内部表。 - 解决方案:将外部表数据导入到MaxCompute内部表中,再进行查询。

5. 弹性扩展能力

MaxCompute支持动态扩缩容,您可以根据业务需求调整存储和计算资源。如果当前内核资源不足,可以通过以下方式解决: - 增加CU数量:按需弹性扩展,无需提前规划容量。 - ECS资源共享:如果使用了ECS资源复用版,确保共享时间已到且可用CU值充足。如果资源不足,请检查ECS库存或提交工单申请。

6. 如何确认内核是否太小

- 监控工具:使用Logview 2.0查看作业的CPU、内存、磁盘等资源使用情况。如果资源使用率长期接近上限,则说明当前内核可能不足以支撑任务负载。

- 任务运行时间:如果任务运行时间显著延长,且伴随资源不足的报错信息,则可能是内核资源不足。

- 业务增长:如果近期业务数据量或任务复杂度显著增加,而未相应调整资源配额,也可能导致性能瓶颈。

总结建议

如果经过上述排查后,确认当前MaxCompute内核资源不足以满足业务需求,建议: 1. 增加CU数量:根据任务负载动态扩展计算资源。 2. 优化任务配置:调整内存、磁盘、并发度等相关参数。 3. 升级存储与计算架构:将外部表数据迁移到内部表,减少远程读取开销。

如需进一步协助,请提供具体的任务日志或错误信息,以便更精准地定位问题。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。