问下各位老师,Flink CDC中OracleSource 的设置 每次拉取批次大小参数是这样的吗?

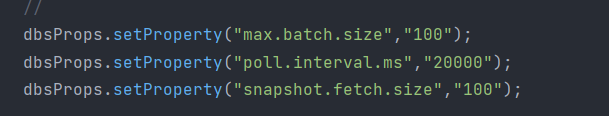

问题1:问下各位老师,Flink CDC中OracleSource 的 设置 每次拉取批次大小参数是这样的吗?感觉没生效。 我按 debezium 官方有配置项来的,貌似没生效 问题2:那位老师,抽几分钟解答下。OracleSource 是怎么设置限流的,测试中发现数据量太大,把内存打爆了。

我按 debezium 官方有配置项来的,貌似没生效 问题2:那位老师,抽几分钟解答下。OracleSource 是怎么设置限流的,测试中发现数据量太大,把内存打爆了。

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

问题1: Flink CDC中OracleSource的设置每次拉取批次大小参数是否正确?

在Flink CDC中,OracleSource 的每次拉取批次大小可以通过 Debezium 提供的相关参数进行配置。根据知识库中的信息,Debezium 支持通过自定义参数来调整 Binlog 拉取的行为。以下是一些关键点和建议:

1. Debezium 参数配置

- 在 Flink CDC 中,您可以通过

debezium.*参数传递自定义配置。例如:'debezium.snapshot.fetch.size' = '1024'这个参数用于控制每次从 Oracle 数据库中拉取数据的批次大小。

- 如果您发现该参数未生效,可能的原因包括:

- 参数名称错误:确保使用的是 Debezium 官方文档中支持的参数名称。

- 版本兼容性问题:不同版本的 Flink CDC 和 Debezium 可能对参数的支持存在差异,请确认使用的版本是否支持该参数。

- 配置未正确传递:检查是否将参数正确传递到 Flink SQL 或 DataStream API 中。

2. 验证参数是否生效

- 您可以通过以下方式验证参数是否生效:

- 查看 Flink 作业日志,确认 Debezium 是否加载了您配置的参数。

- 使用监控工具(如 Flink Web UI)观察数据拉取的速度和批次大小,判断是否符合预期。

3. 其他相关参数

- 如果

debezium.snapshot.fetch.size未生效,您可以尝试调整其他相关参数,例如:'scan.incremental.snapshot.chunk.size':控制增量快照的分块大小,默认值为 8096 行。'debezium.max.batch.size':控制每次从数据库中读取的最大事件数。

4. 建议

- 确保您的 Flink CDC 版本与 Debezium 版本兼容。

- 如果问题仍未解决,可以尝试升级到最新版本的 Flink CDC 和 Debezium,以获得更好的支持。

问题2: OracleSource 是如何设置限流的?测试中发现数据量太大,导致内存被打爆。

在 Flink CDC 中,OracleSource 的限流功能可以通过多种方式实现,以避免因数据量过大而导致内存不足的问题。以下是详细的解决方案和配置方法:

1. SQL限流功能

- PolarDB 和 DAS 的 SQL限流:阿里云提供了 SQL限流功能,可以帮助您控制数据库请求访问量和 SQL 并发量。具体步骤如下:

- 登录阿里云数据库自治服务(DAS)控制台。

- 配置限流规则,例如:

- 通过关键词限流:根据 SQL 语句中的关键词进行匹配并限流。

- 通过执行耗时限流:当 SQL 执行时间超过设定阈值时,自动加入限流规则。

- 应用限流规则后,观察系统性能是否得到改善。

2. Flink 内部限流

- 调整 Source 并发度:通过降低 Source 的并发度,减少数据拉取的速度。例如:

SET parallelism.source = 2; - 限制每秒处理的记录数:通过 Flink 的速率限制功能,控制每秒处理的记录数。例如:

'source.rate-limit' = '1000'这个参数可以限制每秒从 Oracle 数据库中拉取的记录数。

3. 内存管理优化

- 启用 Resource Manager:PolarDB 提供了 Resource Manager 功能,可以通过 Cgroup 对内存使用进行限制。关键参数包括:

enable_resource_manager:启用或禁用 Resource Manager,默认值为on。total_mem_limit_rate:限制集群内存使用的百分比,默认值为 95%。mem_release_policy:指定内存释放策略,例如优先中断空闲进程或活跃进程。

- 调整 JVM 堆内存:增加 Flink TaskManager 的堆内存大小,以应对高数据量场景。例如:

taskmanager.memory.process.size: 4g

4. 分批处理大事务

- 根据知识库中的建议,避免一次性处理大量数据或大事务操作。您可以将大事务拆分为多个小事务,逐步处理数据。

- 例如,在 Oracle 数据库中,可以通过分页查询的方式逐步读取数据:

SELECT * FROM your_table WHERE rownum <= 1000 OFFSET 0;

5. 监控与调优

- 监控指标:通过 Flink Web UI 或 Prometheus 监控以下指标:

currentEmitEventTimeLag:判断数据同步是否延迟。TaskManager Memory Usage:观察内存使用情况。

- 动态调整参数:根据监控结果动态调整限流参数和内存配置,确保系统稳定运行。

总结

- 问题1:确保使用正确的 Debezium 参数(如

debezium.snapshot.fetch.size),并验证其是否生效。如果问题仍未解决,可以尝试调整其他相关参数或升级版本。 - 问题2:通过 SQL限流、Flink 内部限流、内存管理优化和分批处理大事务等方式,有效控制数据量,避免内存被打爆。同时,建议结合监控工具动态调整参数,确保系统稳定性。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

问答分类:

相关问答

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理