Flink CDC这种算数据倾斜不?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC本身并不直接等同于数据倾斜,但在某些场景下可能会引发数据倾斜问题。数据倾斜通常是指在分布式计算中,某些任务处理的数据量远大于其他任务,导致整体作业性能下降。以下从几个方面分析Flink CDC是否可能导致数据倾斜,并提供相关优化建议。

如果源数据库中的数据分布不均匀(例如某些表或某些主键的数据量远大于其他表或主键),那么在Flink CDC捕获这些数据时,可能会导致下游任务的数据处理负载不均衡。

- 示例:MySQL的binlog日志中,某些表的更新频率远高于其他表,这会导致Flink CDC读取到的数据量分布不均。

在Flink CDC中,主键或更新键的设计会影响数据分发的均匀性。如果主键分布不均匀(如某些主键值出现频率极高),则可能导致某些并行子任务处理的数据量过大。

- 示例:某张表的主键为用户ID,但大部分操作集中在少数几个用户上,这会导致这些用户的变更数据集中在少数任务中。

当Flink CDC将数据写入目标存储(如Hologres、Kafka等)时,如果目标表的分区键或分片策略不合理,也可能导致写入压力集中在某些节点上。

- 示例:Hologres的目标表使用了不合理的分区键,导致某些分区的数据量远大于其他分区。

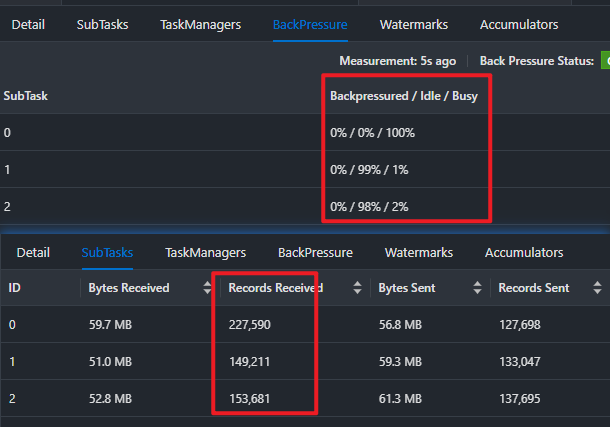

可以通过以下方式判断Flink CDC作业是否存在数据倾斜:

SHUFFLE_HASH优化来避免数据倾斜。该优化会根据主键进行shuffle,从而平衡数据分布。Flink CDC本身并不会直接导致数据倾斜,但如果源数据分布不均、主键设计不合理或目标存储的分区策略不当,则可能引发数据倾斜问题。为了避免数据倾斜,建议从数据源、Flink作业和目标存储三个层面进行优化。

- 重要提醒:在实际生产环境中,建议定期监控Flink作业的运行状态和目标存储的数据分布情况,及时发现并解决数据倾斜问题。

如果您需要更具体的优化方案,请提供更多关于数据源、目标存储和Flink作业配置的详细信息。