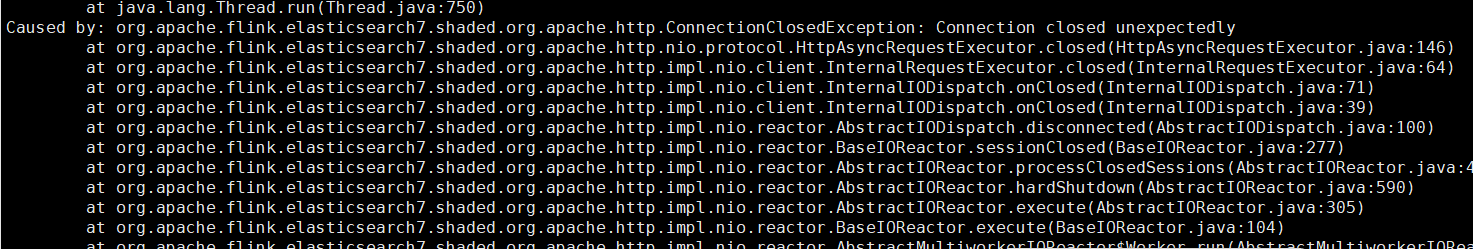

各位大佬,使用Elasticsearch flink sql对数据进行处理后写入到es中,任务运行一会儿报这个错误?请问该怎么解决呢?现在这个错误每次flink任务运行的时候都会出现

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,Flink任务在运行一段时间后报错,并且每次运行都会出现该问题。结合知识库中的相关资料,以下是可能的原因分析及解决方案:

Flink任务运行时写入Elasticsearch失败,可能由以下原因导致: - Elasticsearch集群资源不足:写入请求过高,触发熔断机制,导致写入失败。 - 内存溢出(OOM):Elasticsearch节点的堆内存不足,无法处理大量写入请求。 - 网络连接超时:客户端与Elasticsearch之间的连接超时或被重置。 - 分片分配异常:Elasticsearch集群中存在未分配的分片,导致写入失败。 - 数据格式不匹配:写入的数据格式与目标索引的mapping定义不一致,导致写入失败。

如果写入请求过高,可能会触发Elasticsearch的熔断机制。建议按照以下步骤排查和解决: 1. 清理缓存: 执行以下命令清理索引缓存,释放资源:

POST /索引名/_cache/clear?fielddata=true

如果问题仍未解决,继续执行后续步骤。

检查分片分配情况: 使用以下命令查看分片分配是否均匀:

GET /_cat/indices?v

如果发现分片分配不均,调整副本数以优化分片分布。

降低并发写入量: 减少Flink任务的并发写入量,避免对Elasticsearch造成过大压力。

扩容集群: 如果上述方法无效,考虑通过升配集群来增加CPU、内存或磁盘资源。

如果Elasticsearch节点出现内存溢出(OOM),可以采取以下措施: 1. 清理缓存: 使用以下命令清理缓存,观察内存使用情况:

curl -u elastic:<password> -XPOST "localhost:9200/<index_name>/_cache/clear?pretty"

替换<password>为您的实例密码,<index_name>为目标索引名称。

如果报错涉及网络连接问题(如Connection reset by peer),可以按照以下步骤排查: 1. 延长超时时间: 在Flink客户端中调整ConnectTimeout和SocketTimeout参数。例如:

ConnectTimeout = 10000

SocketTimeout = 30000

这可以避免因网络波动导致的连接超时。

如果Elasticsearch集群中存在未分配的分片,可能导致写入失败。建议按照以下步骤排查: 1. 查看集群健康状态: 使用以下命令检查集群状态:

GET /_cat/health?v

如果状态为yellow或red,需要进一步排查原因。

重新分配分片: 如果分片分配失败,可以尝试重新分配:

POST /_cluster/reroute?retry_failed=true

调整副本数: 如果主副本分片分配到同一节点,建议将副本数临时设置为0,待集群恢复正常后再恢复为1。

如果写入的数据格式与目标索引的mapping定义不一致,可能导致写入失败。建议: 1. 检查目标索引的Mapping: 使用以下命令查看目标索引的Mapping:

GET /索引名/_mapping

启用异步写入模式: 如果当前使用的是同步写入模式,建议启用异步写入模式,以提高写入性能和稳定性。

监控集群状态: 使用阿里云Elasticsearch高级监控功能,实时监控集群的CPU、内存、磁盘等资源使用情况,及时发现并解决问题。

请根据上述步骤逐一排查问题。如果问题仍未解决,建议提供具体的错误日志信息,以便进一步分析和定位问题。