flinkcdc怎么监测表结构的变化呀,哪位大佬可以指点一下?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC 可以通过以下几种方式来监测表结构的变化:

1、通过解析数据库的日志文件:Flink CDC 可以解析数据库的 Write-Ahead Log (WAL) 文件,从而获取表结构的变化。在解析过程中,Flink CDC 会比较新旧表结构之间的差异,并生成相应的 DDL 语句,用于更新 Flink 中的表结构。

2、通过监听数据库的元数据变更事件:Flink CDC 可以监听数据库的元数据变更事件,例如表的创建、修改和删除事件。当监听到这些事件时,Flink CDC 可以获取新的表结构,并更新 Flink 中的表结构。

3、通过数据库的元数据 API:某些数据库提供了元数据 API,可以通过调用这些 API 获取表结构的变化。Flink CDC 可以与这些 API 进行集成,以实现实时监测表结构变化的功能。

需要注意的是,具体的实现方式可能因数据库类型和配置而有所不同。你需要根据所使用的数据库和相关技术进行适当的调整和配置。

楼主你好,阿里云 Flink CDC 可以通过监测 MySQL 数据库中的 binlog 日志来捕捉表的数据变化。如果要监测表结构的变化,可以通过以下步骤来实现:

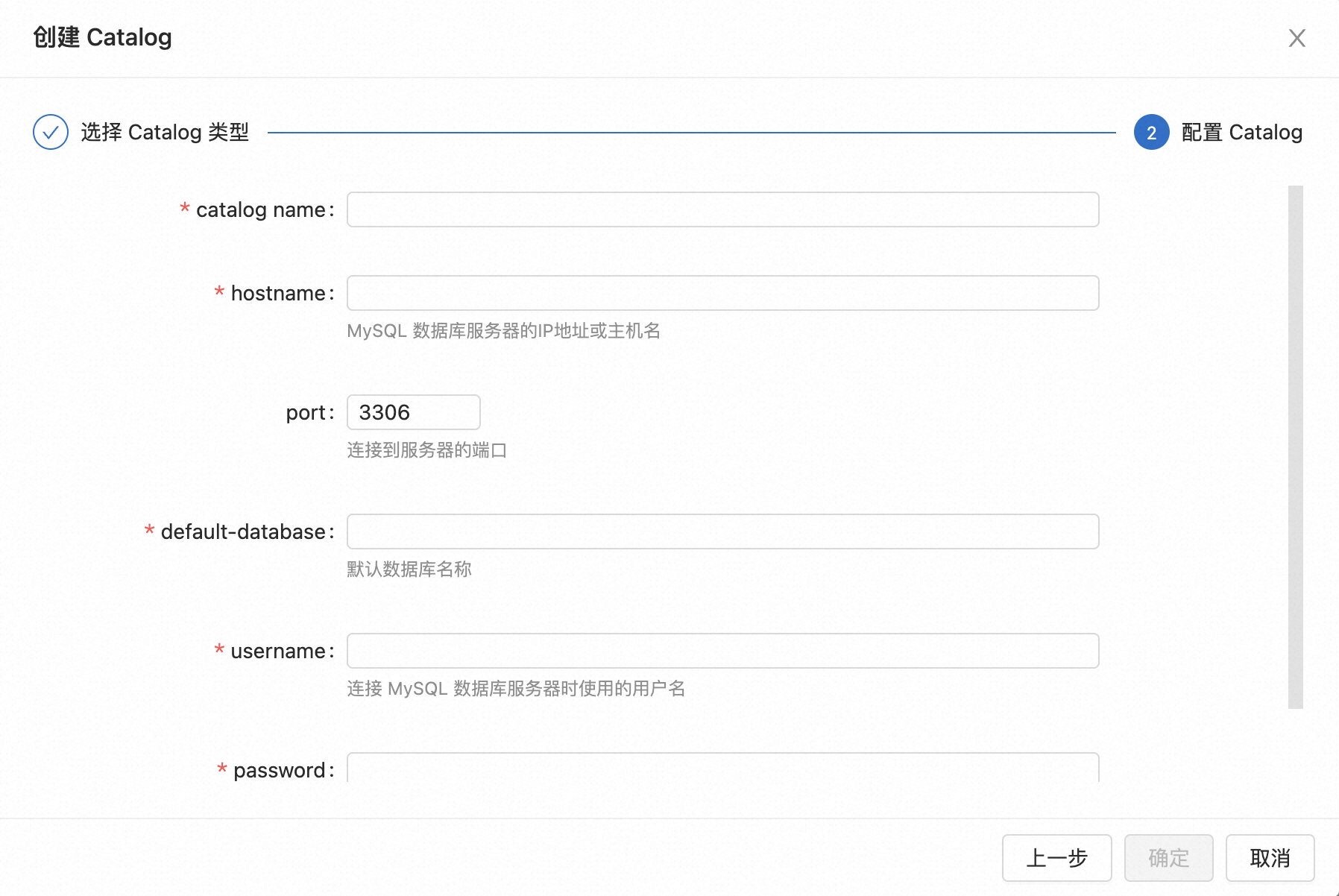

配置 Flink CDC 的 MySQL 连接信息,并启动 Flink CDC 任务。

在 MySQL 数据库中触发表结构变化的操作,如添加、删除、修改列等。

在 Flink CDC 的控制台上查看监听的表是否能够捕捉到表结构变化的信息。若能,可以通过配置 Flink CDC 的输出目的地将变化记录输出到指定位置。

数据变化记录输出到指定位置后,可以通过查询输出的信息来了解表结构的变化情况。

需要注意的是,Flink CDC 目前不支持自动识别 MySQL 数据库表结构的变化,因此需要手动触发监测操作来实现。同时还需要在 Flink CDC 配置中添加监听表结构变化的规则,详细配置方法可以参考阿里云 Flink CDC 文档。

在Flink CDC中,要监测表结构的变化,可以使用以下方法之一:

定期检查元数据:您可以定期查询数据库的元数据(如information_schema)来比较表结构的变化。将当前的表结构与先前保存的表结构进行比较,以检测任何更改。

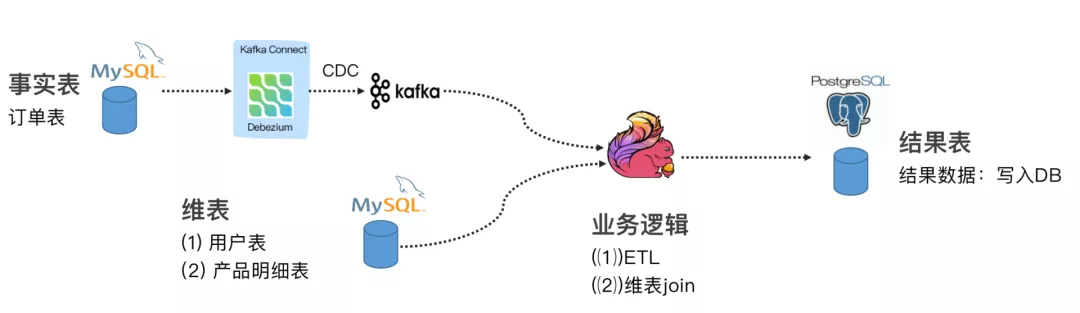

使用外部工具:您可以使用外部工具或框架来监测数据库表结构的变化,并将这些变化通知给Flink CDC。例如,您可以编写一个独立的程序,通过监听数据库的DDL语句或使用特定的数据库工具(如Debezium)来监测和捕获表结构变化,并将这些变化作为事件发送给Flink CDC。

集成数据库触发器:您可以在数据库中设置触发器,在表结构发生变化时触发相应的操作。在触发器中,您可以编写逻辑将表结构变化记录到另一个表中或发送到消息队列(如Kafka)。接下来,Flink CDC可以订阅这些变化,以便及时感知和处理表结构变化。

Flink CDC可以监测数据库表结构的变化。当数据库表结构发生变化时,Flink CDC会自动检测到这些变化,并将其转换为Flink表的变化。这样,您可以在Flink中使用这些变化来更新表的结构,以保持Flink表和数据库表的一致性。

要监视表结构的变化,可以使用Flink CDC提供的CDC API。该API允许您监视数据库表的变化,并将这些变化转换为Flink表的变化。您可以使用CDC API来检测表结构的变化,并根据需要更新Flink表的结构。

要监视表结构的变化,可以使用Flink CDC提供的CDC API。具体的实现方式如下:

1、首先,您需要在Flink中安装和配置CDC。可以使用以下命令安装和配置CDC:

·$ bn/flink run -c org.apache.flink.client.cli.CliFrontend ./flink run -m yarn-cluster -yn 2 -ys 2 -yjm 1024 -ytm 1024 -c com.example.CDC /path/to/cdc.jar /path/to/config.yml

2、接下来,您需要在Flink中启用CDC。可以使用以下命令启用CDC:$ bin/flink run -c org.apache.flink.client.cli.CliFrontend ./flink run -m yarn-cluster -yn 2 -ys 2 -yjm 1024 -ytm 1024 -c com.example.CDC /path/to/cdc.jar /path/to/config.yml start

3、然后,您可以使用CDC API来监视表结构的变化。可以使用以下代码来使用CDC API:import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.functions.source.SourceFunction;

import org.apache.flink.streaming.api.functions.source.SourceRecord;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import org.apache.flink.streaming.connectors.kafka.KafkaSerializationSchema;

import org.apache.flink.streaming.connectors.kafka.KafkaSink;

import org.apache.flink.streaming.connectors.kafka.KafkaSinkBuilder;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KafkaSinkSemantic;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KafkaSinkSemantic;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSerializationSchemaWrapper;

import org.apache.flink.streaming.connectors.kafka.internals.KeyedSinkFunctionWrapper;

Flink CDC(Change Data Capture)主要用于捕获和处理数据源中表级别的变更事件,而不是直接监测表结构的变化。表结构的变化包括列的添加、删除、修改以及约束的变更等。

如果您需要监测和处理表结构的变化,可以考虑以下几种方法:

使用数据库自身的机制:一些数据库管理系统(DBMS)提供了自身的机制来监测表结构的变化。例如,PostgreSQL 提供了 pg_catalog.pg_trigger 系统表,您可以通过查询这个表来获取表的触发器信息,从而判断是否有触发器与表结构相关联。通过监测和解析这些触发器,您可以检测到表结构的变化。

使用数据库的元数据:大多数数据库系统都提供了元数据(Metadata)来描述数据库对象的信息,包括表、列、约束等。您可以通过查询数据库的元数据来获取表结构的定义,并定期对比前后两个时间点的元数据,以检测是否有变化。

使用第三方工具:有一些第三方工具可以帮助监测和管理数据库表结构的变化。例如,Liquibase、Flyway 和 Apache Atlas 等工具可以帮助您跟踪和记录数据库表结构的变化,并提供相应的通知机制和管理界面。

请注意,以上提到的方法都是独立于 Flink CDC 的,它们主要关注于表结构的变化监测和管理。如果您希望将表结构的变化与 Flink CDC 结合使用,可能需要自行编写逻辑来处理这些变化,例如在表结构变化后重新配置 Flink CDC 任务或进行相应的数据转换和处理。

FlinkCDC可以使用Oracle的逻辑复制元数据来监测表结构的变化。在Oracle数据库中,逻辑复制元数据包含了表的详细信息,如表名、列名、列类型等。FlinkCDC通过订阅这些元数据,可以监测表结构的变化。

具体来说,FlinkCDC通过以下步骤来监测表结构的变化:

连接到Oracle数据库,并获取逻辑复制元数据。

将获取的元数据转换为Flink可以处理的格式。

使用Flink的DataStream API对转换后的元数据进行处理和分析。

通过监测元数据的变化,判断表结构是否发生了变化。

如果监测到表结构发生了变化,FlinkCDC可以生成相应的变更数据,并将这些数据发送给Flink进行进一步处理。

Flink CDC可以监测表结构的变化。具体来说,您可以使用Flink CDC提供的Snapshot功能,对表结构进行快照,并将快照信息写入目标数据库中。这样,您就可以通过读取目标数据库中的快照信息,来监测表结构的变化。

需要注意的是,如果您使用Flink CDC监测表结构的变化,那么您需要注意以下几点:

在启动Flink CDC任务时,需要指定snapshot参数和snapshotPath参数,以启用Snapshot功能。

在配置文件中,需要指定snapshot参数和snapshotPath参数,以指定Snapshot功能的参数。

在配置文件中,需要指定snapshot参数和snapshotPath参数,以指定Snapshot功能的参数。

在配置文件中,需要指定snapshot参数和snapshotPath参数,以指定Snapshot功能的参数。

需要注意的是,如果您使用Flink CDC监测表结构的变化,那么您需要注意数据的处理效率和准确性。同时,您还需要注意数据的安全性和可靠性,以保证数据的正确性和可靠性。

要监测表结构的变化,可以采取以下方法:

1.使用数据库的元数据:大多数关系型数据库都提供了系统表或视图来存储表的元数据信息,如列名、数据类型等。通过查询这些系统表或视图,并与之前的元数据进行比较,就可以检测到表结构的变化。

2.使用DDL触发器:DDL(Data Definition Language)触发器可以在表结构发生变化时执行相应的操作。你可以创建一个DDL触发器,在表结构发生变化时触发事件,然后通过监听这些事件来检测表结构的变化。

3.使用专门的工具或库:有些数据库变更监测工具或库可以帮助你自动监测表结构的变化。例如,Debezium 是一个开源的CDC工具,可以实时捕获数据库的变化并将其转换为可订阅的流数据,你可以利用它来监测表结构的变化。

无论使用哪种方法,重要的是建立一个监测机制来定期或实时地检查数据库中表结构的变化。这样,当表结构发生变化时,你可以及时得到通知并做出相应的处理,例如更新相关的数据处理逻辑或重新部署相应的数据流处理程序。