请问下ModelScope我离线使用语音识别的时候,文件地址传的是局域网内其他服务器的地址,他为什么会识别用线上的模型去了,怎么样强制用本地的模型? 我指定了我本地路径之后还是用的线上的地址

请问下ModelScope我离线使用语音识别的时候,文件地址传的是局域网内其他服务器的地址,他为什么会识别用线上的模型去了,怎么样强制用本地的模型? 我指定了我本地路径之后还是用的线上的地址  他会不会是识别到我的文件地址是http的就调外网地址?http我这个http是局域网其他的地址 他这个离线使用模型是怎么判断的呢?

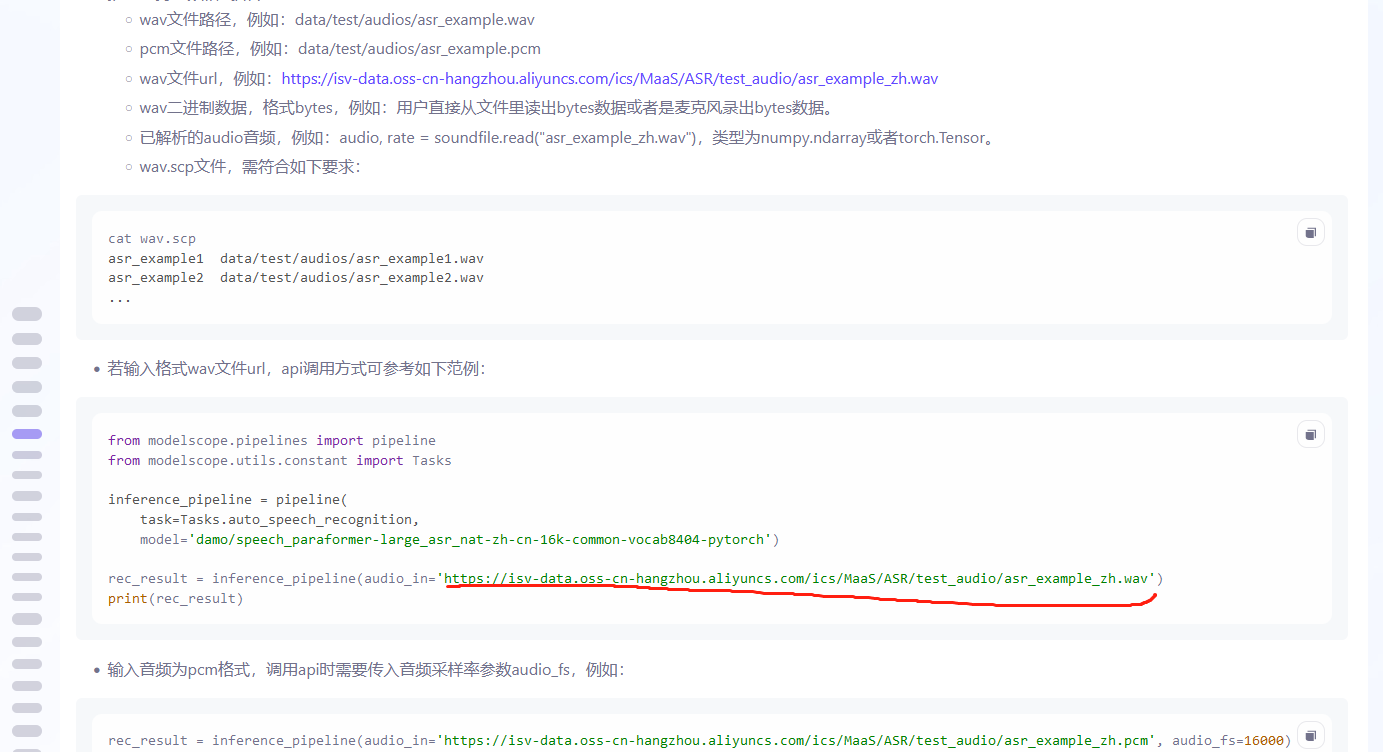

他会不会是识别到我的文件地址是http的就调外网地址?http我这个http是局域网其他的地址 他这个离线使用模型是怎么判断的呢?

在使用ModelScope进行离线语音识别时,如果文件地址传的是局域网内其他服务器的地址(例如http://开头的路径),系统可能会误判为需要调用在线模型,而不是本地模型。这种行为可能与模型服务的配置逻辑有关。以下是详细分析和解决方案:

根据您的描述,即使指定了本地模型路径,系统仍然尝试调用线上模型。这可能是由于以下原因导致的: - 文件地址协议的影响:当您传递的文件地址是http://开头时,系统可能默认认为这是一个远程资源,从而触发在线模型的调用逻辑。 - 模型服务的默认行为:某些模型服务在未明确指定本地模式时,可能会优先尝试调用线上模型,尤其是当输入数据源看起来像是网络资源时。 - 配置未完全生效:虽然您指定了本地路径,但可能某些配置参数未正确设置,导致系统未能强制使用本地模型。

确认本地模型路径

确保您已经按照文档中的步骤下载了模型文件,并将其存储在指定的本地路径中。例如:

LOCAL_SAVE_PATH="/mnt/7B"

确保该路径下存在完整的模型文件,并且当前用户对该目录有读写权限。

验证模型加载配置

在启动模型推理服务时,确保通过命令行或配置文件明确指定了本地模型路径。例如:

MODEL_NAME="DeepSeek-R1-Distill-Qwen-7B"

LOCAL_SAVE_PATH="/mnt/7B"

sudo docker run -d -t --network=host --gpus all \

-v ${LOCAL_SAVE_PATH}:/data \

egs-registry.cn-hangzhou.cr.aliyuncs.com/egs/vllm:0.6.4.post1-pytorch2.5.1-cuda12.4-ubuntu22.04 \

/bin/bash -c "vllm serve /data/${MODEL_NAME}"

这里通过/data/${MODEL_NAME}明确指定了本地模型路径。

http://地址将文件下载到本地

如果您的文件地址是局域网内的http://地址,建议先将文件下载到本地,然后传递本地文件路径给模型服务。例如:

wget http://局域网地址/音频文件.wav -O /本地路径/音频文件.wav

然后将/本地路径/音频文件.wav作为输入传递给模型。

修改输入数据源的协议

如果必须使用局域网地址,可以尝试将http://替换为file://协议,以明确告知系统这是一个本地资源。例如:

file:///局域网地址/音频文件.wav

检查模型服务的配置文件

某些模型服务可能提供了离线模式的配置选项。请检查模型服务的配置文件(如config.json或settings.yaml),确保启用了离线模式。例如:

{

"model_mode": "offline",

"local_model_path": "/mnt/7B/DeepSeek-R1-Distill-Qwen-7B"

}

通过环境变量强制离线

某些模型服务支持通过环境变量强制启用离线模式。例如:

export MODEL_MODE=offline

export LOCAL_MODEL_PATH=/mnt/7B/DeepSeek-R1-Distill-Qwen-7B

重启模型服务

修改配置后,重启模型服务以确保更改生效。

查看日志输出

启动模型服务后,查看日志输出,确认是否加载了本地模型。例如:

sudo docker logs -f <容器名称>

日志中应显示类似以下内容:

Loading model from local path: /mnt/7B/DeepSeek-R1-Distill-Qwen-7B

测试离线功能

断开服务器的外网连接,然后运行语音识别任务,验证是否能够正常工作。如果任务成功完成,则说明离线模式已生效。

http://或file://协议。通过以上步骤,您可以强制模型服务使用本地模型,避免因文件地址协议或配置问题导致的误判。如果问题仍未解决,请提供更多日志信息以便进一步分析。您也可以通过ECS一键诊断全面排查并修复ECS问题。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉群号:44837352