我发现如果一个source对应的collection没有数据变更,flink任务的checkpoin

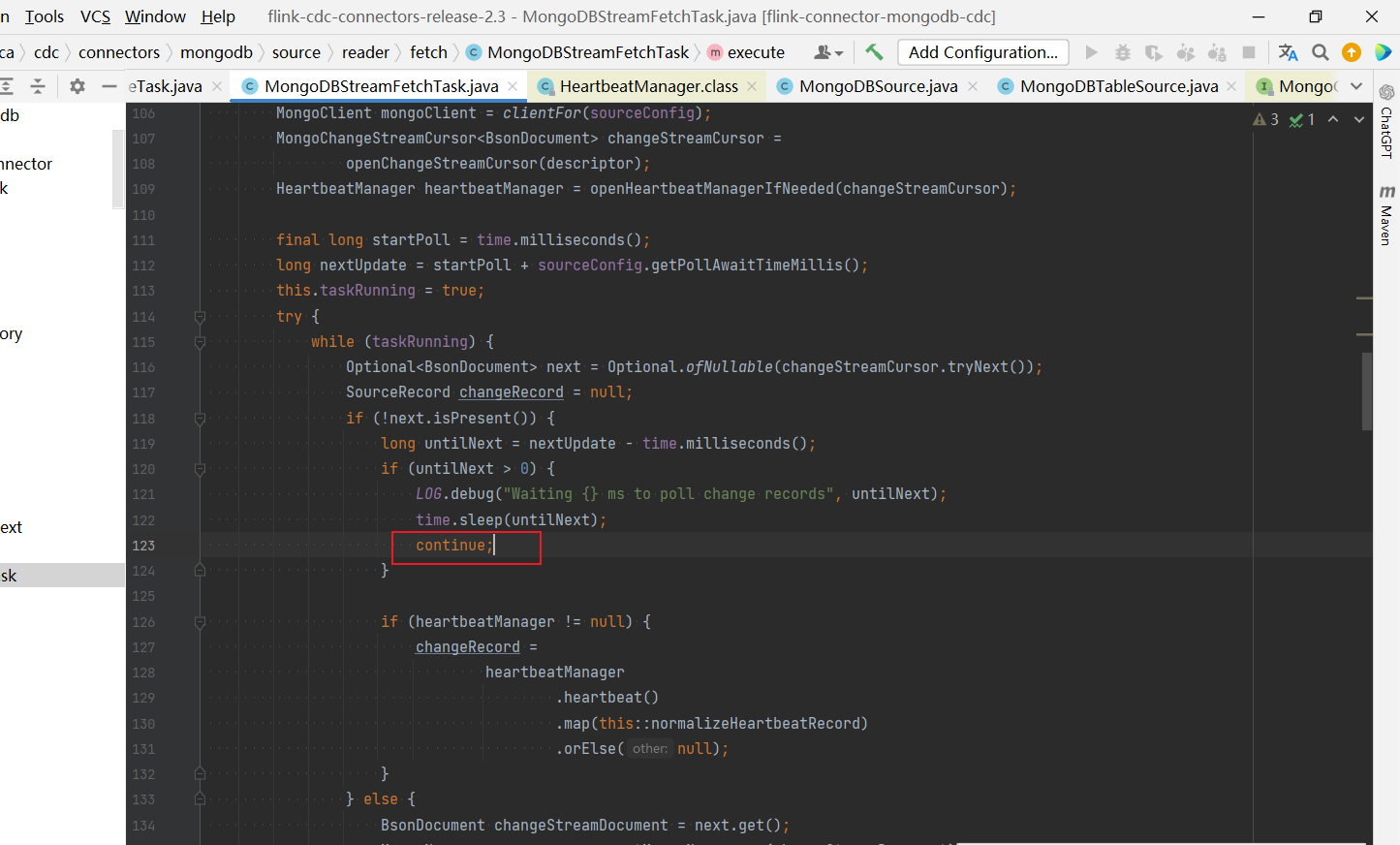

我发现如果一个source对应的collection没有数据变更,flink任务的checkpoint会卡住。看源码感觉和这一段代码有关,这个continue感觉比较疑惑,我的理解等待完成后应该继续判断心跳,往下游发送心跳记录?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您的描述和参考的知识库资料,这个问题可能与Flink CDC在处理MongoDB Change Stream时的行为有关。当一个source对应的collection没有数据变更时,Flink任务的Checkpoint可能会因为没有新的Change Events而等待较长时间,这似乎是您观察到“卡住”的现象。源码中的continue语句可能导致了在无变更事件时直接跳过当前循环,没有进一步处理或发送心跳记录,从而让您感到疑惑。

针对这种情况,有几点需要注意和考虑:

-

Change Stream空闲行为:MongoDB Change Stream在没有变更事件时会进入一种“空闲等待”状态,这是正常现象。Flink CDC在实现上需要正确处理这种空闲情况,确保即使在无数据变更期间也能维持作业的活性,比如定期发送心跳或者利用Resume Token进行Checkpoint的更新。

-

Checkpoint机制:Flink的Checkpoint机制依赖于数据流的推进来触发检查点的完成。如果上游数据源完全静默(无新事件),Checkpoint的确可能因为无法获取到新的checkpoint barrier而暂停。通常,Flink应用设计时应考虑到如何在数据不流动时也能健康地推进Checkpoint,例如通过配置合理的Idle Source Timeout来避免长时间无进展导致的问题。

-

心跳机制与数据流:心跳记录的发送是维护系统活性的重要手段,确保下游消费者感知到数据源仍然活跃。如果发现心跳机制未按预期工作,可能需要检查Flink作业配置或自定义Source逻辑中是否正确实现了心跳发送逻辑,特别是在数据源空闲时。

-

源码调整与优化建议:对于您提到的代码段,如果确认

continue逻辑影响了心跳发送或Checkpoint进度,可以考虑修改逻辑以保证在无数据变更时也能周期性执行心跳发送及Checkpoint相关的更新操作,保持作业的连续性和稳定性。

综上所述,要解决这一问题,建议从以下几个方面入手: - 确认并优化Flink作业的心跳发送逻辑,确保在无数据变更时也能定期发送心跳。 - 调整Checkpoint相关配置,如设置合理的超时时间,避免因长时间无数据流动而导致Checkpoint停滞。 - 检查并适配Flink CDC连接器的源码逻辑,必要时可考虑贡献代码改进以更好地处理数据源空闲场景。

请根据具体情况分析,并适当调整配置或代码逻辑,以达到期望的稳定运行效果。