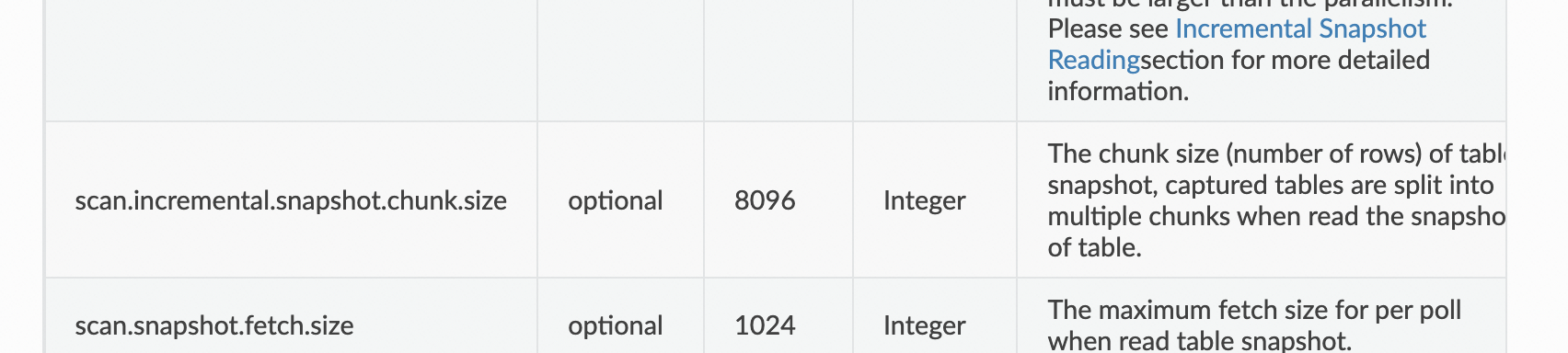

Flink CDC 2.0 提出了增量快照算法后,通过切片能够将 checkpoint 粒度降至 chunk, 并且 chunk 大小是用户可配置的,默认是 8096 条,用户可以将其调至更小,减轻 writer 的压力,减少内存资源的使用,提升下游写入存储时的稳定性,这个调整参数有谁知道吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

你已经用strarocks了,还需要其他db来干嘛能,你的olap用它就够了,不会是过去的那种,查mysql,业务不想改,你想把sr的结果写过去,此回答整理自钉群“Flink CDC 社区”

你已经用strarocks了,还需要其他db来干嘛能,你的olap用它就够了,不会是过去的那种,查mysql,业务不想改,你想把sr的结果写过去,此回答整理自钉群“Flink CDC 社区”