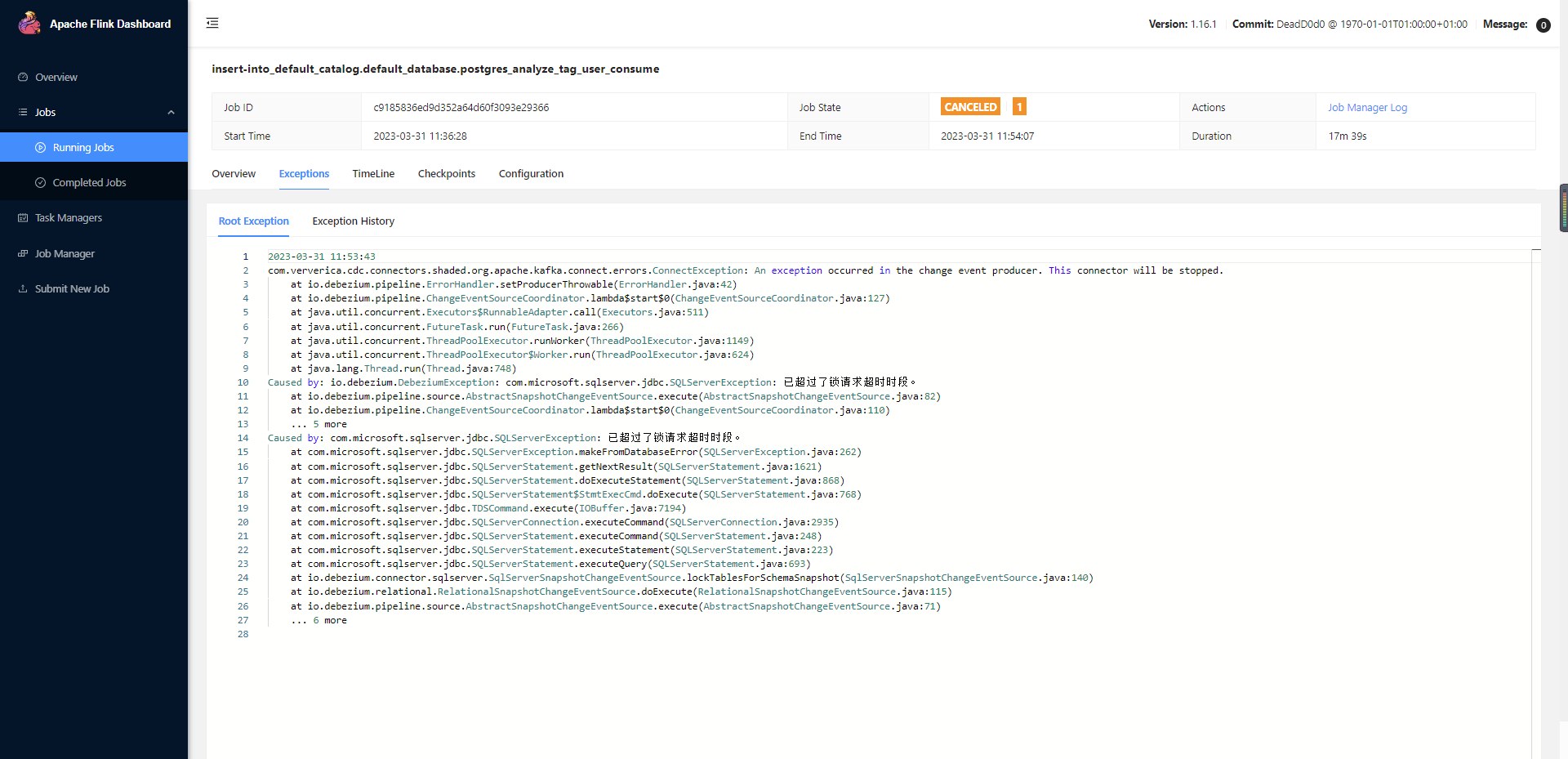

大佬们 有遇到这个问题么?通过CDC读取sqlserver实时向postgres写数据,一直报这个错,kill所有进程也还是报这个错。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,看起来您在尝试使用CDC(Change Data Capture)从SQL Server实时读取数据并写入PostgreSQL时遇到了持续的错误,即使终止所有相关进程问题依旧存在。虽然提供的参考资料没有直接针对此跨数据库同步的具体错误信息,但我们可以基于这些资料和通用的故障排查思路为您提供一些建议:

可能的配置不匹配:确保SQL Server版本与DTS或您使用的任何中间件支持的版本兼容,并且已正确配置以允许CDC功能。SQL Server CDC有特定的版本要求,并且需要相应的数据库设置。

目标端PostgreSQL配置:检查PostgreSQL侧是否已经按照要求设置了WAL级别、REPLICA IDENTITY等参数,以及max_wal_senders和max_replication_slots等系统参数是否足够。这些是启用Postgres CDC连接器的前提条件。

数据流异常处理:确认在数据传输过程中是否有异常处理机制,比如Flink作业是否正确配置了Source复用以避免不必要的带宽消耗,尤其是在数据量不大但带宽消耗大的情况。

检查SQL Server CDC配置:

验证PostgreSQL CDC连接器设置:

wal_level已设置为logical,并且相关表的REPLICA IDENTITY被设置为FULL。max_wal_senders和max_replication_slots的值大于当前使用数加上所需的slot数量。查看源到目标的数据转换逻辑:

监控与日志分析:

资源与权限检查:

故障隔离与重启:

如果以上步骤不能解决问题,建议提供更具体的错误信息或日志详情,以便进行更深入的诊断。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。