请帮忙看一下这个问题是什么?

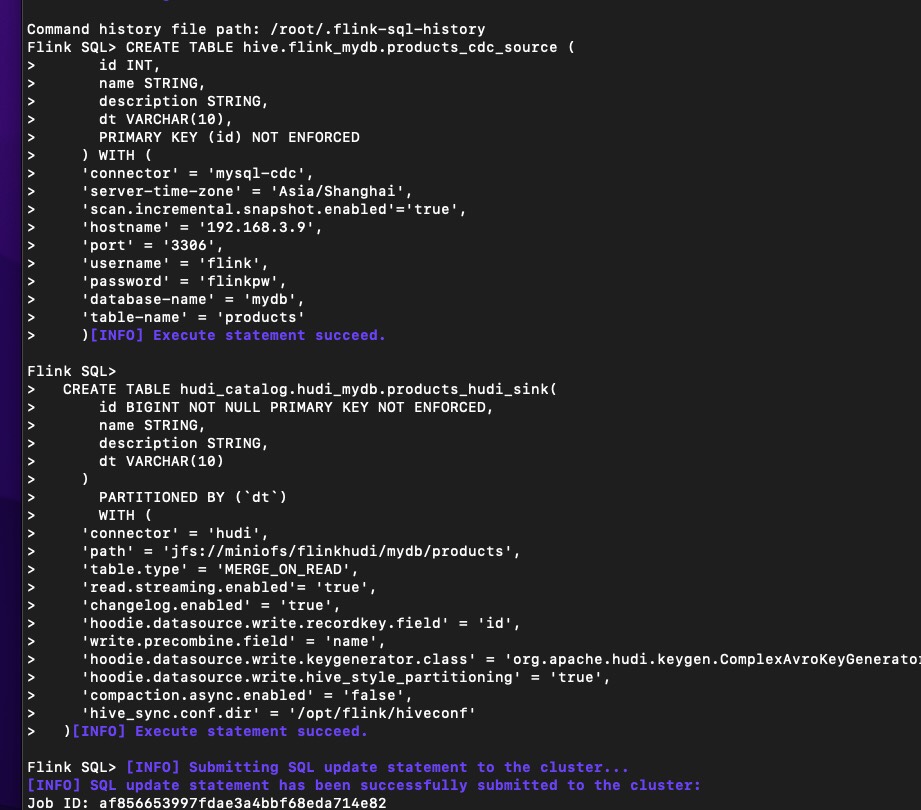

请教集成过flink cdc和hudi的大佬,我写了一个作业单cdc source,单hudi sink,用flink sql-clients提交作业后,hive里创建3张表,没有后缀的能读出来sink成功的记录,可是_ro和_rt后缀的表总是提示表定义错误,没有primary key或recordkey,可是定义表时这2个也都指定了的,show create 时recordkey有,primary key确实没有,为什么呢? file:///C:/Users/Admin/AppData/Roaming/DingTalk/227792554_v2/resource_cache/ac/acd81292b3455754b4e9221be9e3119b.jpg

file:///C:/Users/Admin/AppData/Roaming/DingTalk/227792554_v2/resource_cache/ac/acd81292b3455754b4e9221be9e3119b.jpg

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您的描述,您在使用Flink CDC Source与Hudi Sink集成时遇到了问题,特别是在Hudi表的_ro和_rt(即read optimized和realtime)表上遇到“表定义错误”,提示缺少primary key或recordkey。尽管您在创建表时已经指定了这两个关键属性,但在通过show create table命令查看时发现primary key缺失。

这里有几个可能的原因和解决方向:

-

Hudi DDL 语法检查:首先,请确保您在创建Hudi表时使用的DDL语法是正确的,特别是关于

PRIMARY KEY和RECORDKEY的定义。Hudi要求实时表(即带有_rt后缀的表)必须明确指定一个字段作为PRIMARY KEY,而不仅仅是RECORDKEY。请确认DDL中是否正确地使用了PRIMARY KEY关键字,并且指定的列名无误。 -

Flink SQL映射问题:如果您的Flink SQL在转换数据到Hudi时没有正确映射字段,可能会导致Hudi在内部处理时无法识别出预期的主键或记录键。请检查您的SQL语句,确保源数据中的相应字段被正确映射到了Hudi表定义中指定的

RECORDKEY和PRIMARY KEY字段。 -

Hudi版本兼容性:不同的Hudi版本可能对DDL的要求有细微差别,尤其是对于主键的支持。请确认您使用的Hudi版本与Flink CDC及Hudi Connector是否完全兼容,并查阅相关版本的官方文档以获取正确的表定义示例。

-

Hive Metastore同步问题:有时,Hudi表元数据与Hive Metastore之间的同步可能出现延迟或不一致。尝试重新启动Hudi服务或手动触发元数据同步,然后再次检查表定义。

-

日志与错误信息分析:查看Flink作业运行的日志以及Hudi的相关日志,这些日志通常会提供更详细的错误信息,帮助定位问题所在。特别注意是否有任何异常或警告信息与表结构、字段映射或主键定义有关。

-

Schema Evolution:如果您在表的生命周期中修改了表结构,确保所有变更都正确反映到了Hudi的表定义中,包括但不限于主键和记录键的调整。

如果以上建议仍不能解决问题,建议直接查看Hudi的官方文档或社区论坛,那里可能有其他用户遇到过类似的问题并分享了解决方案。同时,考虑提交一个详细的问题报告到相应的GitHub项目页面,附上您的表定义、Flink SQL以及完整的错误日志,以便获得更专业的技术支持。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。