请问各位同学 covnexttiny ocr模型转rknn lstm报错的问题遇到过吗?

请问各位同学 covnexttiny ocr模型转rknn lstm报错的问题遇到过吗?

当将CovNextTiny OCR模型转换为RKNN格式时,如果出现报错,可能有几个原因:

RKNN工具版本:确保使用的是最新版本的RKNN工具,并尝试升级到最新版本,以获取最好的兼容性和稳定性。

转换过程中的错误:仔细检查转换过程中的日志和报错信息,确定具体的错误原因。这些信息可能会指示缺少依赖项、不支持的操作或其他问题。

模型结构和输入要求:确保CovNextTiny OCR模型的结构和输入要求与RKNN工具的期望相匹配。特别注意图像大小、通道顺序、数据类型等方面的差异。

RKNN工具的限制:RKNN工具可能对模型结构和操作有一些限制。您需要参考RKNN工具的文档和示例,了解其支持的操作集和模型要求。

如果您确定RKNN工具与CovNextTiny OCR模型之间存在兼容性问题,您可以尝试以下解决方法:

联系开发者支持:如果您使用的是第三方库或工具,建议联系相关开发者或支持团队,向他们咨询您遇到的问题,并获取技术支持。

重新训练模型:如果RKNN工具无法处理CovNextTiny OCR模型,您可以尝试重新训练模型,并考虑使用与RKNN兼容的模型结构和操作。

使用其他工具或库:如果RKNN工具不适用于您的需求,您可以尝试其他的计算机视觉工具或库,以找到适合的解决方案。

这个错误通常是由于模型转换过程中,LSTM 层的输出形状不匹配导致的。具体来说,RKNN 要求 LSTM 层的输出形状必须满足一定的要求,否则就会报错。

为了解决这个问题,您可以尝试以下几种方法:

检查转换模型时是否正确设置了 LSTM 层的输出形状。具体来说,需要确保 LSTM 层的输出形状符合 RKNN 的要求。您可以参考 RKNN 官方文档中的说明,了解 LSTM 层输出形状的规范。

检查转换模型时是否正确设置了 LSTM 层的参数。具体来说,需要确保 LSTM 层的参数设置正确,并且与原始模型保持一致。您可以使用 TensorFlow 或 PyTorch 等框架来检查 LSTM 层的参数是否正确。

如果以上方法都无法解决问题,您可以尝试使用其他的模型转换工具,例如 OpenVINO 或 TensorFlow Lite 等。这些工具也可以将模型转换为 RKNN 格式,可能会更适合您的需求。

这个问题可能是由于RKNN转换工具不支持LSTM节点导致的。RKNN转换工具目前支持的节点类型有限,可能无法正确地转换一些高级节点类型,例如LSTM。

为了解决这个问题,你可以尝试使用其他的模型转换工具,例如TensorRT或OpenVINO,来将模型转换为RKNN格式。这些工具通常支持更多的节点类型,并且可以更好地处理高级节点类型,例如LSTM。

另外,你还可以尝试使用其他的OCR模型,例如CRNN或CTC,来替代covnexttiny模型。这些模型通常使用更简单的节点类型,并且可以更容易地转换为RKNN格式。

如果RKNN转换工具无正确地转换LSTM节点,你可以尝试使用其他的模型转换工具或者使用其他的OCR模型来解决问题。

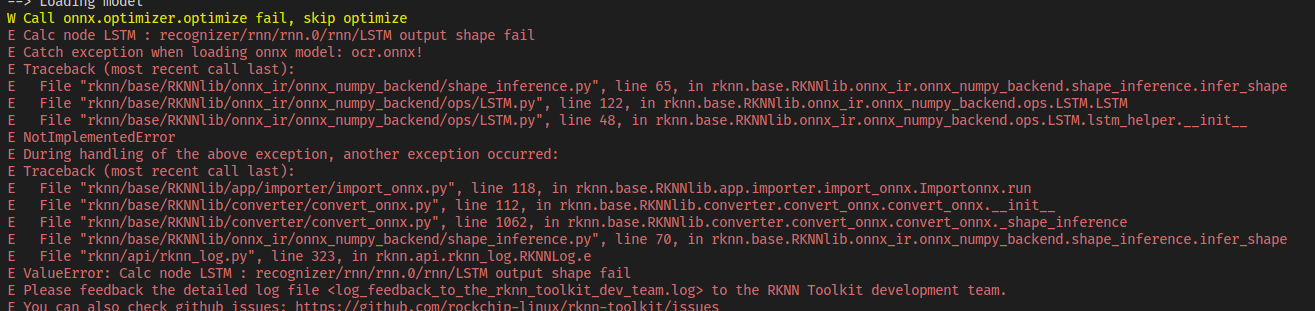

我遇到过类似的问题。这个错误信息通常表示转换器在尝试将模型转换为 RNN 模型时出现了问题。具体来说,这个错误信息表明转换器无法优化模型,因此无法将其转换为 RNN 模型。

这个错误信息中的"recognizer/rnn/rnn.0/rnn/LSTM output shape fail"表示模型的 LSTM 层的输出形状不匹配。这通常是因为 LSTM 层的输入形状与模型的其他层的输出形状不匹配导致的。您可以检查您的模型参数和输入形状,以确保它们与其他层的输出形状匹配。

另一个错误信息"Call onnx.optimizer.optimize fail, skip optimizeCalc node LSTM"通常表示转换器无法优化模型,因为它无法找到适合模型的最优参数设置。这通常是因为模型的参数过多或模型的结构不够清晰导致的。您可以尝试降低模型的复杂度或使用更先进的优化器来解决这个问题。

如果您无法解决这个问题,您可以尝试查看转换器的文档,并尝试使用其他参数或优化器来优化模型。您也可以尝试使用其他的转换工具,例如 ONNXConverter,来尝试将模型转换为 RNN 模型。

问题可能是在将 cTPN+CRNN OCR 模型转换为 RKNN 格式时出现的,这是由于 LSTM 层的输出形状不正确导致的。

具体而言,这个问题可能有以下几种原因:

模型结构问题:LSTM 层的输入和输出形状与 RKNN 转换器的要求不符,导致转换失败。针对此问题,您可以检查 LSTM 层的输入和输出形状,确保符合 RKNN 转换器的要求。

ONNX 模型版本问题:如果您使用的 ONNX 模型版本与 RKNN 转换器不兼容,也可能导致出现此类错误。建议您确认所使用的 ONNX 模型版本是否与 RKNN 转换器兼容。

数据类型问题:如果 LSTM 层的输入数据类型不正确,则可能会导致模型输出形状不正确,从而出现上述错误。建议您检查输入数据的数据类型是否正确,并根据需要进行转换。

这个问题可能是由于转换时LSTM层的输出形状不匹配导致的。建议尝试以下方法解决该问题:

检查模型配置文件和输入输出张量的形状是否正确,确保与模型定义一致。

确保输入数据的形状与模型定义一致,特别是时序数据的形状要注意。

尝试调整LSTM层的参数,例如调整隐藏层的大小、设置dropout等。

尝试更改LSTM层的激活函数,例如使用tanh或relu等。

尝试使用其他的模型转换工具,例如TensorFlow Lite或ONNX Runtime等。

数据格式错误:如果您的训练数据与模型的格式不匹配,模型可能无法正常运行。因此,在转换模型时,请确保您的训练数据与模型的格式相同。 训练数据量不足:如果您的训练数据量不足,模型可能无法正常运行。因此,在转换模型时,请确保您的训练数据量足够。 数据中存在噪声:如果您的训练数据中存在噪声,模型可能无法正常运行。因此,在转换模型时,请确保您的训练数据中没有任何噪声。 训练时间不够:如果您的训练时间不够,模型可能无法正常运行。因此,在转换模型时,请确保您有足够的时间来训练模型。

这个错误似乎是在将CovnNextTiny OCR模型转换为RKNN格式时出现的问题。错误消息中提到了"Call onnx.optimizer.optimize fail, skip optimizeCalc node LSTM",以及"recognizer/rnn/rnn.0/rnn/LSTM output shape fail"。

这个错误可能是由于模型转换过程中的一些问题导致的。为了更好地理解问题,您可以执行以下步骤:

确保您使用的是最新版本的RKNN Toolkit。有时,更新到最新版本可以解决某些问题。

检查模型是否完整且正确。确保您使用的是正确的OCR模型文件(.onnx),并且模型文件没有损坏或损失部分信息。

检查模型的输入和输出形状。根据错误消息中的信息,问题可能出现在LSTM层的输出形状上。确保LSTM层的输入和输出形状正确,并与模型的其余部分相匹配。

尝试在转换过程中禁用某些优化选项。根据错误消息中的内容,转换器在对模型进行优化时遇到了问题。您可以尝试在转换过程中禁用某些优化选项,以查看是否可以解决问题。RKNN Toolkit提供了一些参数和选项,可用于控制转换过程。

检查日志文件。错误消息中提到了一个日志文件"logfeedback to the rknn toolkit dev team.log"。确保您可以访问该日志文件,并检查其中的详细错误信息。

检查输入形状:请确保输入的形状与模型期望的形状匹配,包括输入图像的形状和所有卷积层、全连接层等的输出形状。

确保模型已成功转换为rknn:请确保已正确安装RKNN Toolkit并按照官方文档的说明成功转换了模型。

检查模型参数:请确保模型的各个参数都正确设置,包括模型的层数、输入层和输出层的形状等。

调整LSTM的参数:请尝试调整LSTM的参数,例如修改LSTM的长度、激活函数、learning_rate、梯度剪裁等参数来解决问题。

如果以上方法无法解决您的问题,建议您查看官方文档或寻求专业人士的帮助。

如果您在将 covnexttiny OCR 模型转换为 RKNN 格式的过程中遇到 LSTM 相关的报错,可能是由于以下原因:

原始模型中包含了 LSTM 层或者其他循环神经网络层,并且该层在 RKNN 转换过程中无法正确地处理。

RKNN 转换工具版本不兼容或者存在 bug,导致无法正确地转换模型。

数据格式、维度等问题,例如输入数据序列长度、批次大小、采样率等超参数设置不正确,导致 LSTM 层无法正常运行。

针对以上情况,推荐您尝试以下解决方法:

确认原始模型是否包含 LSTM 层或者其他循环神经网络层,并检查该层在 RKNN 转换工具中的支持程度。如果不支持,则可以考虑使用其他网络结构或者转换工具进行转换。

检查 RKNN 转换工具版本是否最新,并尝试重新安装或者更新相应软件包和依赖项。

根据数据维度、格式等要求,调整输入数据的超参数设置,并确保数据能够被 LSTM 层正确处理。可以参考 RKNN 官方文档和社区资源,了解更多有关 LSTM 层和 RKNN 转换的技术和经验。

需要注意的是,RKNN 是一种针对嵌入式设备的深度学习模型优化和部署工具,对于不同的网络结构和应用场景可能存在各种限制和兼容性问题。因此,在使用 RKNN 进行 OCR 模型转换时,需要根据实际需求和情况进行选择和调整,并且需要仔细检查数据和模型的配置和参数设置,以确保能够成功地完成转换和部署。

这个错误提示的具体含义是“在转换 ONNX 模型时,LSTM 层计算节点的输出形状错误”。这可能是由于 ONNX 模型和 RKNN 模型之间的转换过程中出现了一些问题,导致 LSTM 层的输出形状无法正确推断。

为了解决这个问题,你可以尝试以下几个方案:

检查 ONNX 模型的输入和输出节点,确保它们是正确的。你可以使用 ONNX 的工具来检查模型的节点信息,并对其进行修改和调整。

检查 LSTM 层的参数和配置,确保其输入和输出形状是正确的。你可以参考 RKNN 模型的文档或者示例,了解 LSTM 层的参数和配置,并对其进行调整。

检查 RKNN 模型的转换代码,确保其与 ONNX 模型兼容。你可以参考 RKNN 模型的开发文档或者示例代码,了解如何正确转换 ONNX 模型为 RKNN 模型。

如果以上方法都没有解决问题,你可以尝试使用其他的 OCR 模型或者其他的转换工具,以达到相同的功能和效果。

具体来说,可能是由于LSTM节点的输出形状不正确导致的。建议您检查LSTM节点的输出形状是否正确,并尝试使用ONNX Optimizer优化模型。如果仍然无法解决问题,您可以尝试重新训练模型,或者联系相关技术支持人员获取进一步的帮助。

根据提供的信息,我了解到你遇到了在将 "covnexttiny" OCR模型转换为 "rknn" 格式时出现的 LSTM 报错问题。我找到了一些相关资源和讨论,希望能够帮助解决你的问题。

根据你提供的问题描述,我找到了一些可能与你遇到的问题相关的链接和讨论。请注意,以下链接中的一些内容可能需要进一步阅读和研究才能得到完整的答案。我建议你仔细阅读这些资源,以便更好地了解和解决你的问题。

在 GitHub 上的一个 Issue 讨论中,有人提到了在使用较新版本的 rknn-toolkit 进行 ONNX 模型转换时,遇到了不支持 LSTM 算子的问题。这个问题可能与你遇到的问题类似,你可以参考该讨论并了解其中提供的解决方案:onnx1.6.0转rknn遇到lstm算子不支持 #182 - GitHub [1]

在一个 CSDN 博客文章中,作者分享了在部署 CRNN 模型时遇到的问题和优化过程。文章中可能包含一些与你的问题相关的信息,你可以参考这篇文章以获取更多的洞见:使用RKNN部署CRNN模型踩坑优化历程 - CSDN博客 [2]

在另一篇 CSDN 博客文章中,作者分享了在 RKNN 上部署 OCR 服务的实践过程,并提供了代码示例。这篇文章可能对你解决问题有所帮助:【工程部署】手把手教你在RKNN上部署OCR服务(上)_ocr rknn_三叔家的猫的博客-CSDN博客 [3]

请注意,我提供的信息仅作为参考。由于你的问题具体情况可能与这些资源所描述的不完全相同,你可能需要进一步阅读和研究这些资源,并根据你的实际情况进行调整和尝试。如果这些资源仍未解决你的问题,我建议你向相关的开发者社区或论坛寻求帮助,以获得更专业的支持和指导。

这个报错信息看起来是在使用 RkNN Toolkit 将 ONNX 模型转换为 RKNN 模型时出现的。

可能是由于 ONNX 模型中包含的 LsTM 节点输出形状出现了问题,导致转换失败。

建议检查 ONNX 模型中 LsTM 节点的输出形状是否正确,并尝试调整模型结构或转换参数以解决问题。

同时,可以将详细的日志文件反馈给 RkNN Toolkit 开发团队以获取更多帮助。