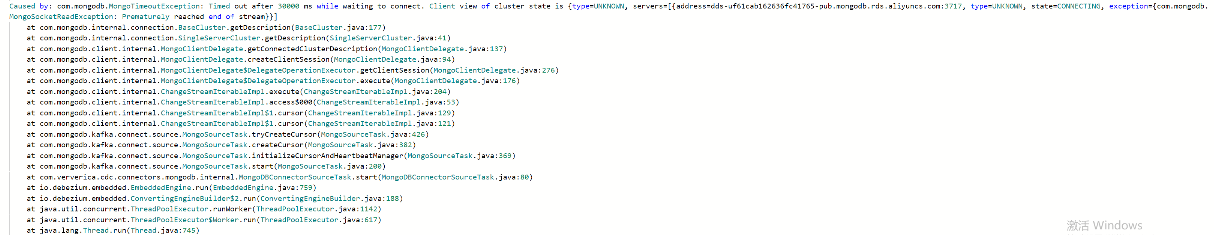

flinkcdc读取mongo每隔20天左右会出现这个问题,请问下应该怎么排除和解决呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Flink CDC 从 MongoDB 读取数据时每隔 20 天左右出现问题

可能的排除和解决方法:

检查 MongoDB 日志以查找任何错误或警告消息。

特别注意与 Flink CDC 连接器相关的消息。

检查 Flink 任务管理器日志以查找任何错误或警告消息。

特别注意与 MongoDB 连接器相关的消息。

确保 Flink CDC 连接器使用正确的 MongoDB 连接设置,包括主机、端口、用户名和密码。

尝试增加连接池大小和重试次数。

确保 Flink 并行度与 MongoDB 分片数相匹配。

如果并行度太高,可能会给 MongoDB 造成过大压力。

检查 MongoDB 是否在繁忙时间遇到高负载。

如果是这样,请尝试在负载较低的时间运行 Flink CDC 作业。

确保 Flink 检查点配置正确,并且检查点间隔不长。

过长的检查点间隔可能会导致数据丢失。

检查 MongoDB 复制延迟是否过高。

高复制延迟可能会导致 Flink CDC 无法及时读取数据。

检查是否有 Flink CDC 连接器的更新版本。

更新的版本可能包含针对此问题的修复程序。

尝试使用 Flink SQL 查询 MongoDB 数据,而不是使用 Flink DataStream API。

Flink SQL 可能更稳定,并且可能能够解决此问题。

如果上述步骤均无法解决问题,请联系 Flink 社区寻求帮助。

Flink 社区可能能够提供额外的见解或解决方案。

其他提示:

启用 Flink CDC 连接器的日志记录,以便在出现问题时获得更多详细信息。

使用 Flink 监控工具(如 Flink Web UI)监控 Flink 作业,并查找任何异常情况。

定期备份 MongoDB 数据,以防数据丢失。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。