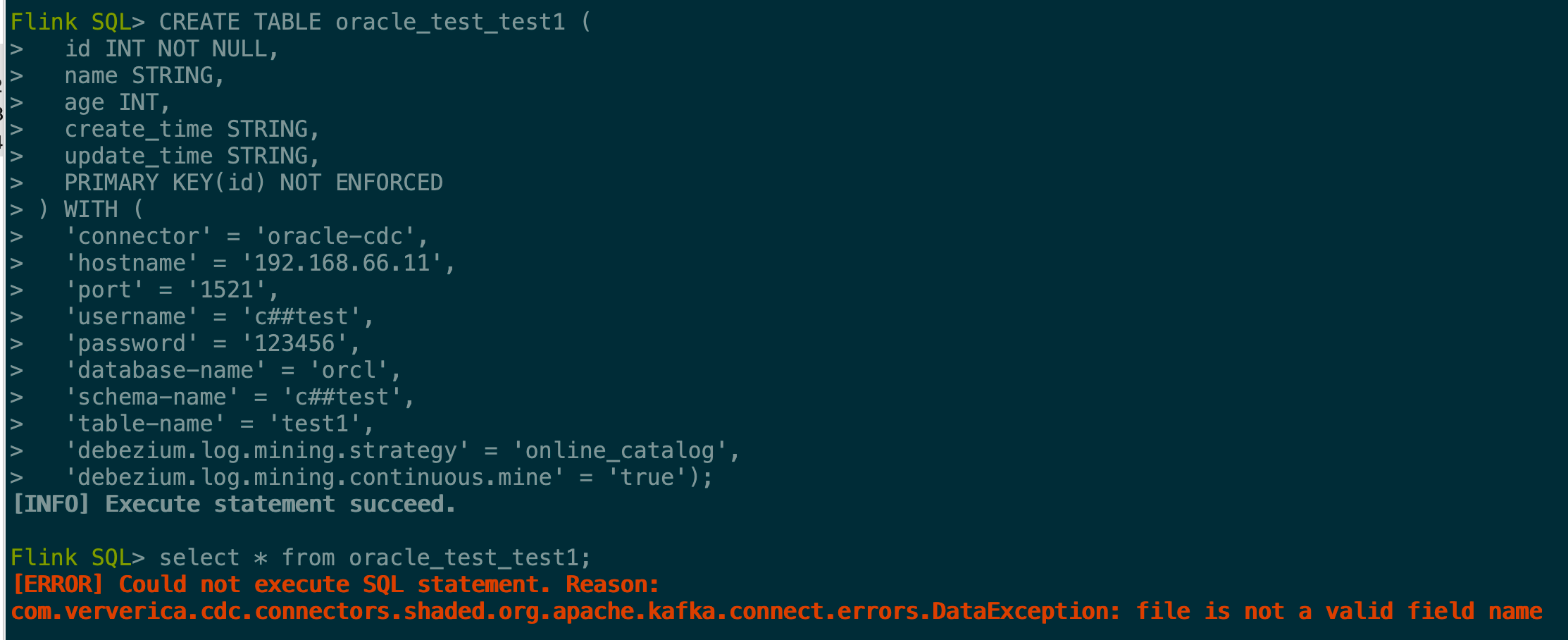

大佬们,flinkcdc sql连接oracle12c报这种问题是原因呢?stream api没有这种问题,讲道理跟kafka没有什么关系呗只要源端有数据变动就会报这种错误,flink1.16,flinkcdc2.3

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到Flink CDC SQL连接Oracle 12c时出现错误,且Stream API未出现问题的情况,这可能是由于配置或兼容性问题导致的。虽然直接与Kafka无关,但确保数据源到Flink作业的连通性和配置正确性仍然关键。根据您的描述和提供的知识库资料,以下是一些可能的原因及建议:

JDBC驱动兼容性:请确认使用的Flink CDC版本是否完全兼容Oracle 12c的JDBC驱动。不兼容的驱动可能导致连接不稳定或读取数据时出错。考虑更新至最新稳定版的JDBC驱动或检查Flink CDC的发行说明中关于Oracle支持的详细信息。

网络与连接参数:检查连接Oracle的参数设置(如-oracle-conf hostname=127.0.0.1 -oracle-conf port=1521等),确保数据库地址、端口、用户名、密码以及数据库名和模式名均正确无误。此外,如果使用了特定的网络配置或自建DNS,请参照之前提到的解决方法,确保没有域名解析延迟等问题影响连接稳定性。

表结构与权限:确认所尝试访问的Oracle表结构是否符合Flink CDC的要求,特别是当使用SQL接口并指定包含的表时(如-including-tables "tbl1|test.*")。同时,检查Oracle用户是否有足够的权限来读取这些表的数据。

Flink配置调整:如果问题持续存在,考虑调整Flink作业的配置,比如检查checkpoint间隔是否合理,以及是否需要调整与Oracle连接相关的超时设置等。适当增加日志级别可以帮助诊断问题所在。

特殊字符与编码:在连接字符串或表名中,避免使用特殊字符或确保它们被正确转义,因为这有时会导致隐秘的连接问题。

Debezium属性配置:如果使用Debezium作为CDC组件,确保其配置正确以适应Oracle 12c的特性,例如处理大数字和十进制类型的方式,可以通过设置Debezium属性来优化,如bigint.unsigned.handling.mode=long 和 decimal.handling.mode=double。

如果以上步骤不能解决问题,建议查看Flink和Flink CDC的日志输出,寻找更具体的错误信息进行进一步分析。同时,考虑到您使用的是Flink 1.16和Flink CDC 2.3,也请关注这两个组件的官方文档和已知问题列表,看是否有已知的兼容性问题或bug报告。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。