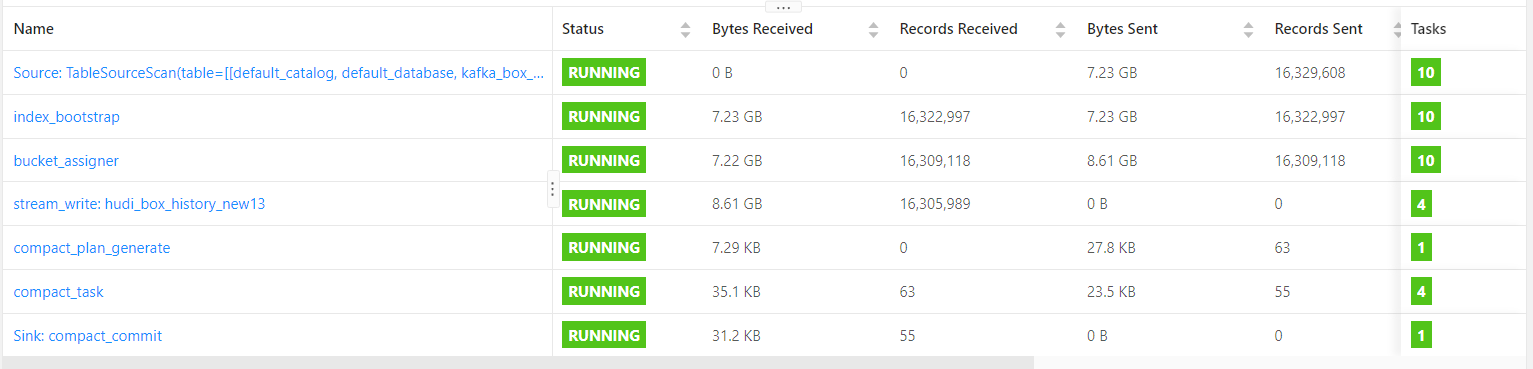

Records Send 和 Received 跟我kafka中的offset对不上是为啥 比offset多很多

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Kafka中,Records Send(发送的记录数)和Received(接收的记录数)与offset不匹配,尤其是比offset多很多的情况,可能涉及到几个关键因素:

消息批处理:Kafka客户端在生产消息时,默认会采用批量发送模式。这意味着多个消息会被打包成一个批次(Batch)进行发送,以提高效率。因此,一条发送请求可能包含了多条消息,导致发送次数少于实际的消息条数,但监控指标如Records Send是按批次统计的,故而可能出现比逐条消息计数(如通过offset直接累加)要少的情况。

监控指标差异:如果提到的Received是指消费者端接收到的消息数量,那么这个数字可能包含了重试接收的消息、或者是因为消费者组Rebalance导致的重复消费。特别是在有消费者故障恢复或重新平衡场景下,某些消息可能会被多次拉取和处理,从而使得Received的数量超过实际的唯一消息数量(即offset的增长数量)。

监控数据延迟或计算方式:监控系统在收集和展示这些指标时可能存在时间延迟,或者其计算逻辑与直接从Kafka日志文件中读取的offset增量有所不同。例如,监控平台上的统计数据可能基于采样、估算或其他汇总逻辑,而非精确到每条消息的实时计数。

消息丢失与重试:在消息传输过程中,如果网络不稳定或服务端出现问题,部分消息可能需要重试发送,这也会造成发送计数与最终确认的offset之间存在差异。

监控配置问题:确保监控工具或Prometheus配置正确地反映了你所关心的度量标准。比如,是否正确配置了采集频率、是否考虑了所有分区等。

综上所述,若发现Records Send或Received与offset对不上且数量差异较大,建议检查消息批处理设置、监控系统的具体实现细节、以及消费端的重试逻辑和Rebalance行为,以定位具体原因并采取相应优化措施。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。