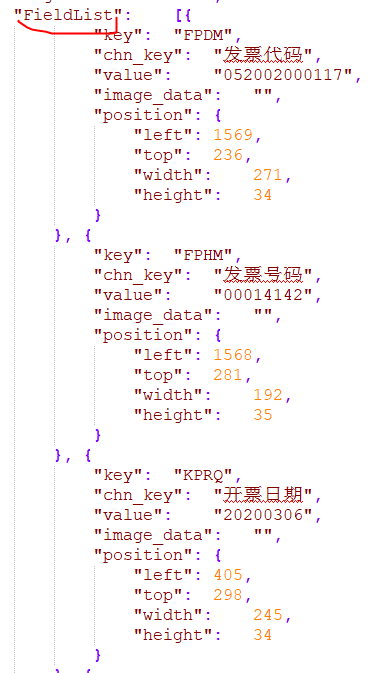

因为要把ARRAY 按 ROW 拆成多行入库。但对Kafka来说是一条JSON消息 ,只是某个Json属性映射成了ARRAY<ROW<>> 类型。 类似于这种格式:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要将包含嵌套JSON数组的消息从Kafka中读取并解析,最终将数组的每个元素作为单独的行插入到数据库中,您可以采用以下步骤操作:

步骤一:配置Kafka Connect任务,使用org.apache.kafka.connect.transforms.Flatten$Key和org.apache.kafka.connect.transforms.Flatten$Value SMTs来展平嵌套的JSON结构。这会将嵌套的字段提升到顶级,便于后续处理。

# Kafka Connect配置示例

transforms=FlattenKey,FlattenValue

transforms.FlattenKey.type=org.apache.kafka.connect.transforms.Flatten$Key

transforms.FlattenValue.type=org.apache.kafka.connect.transforms.Flatten$Value

步骤二:如果SMT不能直接满足需求,可以开发自定义的Kafka Connect Transformer或Sink Connector,实现特定的逻辑来解析ARRAY>类型的数据,并生成多条消息。

步骤一:设置Flink作业以消费Kafka中的消息,使用DeserializationSchema来解析JSON数据。

Properties props = new Properties();

props.setProperty("bootstrap.servers", "your.bootstrap.servers");

FlinkKafkaConsumer<String> consumer = new FlinkKafkaConsumer<>("your-topic", new JSONDeserializationSchema(), props);

步骤二:在Flink DataStream API中,使用flatMap操作来解析嵌套的JSON数组,为数组中的每个元素生成一个新的DataStream。

DataStream<String> stream = env.addSource(consumer);

DataStream<YourDataType> flattenedStream = stream.flatMap(new FlatMapFunction<String, YourDataType>() {

@Override

public void flatMap(String value, Collector<YourDataType> out) {

// 解析value中的JSONArray,对每个元素调用out.collect(YourDataType)

}

});

步骤三:将处理后的DataStream写入目标数据库,例如通过JDBC Sink或其他连接器。

通过上述方法,您可以有效地将嵌套JSON数组格式的Kafka消息拆分成多个记录,进而分别存储到数据库中。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。