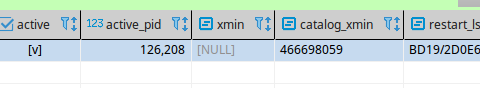

大家有遇到过pg cdc,任务停止之后,slot还处于active状态吗?

然后逻辑复制就出问题了,新的任务也没法通过pg cdc同步数据了

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您描述的问题,逻辑复制出现故障,并且新的任务无法通过pg_cdc(假设这里指的是PostgreSQL的变更数据捕获Change Data Capture功能)同步数据。针对这一情况,我们可以按照以下步骤进行排查和解决:

问题诊断

-

检查错误日志:

- 首先,查看订阅者服务器的日志文件,寻找与冲突相关的错误信息。这将帮助确定是否因数据约束违背导致复制停止。

-

确认主从切换状态:

- 如果近期进行了维护操作或遇到大压力任务,确认是否临时关闭了主从切换功能。关闭此功能可能导致预期外的主节点异常未被处理,影响复制流程。

-

检查WAL日志设置:

- 确保源数据库的WAL日志配置正确,wal_level设置为logical,且保留时间满足DTS要求,以避免因日志不足导致的数据不一致或丢失。

-

逻辑复制槽状态:

- 检查逻辑复制槽是否正常工作,特别是在执行过主备切换后,需确保Logical Replication Slot Failover已开启并配置正确。

-

数据冲突处理:

- 若发现冲突,根据日志提示使用

pg_replication_origin_advance()函数手动跳过冲突事务。确保提供正确的node_name和lsn值来定位到冲突点。

- 若发现冲突,根据日志提示使用

-

检查pglogical扩展:

- 确认pglogical扩展是否正确安装和配置。任何对发布或订阅的不当修改都可能影响数据同步。

-

数据对象变更:

- 若在同步期间有DDL操作,特别是涉及表结构变化,需检查是否已按要求执行了

ALTER TABLE ... REPLICA IDENTITY FULL;命令以保持同步一致性。

- 若在同步期间有DDL操作,特别是涉及表结构变化,需检查是否已按要求执行了

解决措施

-

恢复主从切换:如果之前关闭了主从切换功能,完成维护或任务后应重新启用,以保证高可用性。

-

解决冲突:根据日志中的冲突详情,采取相应措施解决冲突,如调整数据或使用

pg_replication_origin_advance()跳过特定事务。 -

调整WAL配置:确保WAL日志配置符合DTS或其他同步工具的要求,必要时延长日志保留时间。

-

修复复制槽:如果逻辑复制槽出现问题,参考文档进行修复或重建。

-

验证pglogical配置:检查并修正pglogical的发布、订阅配置,确保网络地址、端口等参数正确无误。

注意事项

-

备份数据:在进行任何配置更改或修复操作前,请确保做好数据备份,以防操作失误导致数据丢失。

-

监控与日志:持续监控系统日志,以便及时发现并解决问题。

通过上述步骤,您可以系统地排查并尝试解决逻辑复制中断的问题。如果问题依旧存在,建议进一步查阅官方文档或联系技术支持获取更专业的帮助。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。