我的这个上来就报元数据抓取异常是什么情况呀?

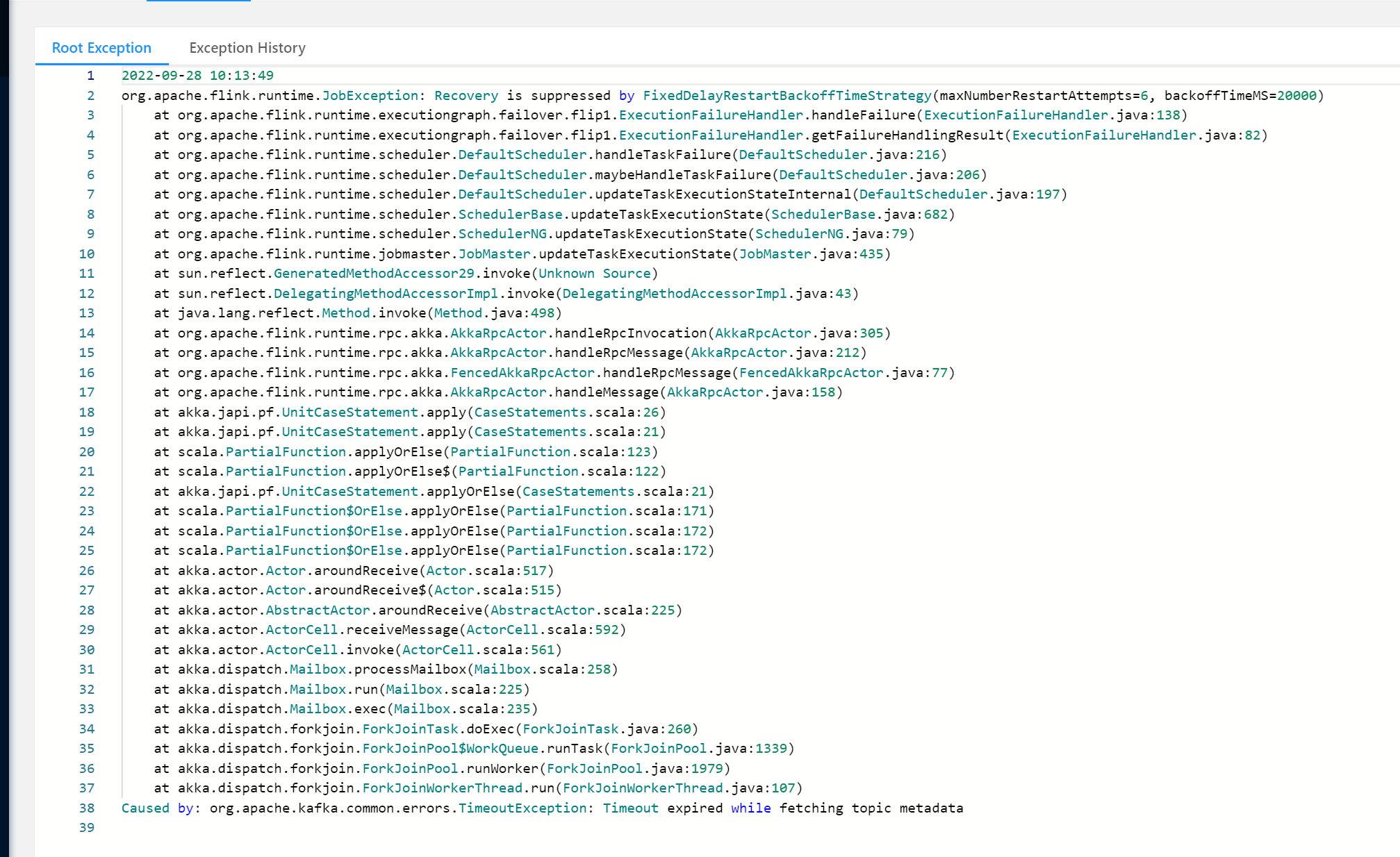

我通过Kafka命令是可以消费到Kafka数据的,但是在代码中就报这个错误,和某个节点发生GC有关系吗?TimeoutException: Timeout expired while fetching topic metadata

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

遇到TimeoutException: Timeout expired while fetching topic metadata错误,通常并不直接关联到某个节点的GC(垃圾回收)问题,而是与网络连接、Kafka Broker的可达性、以及客户端配置有关。根据提供的知识库资料,以下是一些可能的原因及解决步骤:

-

网络连通性检查:

- 确保你的应用服务器能够访问到Kafka集群的所有Broker节点。可以尝试使用

telnet或nc命令检查与Kafka Broker地址的TCP连接是否畅通。 - 检查是否有网络策略(如防火墙、安全组规则)阻止了连接。

- 确保你的应用服务器能够访问到Kafka集群的所有Broker节点。可以尝试使用

-

Kafka元数据获取超时:

- 超时可能是因为Kafka客户端在初始化时无法及时从Broker获取到topic的元数据信息。这可能是由于Broker响应慢、网络延迟高或者客户端配置的元数据请求超时时间过短。

- 检查并适当调整客户端配置中的

request.timeout.ms和metadata.max.age.ms参数,增加请求超时时间和元数据的最大更新间隔。

-

用户名和密码验证:

- 报错中提到的“probably the user name or password is wrong”提示,需要确认客户端代码中使用的SASL认证信息是否正确无误。确保

bootstrap.servers、sasl.jaas.config等配置项设置正确。

- 报错中提到的“probably the user name or password is wrong”提示,需要确认客户端代码中使用的SASL认证信息是否正确无误。确保

-

DNS解析问题:

- 如果Kafka Broker地址使用的是域名而非IP,确保应用服务器能够正确解析这些域名。参考文档中关于如何为Flink作业配置域名解析服务的部分,如果适用,也应为你的应用配置相应的DNS解析方案,比如使用阿里云云解析PrivateZone。

-

Kafka Broker状态检查:

- 使用Zookeeper工具查看Kafka Broker的注册情况,确认所有预期的Broker ID都在

/brokers/ids路径下,并且它们的Endpoint信息是可达的。特别注意listener_security_protocol_map中的配置,确保客户端能通过正确的协议和端口访问。

- 使用Zookeeper工具查看Kafka Broker的注册情况,确认所有预期的Broker ID都在

-

客户端日志分析:

- 详细查看应用的日志,特别是Kafka客户端初始化阶段的日志,可能会提供更多关于为何元数据获取失败的具体原因。

-

资源与性能监控:

- 虽然直接关联不大,但频繁的GC活动确实可能影响应用的响应速度,间接导致超时。监控应用服务器的CPU、内存使用情况,以及GC行为,确保资源充足且JVM调优得当。

综上所述,此错误主要指向网络、配置或Kafka集群状态方面的问题,而不是直接由单个节点的GC引起。通过上述步骤逐一排查,应该能找到问题所在并进行相应解决。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

问答分类:

问答地址:

开发者社区

>

大数据与机器学习

>

实时计算 Flink

>

问答

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

收录在圈子:

+ 订阅

实时计算 Flink 版(Alibaba Cloud Realtime Compute for Apache Flink,Powered by Ververica)是阿里云基于 Apache Flink 构建的企业级、高性能实时大数据处理系统,由 Apache Flink 创始团队官方出品,拥有全球统一商业化品牌,完全兼容开源 Flink API,提供丰富的企业级增值功能。

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理