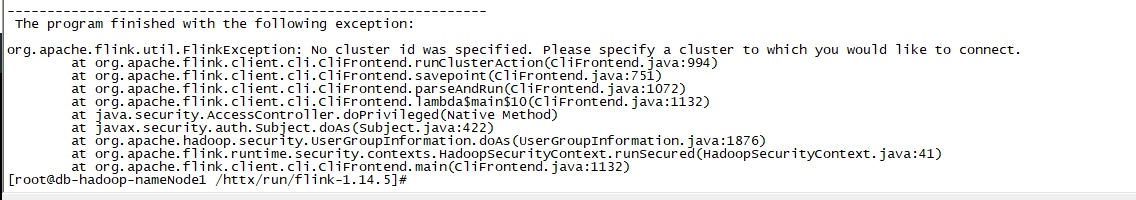

我手动执行savepoint ,bin/flink savepoint f0977323cd9823e3cd2946ea366532dd hdfs://10.2.2.1:9000/flink/sp/却一直出现这个问题

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的问题和参考的知识库资料,您在手动执行Savepoint时遇到问题。为了解决您的问题,请按照以下步骤进行检查和操作:

确认Flink作业状态:

flink list -running来查看作业ID及状态。检查HDFS访问权限与配置:

flink-conf.yaml中检查是否有正确的HDFS相关配置,例如HDFS的地址、用户名等设置。命令格式验证:

bin/flink savepoint :jobId [:targetDirectory]

您的命令bin/flink savepoint f0977323cd9823e3cd2946ea366532dd hdfs://10.2.2.1:9000/flink/sp/格式上看似正确,但请确保没有遗漏或多余的空格等格式错误。

查看日志以获取详细错误信息:

$FLINK_HOME/log/目录下,查找与执行Savepoint命令相关的错误信息。这些日志可能会提供导致失败的具体原因,如网络问题、权限不足或其他异常。网络与HDFS服务状态:

ping 10.2.2.1和检查HDFS服务状态的命令来辅助诊断。如果以上步骤均未发现明显问题,考虑以下可能的高级排查步骤:

若问题依旧无法解决,建议收集详细的错误日志并联系技术支持或查阅Flink官方文档以获得更深入的帮助。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。