flink cdc整库迁移怎么弄?

flink cdc整库迁移怎么搞,创建很多table,INSERT INTO ... SELECT ...吗,是不是得用java api,分流

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

解答

问题描述: 用户希望了解如何使用Flink CDC进行整库迁移,并询问是否需要为每个表执行INSERT INTO ... SELECT ...操作,以及是否必须使用Java API来实现分流逻辑。

背景信息

Flink CDC(Change Data Capture)是一种捕获数据库变更日志的技术,可以用于实时数据同步和迁移。在Flink中,通过Flink SQL与特定的连接器(如flink-connector-mysql-cdc),可以实现从MySQL等关系型数据库到其他存储系统(如云数据库SelectDB)的数据迁移,支持全量数据迁移及后续的增量数据同步。

解决方案

-

准备环境与依赖

- 步骤1: 搭建Flink运行环境,确保版本兼容性。例如,使用Flink 1.16单机环境。

- 步骤2: 下载并配置必要的连接器JAR包,如

flink-sql-connector-mysql-cdc和目标数据库的连接器到FLINK_HOME/lib目录下。

-

配置Flink CDC任务

- 步骤3: 使用Flink SQL编写迁移任务脚本,无需为每个表单独编写

INSERT INTO ... SELECT ...语句。Flink CDC支持通过模式匹配指定要迁移的表范围,例如使用-including-tables "schema_name.*"参数来迁移整个库下的所有表。

示例命令行提交任务如下,注意替换实际的源数据库和目标数据库信息:

<FLINK_HOME>/bin/flink run \ -Dexecution.checkpointing.interval=10s \ -Dparallelism.default=1 \ -c org.apache.doris.flink.tools.cdc.CdcTools \ lib/flink-doris-connector-x.x.x.jar \ mysql-sync-database \ -database your_db_name \ -including-tables "your_db_name.*" \ -mysql-conf hostname=source_mysql_host \ -mysql-conf username=source_user \ -mysql-conf password=source_password \ -sink-conf fenodes=target_selectdb_endpoint:port \ -sink-conf username=target_user \ -sink-conf password=target_password - 步骤3: 使用Flink SQL编写迁移任务脚本,无需为每个表单独编写

-

数据流处理与分流

- 在上述Flink CDC任务中,数据的读取、转换(如有必要)和写入过程是自动管理的,无需手动编写Java API来实现分流逻辑。Flink CDC会根据配置自动捕获变更事件(包括插入、更新、删除),并将其作为数据流的一部分处理,最终写入目标数据库。

注意事项

- 版本兼容性:确保使用的Flink及其连接器版本与源数据库和目标数据库兼容。

- 资源评估:整库迁移可能涉及大量数据,需合理规划作业的并发度和资源分配,以避免对源数据库造成过大压力或迁移过程中资源耗尽。

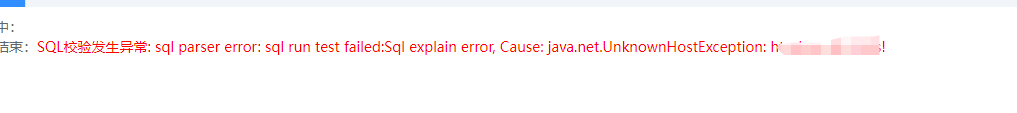

- 测试验证:在生产环境部署前,建议先在小规模数据或测试环境中验证迁移流程,确保无误后再进行全量迁移。

综上所述,使用Flink CDC进行整库迁移并不需要手动为每个表编写INSERT INTO ... SELECT ...语句,也不强制要求使用Java API来实现分流,而是通过配置化的SQL作业定义完成自动化迁移过程。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。