cdc任务设置保存点后恢复,报错,FATAL: Thread 'SourceCoordinator-Source: CDCAllWmsToKafka3_2' produced an uncaught exception. Stopping the process...这个怎么回事,有遇到这个问题的么

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

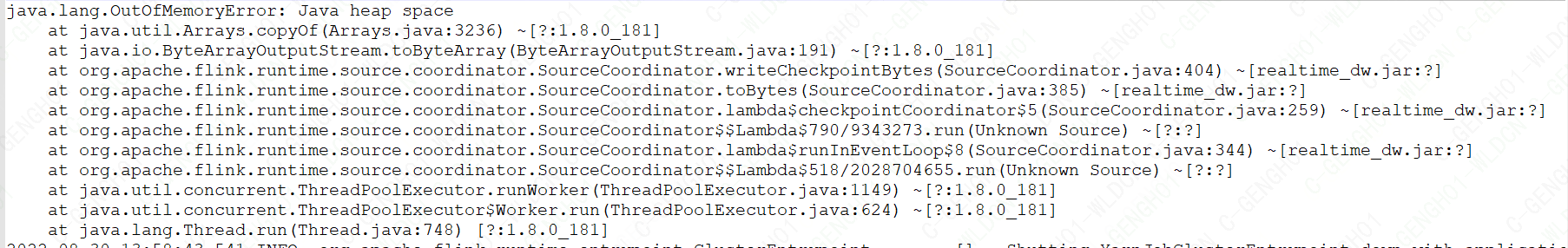

问题描述: 您在尝试从保存点恢复CDC任务时遇到报错,错误信息为FATAL: Thread 'SourceCoordinator-Source: CDCAllWmsToKafka3_2' produced an uncaught exception. Stopping the process...。这表明在任务协调或数据源处理线程中发生了未被捕获的异常,导致任务停止运行。

可能原因:

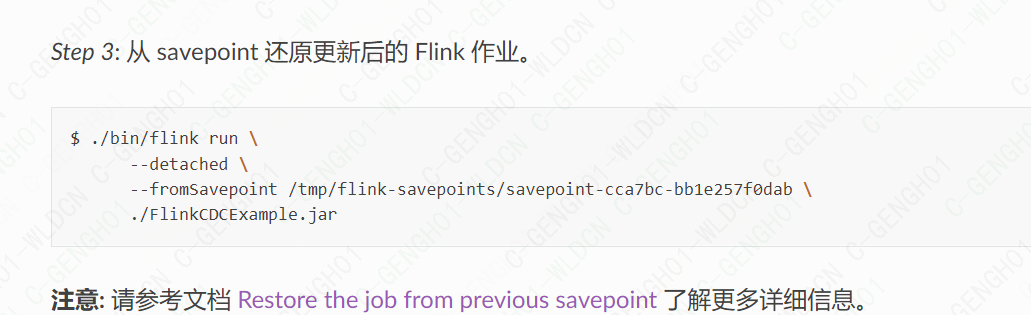

解决步骤:

检查任务配置变更:确认自保存点创建以来,是否有任何配置变动可能引起兼容性问题,包括并行度、source和sink配置等。

资源检查:确保执行环境有足够的资源供任务使用,包括但不限于检查CPU负载、内存使用情况及磁盘空间。

外部服务验证:确认所有依赖的服务(如MySQL、Kafka)均运行正常,没有处于维护模式或存在连接问题。

日志分析:详细查看Flink任务的日志,特别是异常堆栈信息,以定位具体错误原因。这将帮助识别是配置问题、资源限制还是其他特定错误。

版本兼容性核对:确认使用的Flink、Debezium及其他相关库的版本组合是否兼容,查阅官方文档或社区讨论,看是否有已知的问题报告。

重新初始化任务:如果上述步骤无法解决问题,考虑不使用保存点重新部署任务,或者尝试创建新的保存点后再次恢复。

注意事项:

参考资料: 本解答综合了通用的故障排查思路与知识库中的相关信息,尽管直接对应的解决方案未明确列出,但上述步骤应能指导您系统地诊断并解决此问题。

请按照上述步骤顺序进行排查和修复,若问题依旧未能解决,建议收集详细的错误日志,并联系技术支持获取更专业的帮助。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。