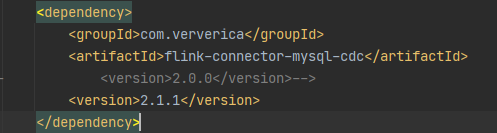

大家有没有遇到 mysql-cdc 做全量StartupOptions.latest(),同步完成的时候 不会处理增量的数据 这样的问题

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到MySQL CDC在使用StartupOptions.latest()进行全量同步后,未能正确处理增量数据的问题,可能涉及以下几个原因及排查步骤:

配置检查:首先确认在Flink作业配置中是否正确设置了读取模式为从最新的Binlog位点开始读取。使用scan.startup.mode配置项并指定为latest-offset来确保这一点。

Checkpoint问题:检查作业的Checkpoint机制是否正常运作。确保在全量同步完成后能生成有效的Checkpoint,因为这通常是进入增量处理阶段的关键标志。

日志分析:查看TaskManager(TM)的日志,寻找是否有异常信息或特定的日志条目如BinlogSplitReader is created,这能帮助判断全量同步是否确实完成以及增量读取是否已启动。

数据库配置:确认MySQL服务器的Binlog配置没有问题,特别是对于RDS MySQL 5.6的只读实例,其Binlog可能不包含必要的变更数据,需要考虑升级到更高版本或使用可写实例。

并发与资源:评估MySQL CDC Source的并发度设置是否合理,过高的并发可能会对数据库造成压力,而过低则可能导致数据处理速度慢,影响增量数据的及时读取。

网络与带宽:虽然不是直接导致增量数据不处理的原因,但检查网络状况和带宽使用情况也是必要的,以排除因网络问题导致的数据传输延迟或中断。

时间戳时区问题:如果timestamp字段存在时区差异,也会影响数据处理逻辑,需确认时间相关设置是否与数据库保持一致。

重启策略:检查Flink作业的重启策略,确保作业在失败后能够按照预期重启或彻底退出,避免因持续重启导致的作业状态混乱。

针对上述每个点进行细致检查和调整,通常可以定位并解决全量同步后增量数据处理不正常的问题。如果所有配置均正确无误,建议进一步深入日志分析,并考虑联系技术支持获取更专业的帮助。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。