flink cdc stream api 2.2.1 mysql 一条很大的字段数据异常了有人遇到过么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

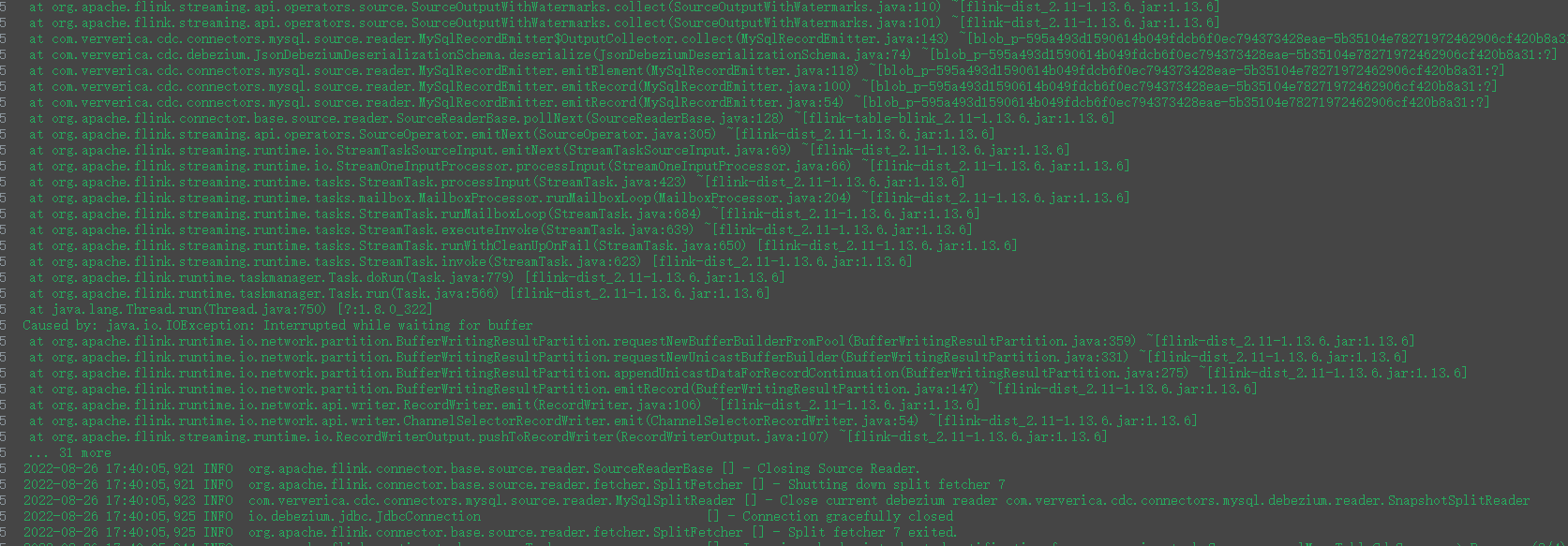

问题描述: 您遇到了使用Flink CDC Stream API 2.2.1从MySQL读取数据时,针对包含一条非常大的字段记录出现异常的情况。

背景信息: Flink CDC(Change Data Capture)是Apache Flink中用于捕获数据库变更日志的功能,它允许用户实时处理数据库的增删改查操作。在与MySQL集成时,通过特定的connector可以监听MySQL的binlog并转换为数据流。您提到的异常可能与数据处理或网络传输中的大小限制相关。

解决方案: 1. 检查字段大小限制:首先确认这条“很大的字段”是否超过了MySQL的单个字段最大尺寸限制或者Flink在处理数据时的缓冲区大小限制。对于MySQL,例如VARCHAR类型的字段有其最大长度限制。而在Flink端,需要关注的是序列化器和网络传输的缓冲区设置,确保它们能够处理大数据量的记录。

调整序列化器配置:如果使用了自定义序列化器处理timestamp或其他大字段类型,请确保序列化逻辑正确处理大对象,并且考虑到了时区等细节,避免解析错误。 对于特别大的对象,考虑是否有必要进行数据压缩或分块处理。

优化Flink配置:

taskmanager.network.memory.min 和 taskmanager.network.memory.max 配置项增加网络传输的缓冲区大小。taskmanager.memory.process.size是一个关键参数。监控与日志分析:查看Flink作业的运行日志,寻找有关数据大小超出限制或处理失败的具体错误信息。这将帮助定位问题所在,比如是否因数据大小导致的内存溢出(OOM)。

数据预处理:如果某些字段确实过大,考虑在源头数据库进行数据拆分或在Flink作业中增加数据清洗步骤,将大字段分解为更小的、可管理的部分。

注意事项: - 版本兼容性:确保使用的Flink版本与MySQL connector版本兼容,避免因版本不匹配引起的问题。 - 资源分配:合理分配集群资源,确保TaskManager有足够的内存来处理潜在的大数据记录。 - 时间戳时区问题:虽然您的问题主要关于大数据字段,但根据参考资料,也请注意检查时间戳字段的时区设置,以避免因时区不同导致的时间偏移问题。

请根据上述建议检查和调整您的配置,逐步排查问题。如果问题依然存在,建议收集详细的错误日志并进一步分析,或考虑在Flink或MySQL的相关社区寻求帮助。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。