为什么2.2版本,我的cdc 任务在挂掉后无法读取挂掉期间的增量数据呢? 我记得低版本都是可以的 。有人遇到吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在您提到的场景中,如果您的CDC任务(特别是指使用如Flink CDC等工具进行数据捕获的任务)在2.2版本中挂掉后无法读取挂掉期间的增量数据,这可能与几个因素相关:

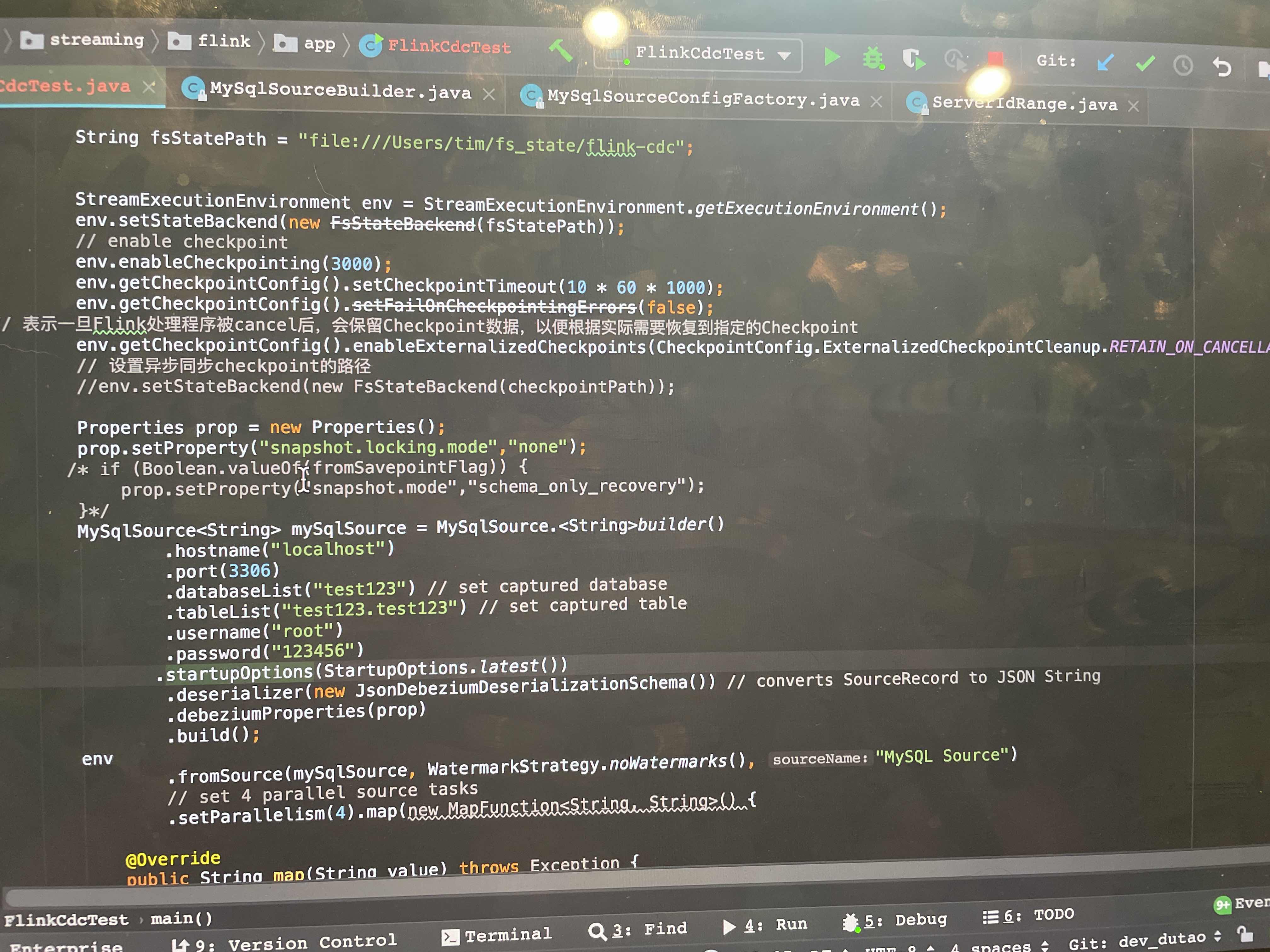

Checkpoint机制:Flink通过Checkpoint机制来确保作业故障恢复时能够从最近一次成功完成的Checkpoint处继续执行。如果Checkpoint间隔设置得较大,或者Checkpoint过程中出现问题未能成功完成,那么在任务挂掉后可能会丢失挂掉期间的数据。确保您的Checkpoint策略配置合理且运行正常是关键。

MySQL Binlog保留策略:如果MySQL服务器上的Binlog文件过期被清理,而此时任务恰好故障需要重放这部分日志来恢复状态,就可能导致无法读取到挂掉期间的增量数据。因此,检查并适当增加Binlog的保留时间也是必要的。

Flink作业重启策略:Flink作业的重启策略配置也会影响故障后的数据处理能力。如果配置不当,例如设置了无限重启或重启次数过少,都可能导致增量数据处理不连续。根据业务需求调整合适的重启策略对于保证数据完整性很关键。

软件版本特性和Bug:不同版本的软件可能包含对异常处理和容错机制的不同实现。虽然您提到低版本似乎能更好地处理这种情况,但这也可能是由于特定版本中存在的未知或已知问题。建议查阅官方文档或社区讨论,确认是否有已知问题或更新说明影响了该版本的容错能力,并考虑升级到一个更稳定或修复了相关问题的版本。

综上所述,要解决这个问题,您可以采取以下措施: - 调整并优化Checkpoint的配置,确保其频繁且可靠地执行。 - 检查并延长MySQL的Binlog保留时间,以覆盖可能的故障恢复周期。 - 重新审视并配置Flink作业的重启策略,确保在遇到故障时有合理的尝试恢复机制。 - 查阅相关软件的发行说明,确认是否为已知问题,并考虑升级至更稳定的版本。

如果以上步骤不能解决问题,建议深入查看具体错误日志,并在相应的技术社区或官方支持渠道寻求帮助,以便获得更针对性的解决方案。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。