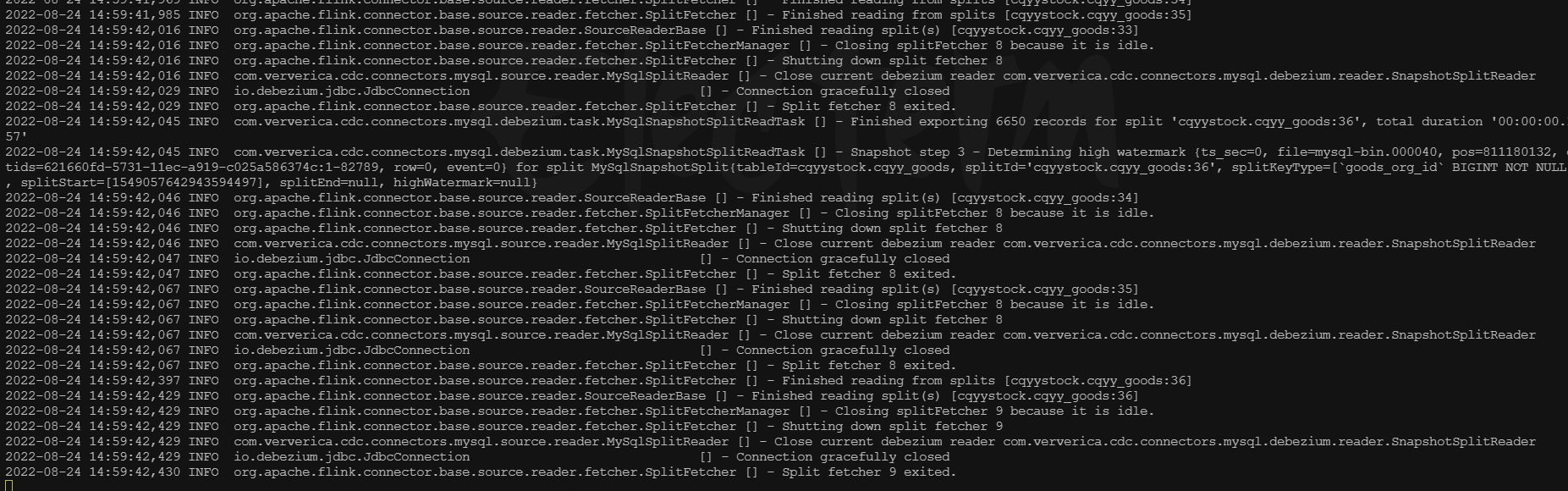

请问下 各位大佬 flinkcdc 同步mysql 初始化话完了之久连接就关闭了 导致同步不了增量,这个有遇到过吗?怎么办?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到Flink CDC同步MySQL在初始化完成后连接关闭,导致无法同步增量数据的问题,可以从以下几个方面进行排查和解决:

检查Checkpoint间隔时间:确保您的Flink作业的Checkpoint间隔时间设置得当。如果间隔时间过长,可能会导致在全量同步到增量同步的切换过程中等待时间过久,看起来像是连接被关闭。建议根据业务需求调整为合理的Checkpoint间隔。

确认Binlog配置与权限:确保MySQL实例的Binlog配置正确且未被过滤。使用show master status;命令检查Binlog_Do_DB和Binlog_Ignore_DB设置,确认目标数据库未被忽略。同时,确认使用的MySQL用户具有SELECT、SHOW DATABASES、REPLICATION SLAVE和REPLICATION CLIENT等必要权限。

并发数与连接池大小:检查是否在全量读取阶段设置了过大的并发数或连接池Size,这可能导致大量连接被占用,在进入增量阶段后没有足够的连接维持同步。适当降低作业并发数和连接池大小,并优化SQL逻辑,考虑是否可以采用CDAS(CREATE DATABASE AS)来复用连接。

RDS MySQL版本与特性:确认RDS MySQL版本不是5.6只读实例,因为这类实例提供的binlog不包含实际数据,无法用于增量同步。对于RDS MySQL 5.6.x,确认已开启并接受增量快照功能,因为该功能默认开启且不支持关闭,对同步至关重要。

监控与日志分析:利用实时计算控制台监控告警页签的currentEmitEventTimeLag值来确定数据同步状态,以及通过查看作业的日志,了解是否有异常信息提示连接关闭的具体原因。

Server ID配置:每个Flink CDC数据源需配置不同的Server ID以避免冲突和位点错乱问题,确保数据源间独立且稳定运行。

综上所述,通过上述步骤逐一排查并相应调整,应该能有效解决Flink CDC在初始化后连接关闭,无法同步增量数据的问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。