Spark的转换数据是如何完成计算的呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

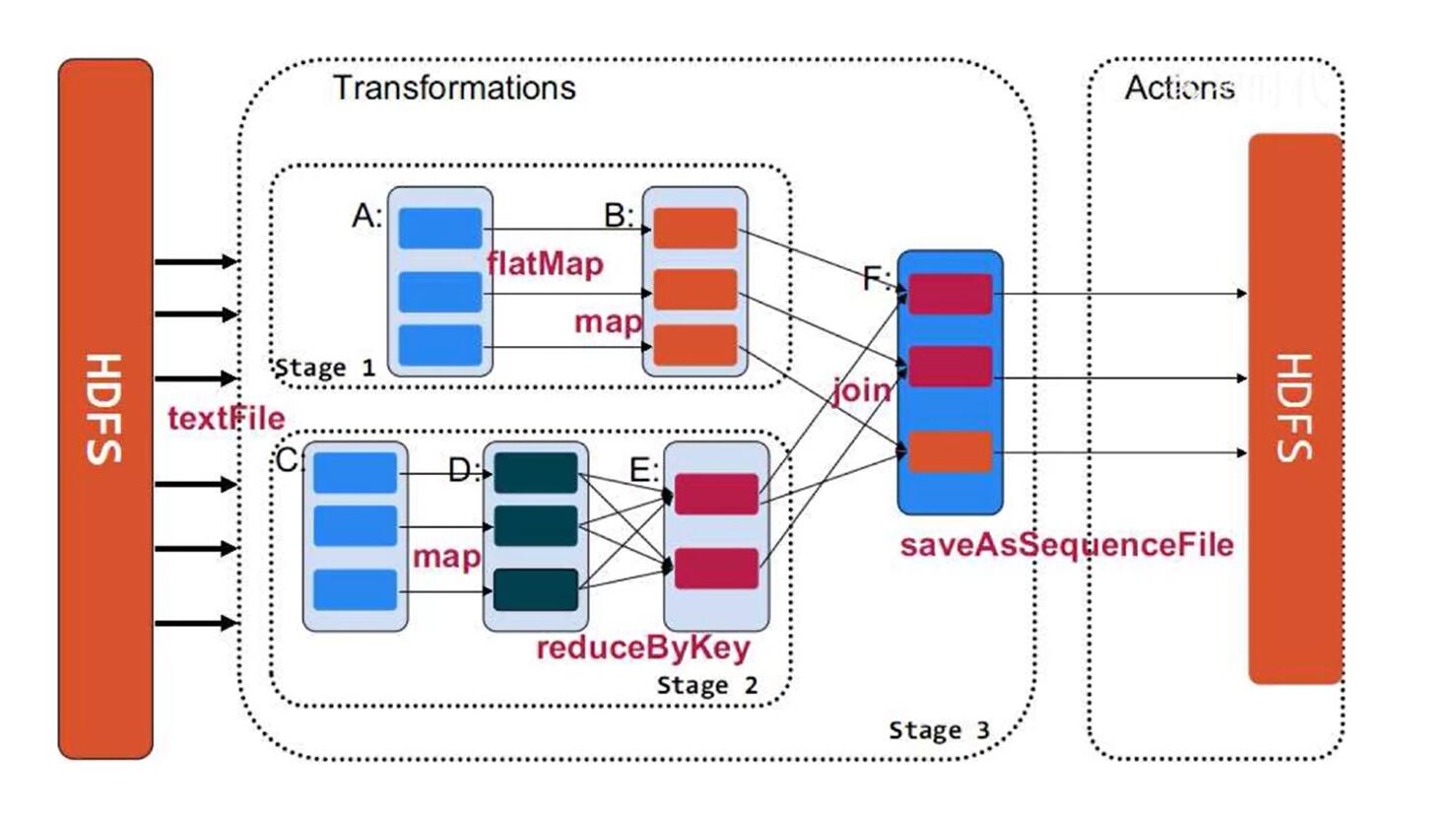

所有的数据一开始都是从HDFS存储中取出的, 取出后创建RDD数据集, 在图中有两个最初始创建的数据集,一个是RDDA, 一个是RDDC两者都是从HDFS取出的数据,共同生成了弹性分布式数据集, 而A中含有三个分片可能存储于不同的数据结点上, C同理。而A经过转换操作到B,C经过转换到D后再通过转换操作reduceByKey变成E。最 后通过join操作将B和E生成F, 其中ABCDE大的长方形就是DAG图的每个结点, 即最后结点F经过Action操作计算结果, 将其又存储到HDFS中。以上就是Spark的转换数据计算全过程。