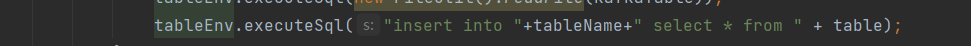

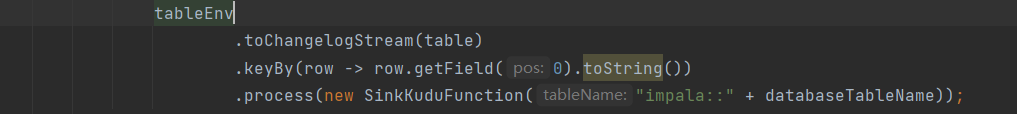

执行了一个 insert,执行了一个自定义的sink 提交到yarn会生成俩job 有办法合成一

执行了一个 insert,执行了一个自定义的sink 提交到yarn会生成俩job 有办法合成一个吗 大佬们

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

1

条回答

写回答

-

十分耕耘,一定会有一分收获!

楼主你好,可以尝试使用 Apache Flink 的 StreamExecutionEnvironment 来实现数据流的合并,具体步骤如下:

- 创建一个 StreamExecutionEnvironment 对象,并指定运行环境为 Yarn。

- 使用 addSource 方法读取阿里云的数据源,将数据流转换为 DataStream 对象。

- 使用 addSink 方法将数据流写入自定义的 Sink。

- 调用 execute 方法启动任务。

示例代码:

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment(); env.setRuntimeMode(RuntimeExecutionMode.YARN); // 设置运行环境为 Yarn DataStream<Row> sourceStream = env.addSource(...); // 读取阿里云数据源 sourceStream.addSink(...); // 写入自定义 Sink env.execute("Job Name"); // 启动任务这样做的好处是可以将两次提交合并成一个任务,提高执行效率。

2023-08-22 17:12:26赞同 展开评论

相关问答

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。

收录在圈子:

+ 订阅

实时计算 Flink 版(Alibaba Cloud Realtime Compute for Apache Flink,Powered by Ververica)是阿里云基于 Apache Flink 构建的企业级、高性能实时大数据处理系统,由 Apache Flink 创始团队官方出品,拥有全球统一商业化品牌,完全兼容开源 Flink API,提供丰富的企业级增值功能。

相关文章

热门讨论

热门文章

展开全部

展开全部

还有其他疑问?

咨询AI助理