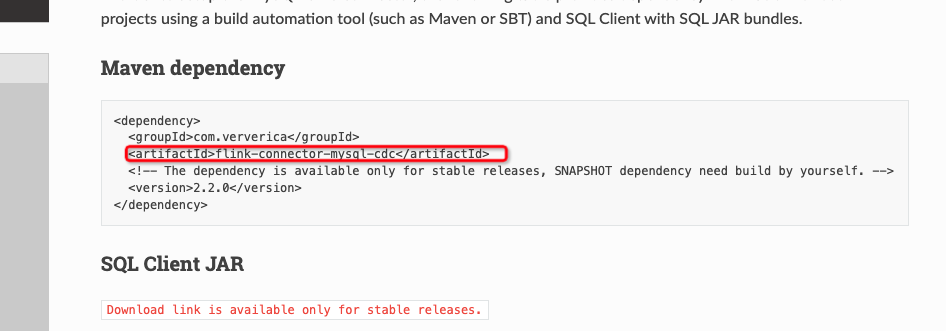

官网给的这个依赖是不是应该为flink-sql-connector-mysql-cdc啊,加了依赖调

官网给的这个依赖是不是应该为flink-sql-connector-mysql-cdc啊,加了依赖调了半天才发现错了

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

您提到的依赖名称确实是flink-sql-connector-mysql-cdc,这是Flink用于连接MySQL并进行CDC(Change Data Capture)操作的正确依赖。不过,使用该依赖时有几个细节需要注意:

-

版本匹配:确保所使用的

flink-sql-connector-mysql-cdc版本与您的Flink版本兼容。不同版本的Flink可能需要特定版本的连接器。如果遇到不兼容的情况,可能会导致各种问题,比如类找不到或功能不正常。 -

依赖下载:如果您直接从Maven中央仓库搜索带有

-SNAPSHOT后缀的版本(例如flink-sql-connector-mysql-cdc-2.2-SNAPSHOT.jar),可能会发现它不可用。这是因为-SNAPSHOT版本通常表示开发中的快照版本,不会直接发布到中央仓库。对于这类版本,您需要按照文档指引,从源码构建或者寻找稳定版本(如flink-sql-connector-mysql-cdc-2.1.0.jar)来使用。 -

库文件位置:添加依赖JAR包时,请确保将其放置在Flink集群的

$FLINK_HOME/lib目录下,这样才能在运行时被正确识别和加载。 -

网络配置:如果您的MySQL实例不在与Flink相同的VPC内,需要确保网络配置正确,比如通过配置NAT网关访问公网数据库。

-

配置参数:正确配置MySQL CDC Source所需的参数,包括但不限于

hostname、username、password、database-name等,以确保Flink能够成功连接到MySQL数据库并读取变更数据。

综上所述,确认依赖名称无误后,还需关注版本兼容性、依赖获取方式、库文件存放位置以及网络与配置参数的准确性,这些是解决依赖问题的关键步骤。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。