利用flink-cdc 同步一个数据库的多张表数据,一直报错 One or more fetchers have encountered exception,一晚上重启了几十次,在github上找到了这个issue ,但是还没发现有回答。https://github.com/ververica/flink-cdc-connectors/issues/709!

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

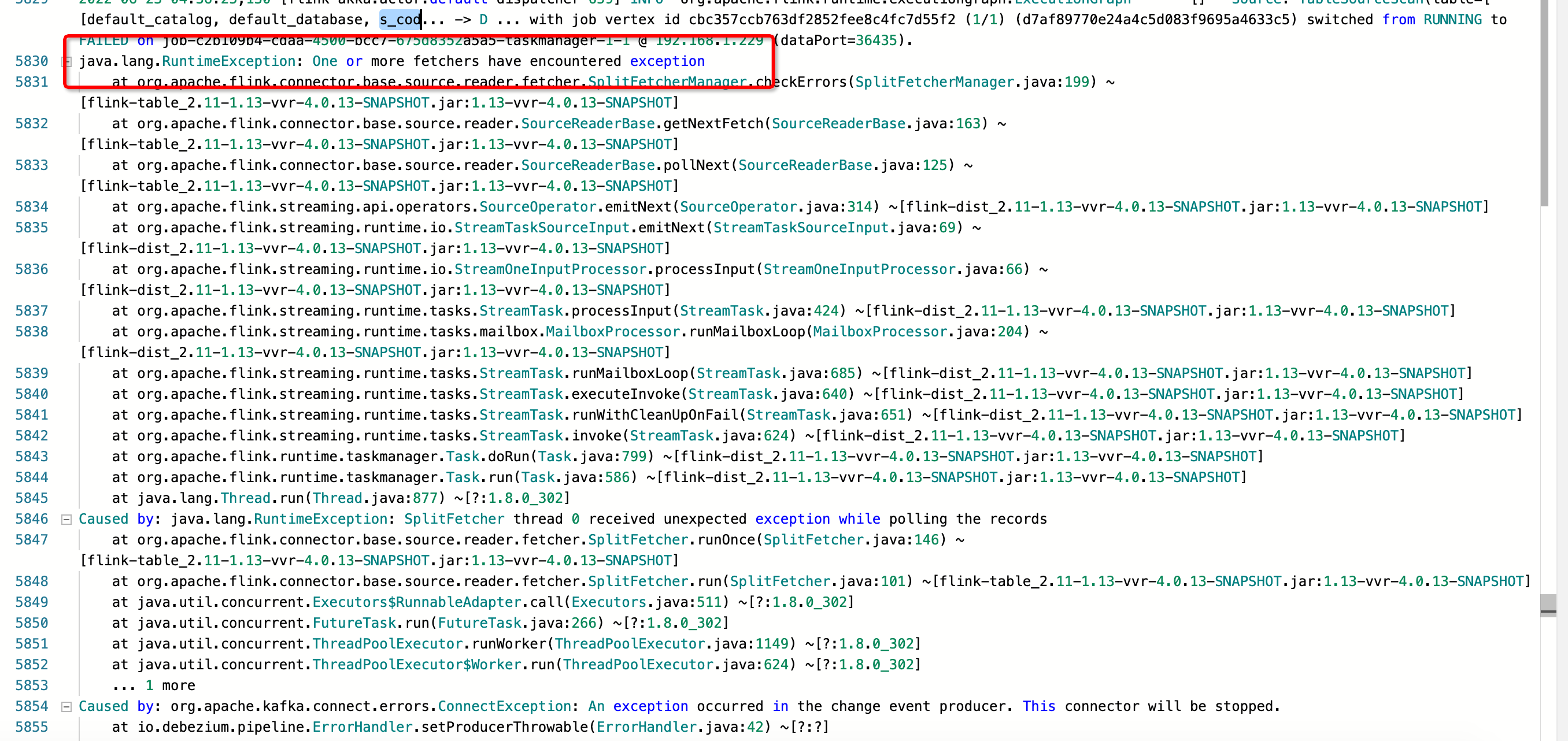

用户在使用Flink CDC同步一个数据库的多张表数据时,频繁遇到错误提示One or more fetchers have encountered exception,导致作业一晚上重启了几十次。此问题尚未在GitHub相关issue中找到解决方案。

检查网络与数据库稳定性:

资源与配置优化:

fetch.size以减少网络交互次数,或调整max.batch.size控制每次处理的数据量大小。数据库日志保留策略:

expire_logs_days配置合理。监控与日志分析:

版本兼容性检查:

异常重试与容错机制:

解决One or more fetchers have encountered exception的问题需要综合考虑网络稳定性、资源分配、数据库配置、以及Flink作业本身的设置。通过上述步骤逐一排查并优化,可以有效降低作业重启频率,提升数据同步的稳定性。同时,密切关注官方文档和社区动态,及时获取针对特定问题的解决方案或补丁。您可以复制页面截图提供更多信息,我可以进一步帮您分析问题原因。