各位亲,flink cdc 在k8s容器跑。初始化数据正常,增量同步就没有了。容器的日志如附件。大家

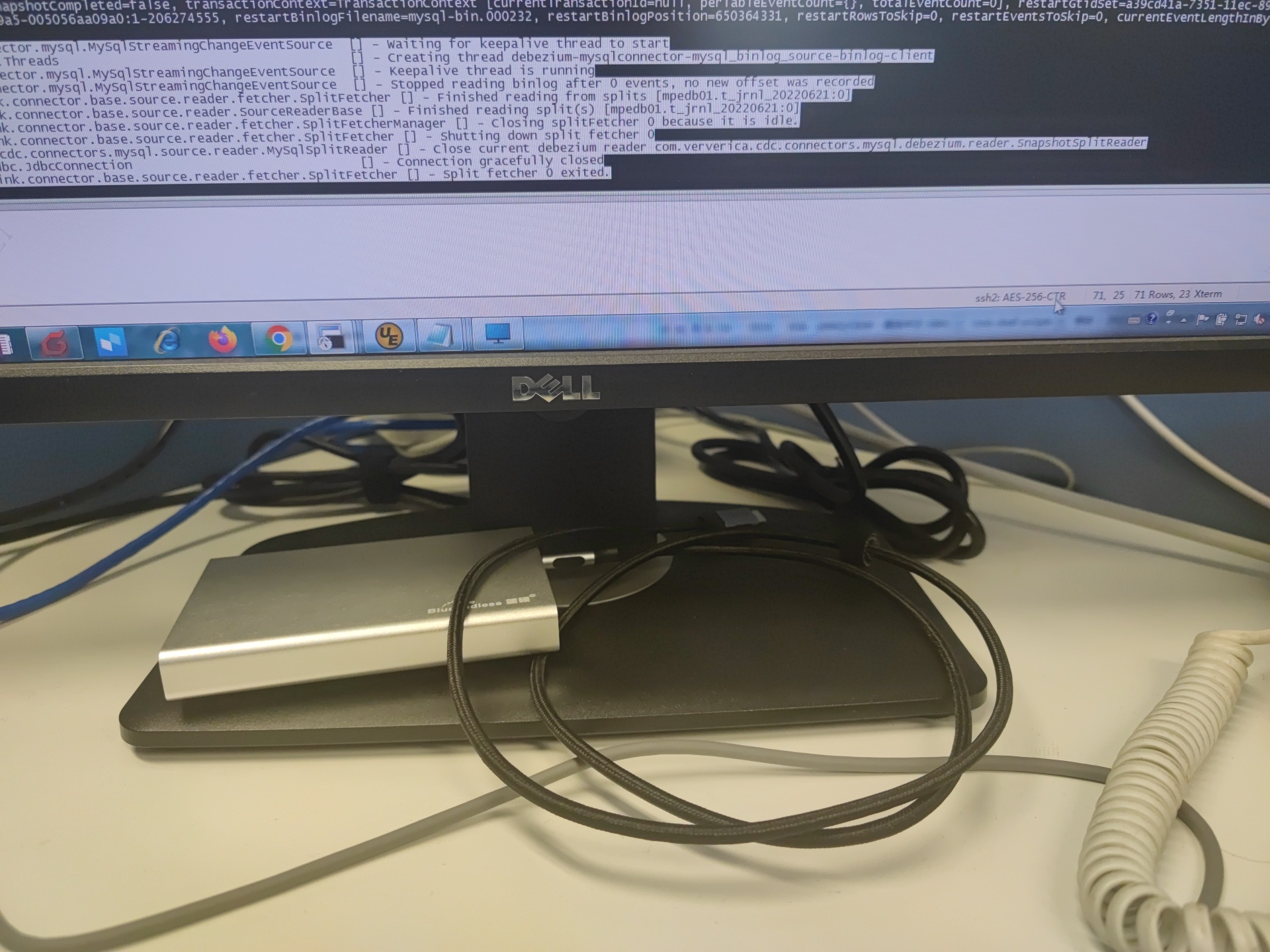

各位亲,flink cdc 在k8s容器跑。初始化数据正常,增量同步就没有了。容器的日志如附件。大家谁知道啥原因啊?SET execution.checkpointing.interval = 3s; 后增量任务正常

展开

收起

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

阿里云 AI 助理回答

根据您描述的问题和提供的信息,Flink CDC在Kubernetes容器中运行时遇到初始化数据同步正常但增量同步失败的情况。从您的操作来看,通过设置execution.checkpointing.interval = 3s后增量任务恢复了正常,这表明问题与Checkpoint间隔时间配置有关。结合知识库中的参考资料,我们可以分析并提供以下解答:

问题描述

- Flink CDC作业在Kubernetes集群上部署,初次全量数据同步成功,但随后的增量数据同步未按预期进行。

原因分析

- Checkpoint间隔过长:根据您的解决办法和参考文档,原作业的Checkpoint间隔可能设置得过大,导致进入增量读取阶段前等待时间过长(例如默认20分钟),从而影响了增量数据的即时同步。

解决方案

- 优化Checkpoint配置:已通过设置

execution.checkpointing.interval = 3秒解决了问题,这意味着较短的Checkpoint间隔确保了全量数据写入下游系统后能迅速开始增量数据的处理,保证了数据的实时性。

注意事项

- 资源监控:虽然缩短Checkpoint间隔解决了增量同步问题,但也需注意频繁的Checkpoint会增加资源消耗,特别是对存储和网络I/O的影响。因此,建议持续监控作业资源使用情况,确保不会引发其他性能瓶颈。

- 合理调整:根据实际业务需求和资源状况,适时调整Checkpoint间隔至一个既能保证数据及时性又不致过度消耗资源的平衡点。

- 日志分析:对于未来类似问题,深入分析容器日志是关键。虽然当前问题直接通过调整解决了,但日志中可能包含了更具体错误信息或警告,有助于快速定位问题根源。

综上所述,通过减小Checkpoint间隔至3秒,您已经成功解决了Flink CDC在K8s环境中增量同步不启动的问题。未来在面对类似问题时,细致检查作业配置、监控作业状态,并依据实际场景灵活调整参数将是维护数据同步作业稳定性的有效策略。

有帮助

无帮助

AI 助理回答生成答案可能存在不准确,仅供参考

相关问答

相关文章

热门讨论

热门文章

展开全部

还有其他疑问?

咨询AI助理