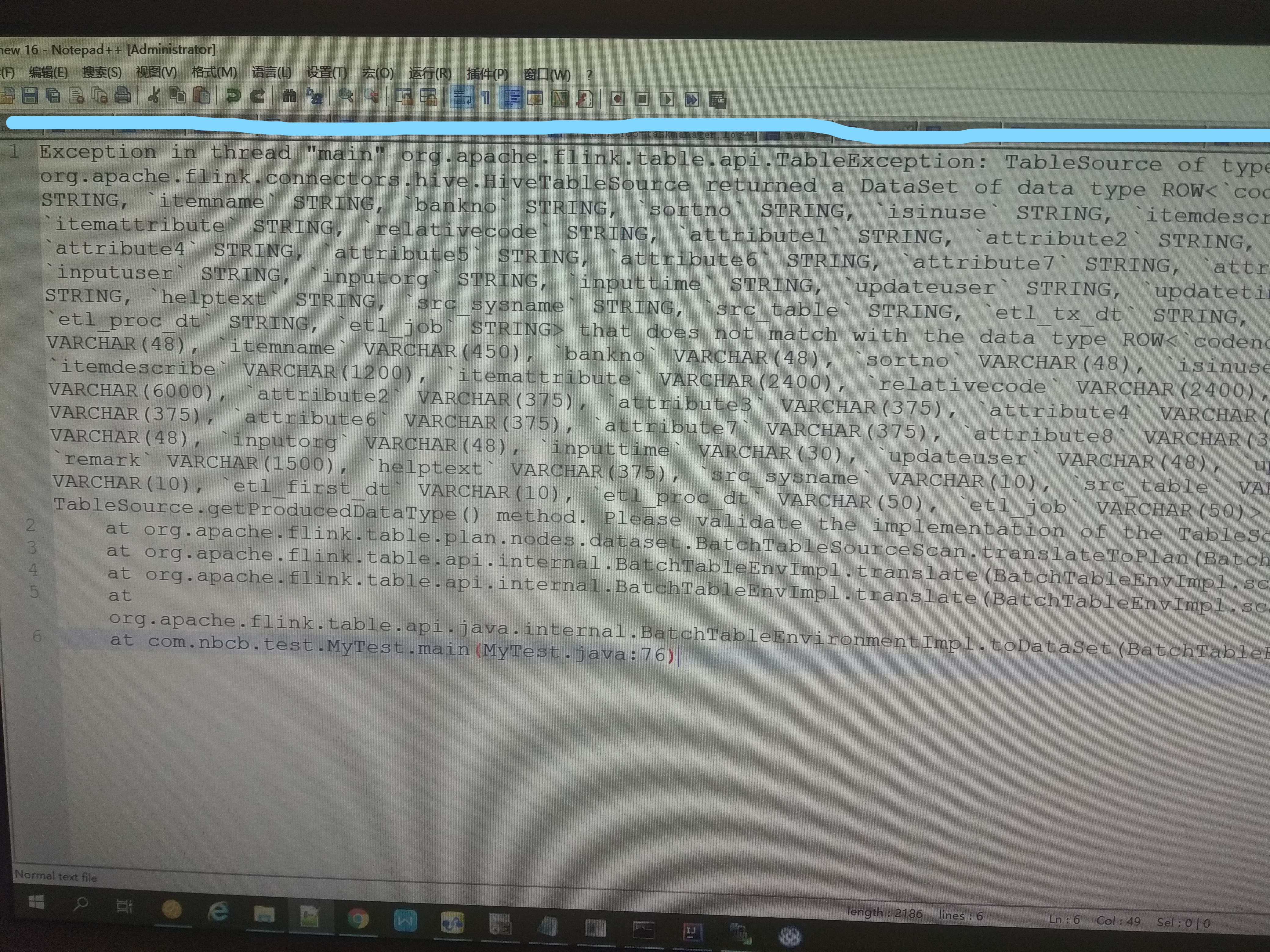

flink是1.9的,hive是1.2.1的,hive表的类型是VARCHAR

flink是1.9的,hive是1.2.1的,hive表的类型是VARCHAR

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

#hive-mysql字符编码错乱问题 #/etc/my.cnf添加下列字段 然后 service mysqld restart init_connect=‘SET collation_connection = utf8_unicode_ci’ init_connect=‘SET NAMES utf8’ character-set-server=utf8 collation-server=utf8_unicode_ci skip-character-set-client-handshake

强调的一点:hive的元数据metastore在mysql的数据库,不管是数据库本身,还是里面的表编码都必须是latin1(CHARACTER SET latin1 COLLATE latin1_bin)!!! #hive-site.xml里面的路径 useUnicode=true&haracterEncoding=UTF-8 加入字符码的设定

javax.jdo.option.ConnectionURL jdbc:mysql://hadoop3:3306/hive?useUnicode=true&haracterEncoding=UTF-8&useSSL=false