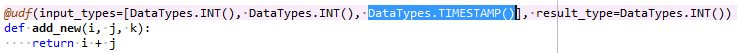

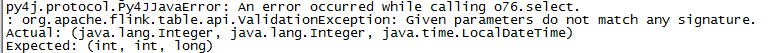

版本:pyflink1.10 pyflink使用python udf的时候数据类型定义为DataTypes.TIMESTAMP(),但是执行时被解释为long型,报not match 源码:  报错:

报错:

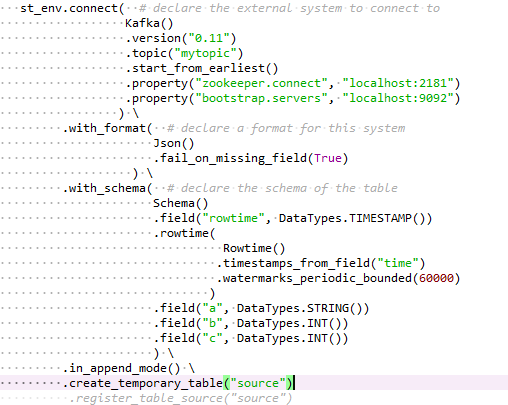

补充:使用kafka数据源,kafka版本为0.11.3 source部分:

或者是哪里写错了吗?请各位指教

另外当使用register_table_source创建表时DataTypes.TIMESTAMP()的类型会显示为java.sql.Timestamp,这种类型不一致会造成问题吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在PyFlink中,当你定义UDF(用户自定义函数)并使用DataTypes.TIMESTAMP()作为数据类型时,实际上你是在指定该字段应被解释为时间戳类型。然而,Flink内部处理时间戳的方式是基于Unix时间戳(即从1970-01-01 00:00:00 UTC开始的毫秒数),这在Java中通常表示为long类型。因此,当你看到执行时被解释为long型,这实际上是符合预期的,因为Flink内部为了效率和兼容性会这样处理时间戳。

对于你的报错信息,没有直接提供具体的错误内容,但根据描述,问题可能出在数据类型不匹配或者UDF逻辑与预期的数据类型处理方式不符。确保你的UDF正确地处理了long类型的输入,并能够按照预期转换或操作这个时间戳值。

关于使用register_table_source创建表时显示为java.sql.Timestamp,这表明在Table API层面,Flink尝试将时间戳以更符合SQL标准的类型展示出来。java.sql.Timestamp是一个包含日期和时间的值,与Flink内部的时间戳表示方法在概念上是一致的,尽管它们底层存储和处理方式不同。这种类型上的“不一致”在大多数情况下不会直接造成问题,因为Flink会在内部进行必要的转换以保证数据的正确流动和处理。

如果你遇到具体的问题,比如类型转换错误或者无法正确处理时间戳数据,请检查以下几点: 1. UDF实现:确保你的UDF正确处理了long型的时间戳数据,例如通过from_unixtime等函数将其转换为期望的日期时间格式。 2. 数据源配置:确认Kafka数据源读取的数据格式与你在表定义中声明的类型相匹配。如果Kafka消息中的时间戳不是以Unix时间戳形式存在,可能需要在读取时进行适当的转换。 3. 时间戳提取器/ watermark策略:如果你涉及到事件时间处理,确保设置了正确的timestamp assigner和watermark生成策略,特别是当数据源中的时间戳字段不是默认的或者需要特殊处理时。

如果有具体的错误信息或者代码片段,提供这些详细信息可以帮助更准确地定位问题所在。