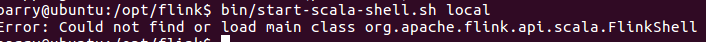

org.apache.flink.api.scala.FlinkShell 编译好的flink里面只包含很少几个jar包,其他的jar包要到哪里下载啊?还是要自己编译?

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。点击链接欢迎加入感兴趣的技术领域群。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

Apache Flink是一个流处理和批处理的开源框架,它允许用户编写分布式数据处理程序。当你发现Flink的发行版中包含的JAR文件不够用时,通常是因为你需要额外的库来支持特定的功能或连接器等。以下是一些获取额外JAR包的方法:

Maven或Ivy依赖: 如果你是在一个构建系统如Maven或Sbt(Scala项目常用)中使用Flink,你可以直接在项目的pom.xml或build.sbt文件中添加对应的依赖项。Maven Central或Flink的Maven仓库会自动下载所需的JAR包及其依赖。例如,如果你需要添加Kafka连接器,可以在Maven的pom.xml中添加如下依赖:

<dependency>

<groupId>org.apache.flink</groupId>

<artifactId>flink-connector-kafka_2.11</artifactId>

<version>${flink.version}</version>

</dependency>

确保替换${flink.version}为你的Flink版本。

Flink官网下载页面: Flink的每个版本发布时,除了核心发行版外,还会提供预编译的模块和连接器。你可以访问Flink的官方下载页面,找到对应版本的“Additional Libraries and Modules”部分,这里通常会有常用的连接器和库的下载链接。

手动编译: 如果确实有特殊需求,需要某个非常规或最新开发但未发布的组件,你可能需要从Flink的源代码自行编译。这通常涉及克隆Flink的GitHub仓库,切换到相应的分支,然后执行Maven命令来编译特定的模块。但这通常是较为少见的情况,大多数情况下通过上述方法应该足够满足需求。

阿里云Flink产品: 如果你是阿里云的用户,并且在使用阿里云的实时计算服务(如实时计算Flink版),那么很多连接器和服务集成已经作为服务的一部分提供,无需单独下载或编译JAR包。具体的支持情况和配置方法可以参考阿里云实时计算Flink版的官方文档。

综上所述,大多数情况下,通过依赖管理工具(如Maven)直接添加依赖是最便捷的方式。只有在极少数特殊情况下,才需要考虑手动编译。