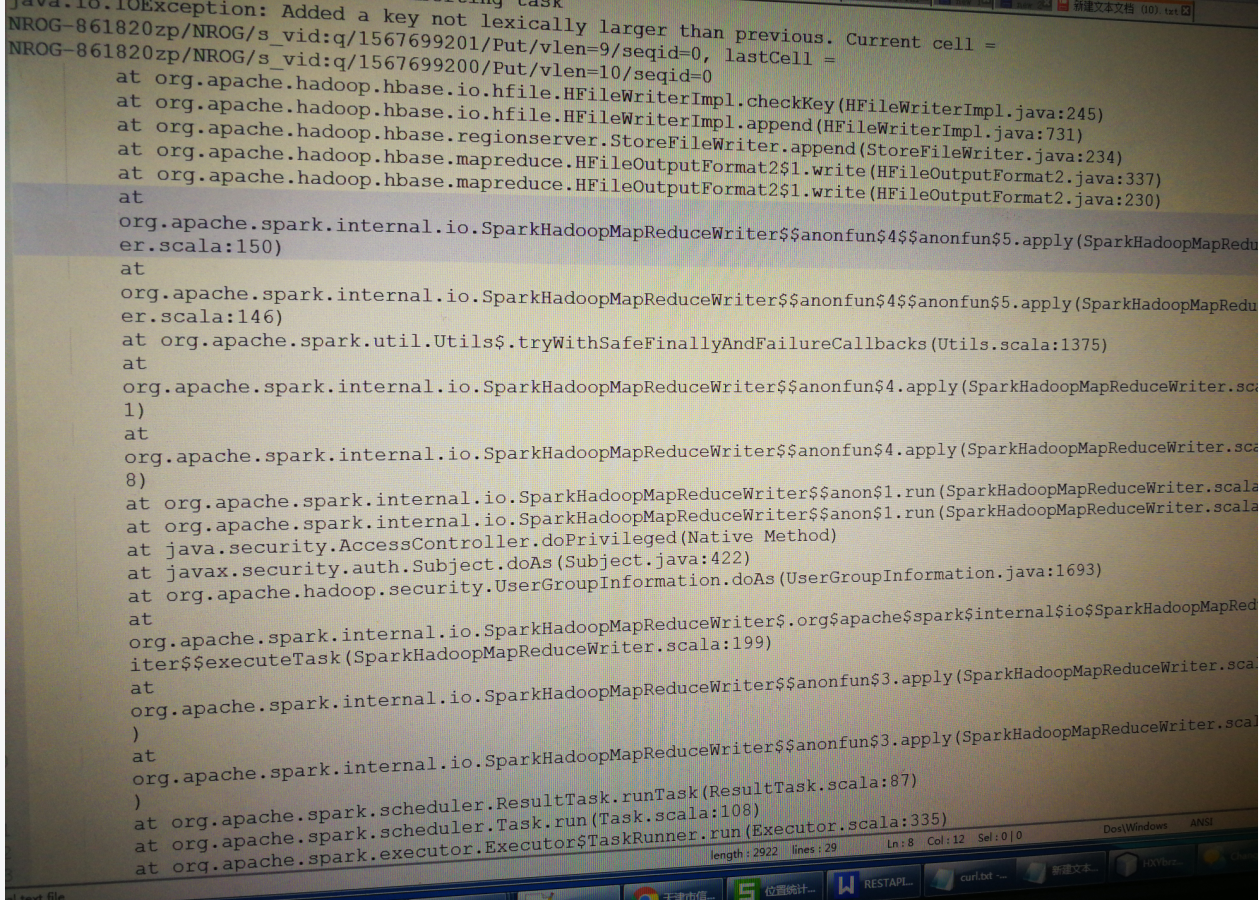

请教各位大神,hbase2.0 spark批量导入时报这个,有人碰到过么。已经按rowkey排过序了

本问题来自阿里云开发者社区的【11大垂直技术领域开发者社群】。 https://developer.aliyun.com/article/706511 点击链接欢迎加入感兴趣的技术领域群

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到HBase 2.0与Spark批量导入数据时出现错误,即使已经按照RowKey排序,这可能是由多种原因导致的。这里有几个可能的解决方案和排查方向:

版本兼容性问题:首先确认你使用的Spark版本与HBase客户端版本是否兼容。有时候特定版本的组合可能会有已知的问题。建议查阅官方文档或社区论坛,确认是否有推荐的版本搭配。

数据格式问题:虽然你提到数据已经按RowKey排序,但还需要确保其他方面也符合要求,比如列族、列限定符等是否正确设置,以及数据本身是否有特殊字符或编码问题影响写入。

Spark配置:检查你的Spark作业配置,特别是与HBase连接相关的设置,例如hbase.zookeeper.quorum、hbase.zookeeper.property.clientPort等。同时,确保使用了正确的HBase连接器(如hbase-spark或spark-hbase-connector),并根据所用版本正确配置。

批处理大小:批量导入时,尝试调整Spark作业的批处理大小(如通过spark.hadoop.hbase.mapreduce.batchsize配置项)。过大的批次可能导致内存溢出或连接超时,而过小则会增加任务调度开销。

日志分析:查看Spark作业运行的日志,尤其是错误堆栈信息,这通常能提供更具体的错误原因。日志中可能会提示是网络问题、权限问题还是数据格式不匹配等问题。

资源限制:检查Spark集群的资源分配情况,包括CPU、内存和网络带宽。资源不足也可能导致写入失败。

使用HFile直接导入:如果上述方法都无法解决问题,可以考虑先将数据转换为HFile格式,然后直接导入到HBase中。这种方法绕过了Spark直接写入的步骤,有时能解决复杂的数据导入问题。

记得在进行任何配置更改或测试之前备份相关数据和配置,以避免不必要的数据丢失或系统不稳定。如果问题依然存在,建议在阿里云开发者社区或Stack Overflow等技术论坛上详细描述问题,并附上错误日志,这样可以获得更专业的帮助。