刚刚开始接触阿里云大数据开发平台,通过官方文档看到,是完全支持原生spark的任务的提交,于是按照文档的环境配置,搭建了spark-2.3.0版本的客户端环境,但是在提交任务的过程中,已local[N]的模式提交,运行spark下的example的demo没有问题,运行自己的测试代码也没有任何问题,但是一旦以yarn-cluster模式提交,就会出现一个错误,目前没有解决的相关头绪,报错截图如下,往各位前辈,能指点一下,任务是以pyspark的方式提交,任务脚本为python开发

提交命令如下: spark-submit --master yarn-cluster --jars odps-spark-datasource_2.11.3.3.3_public.jar example/pi.py

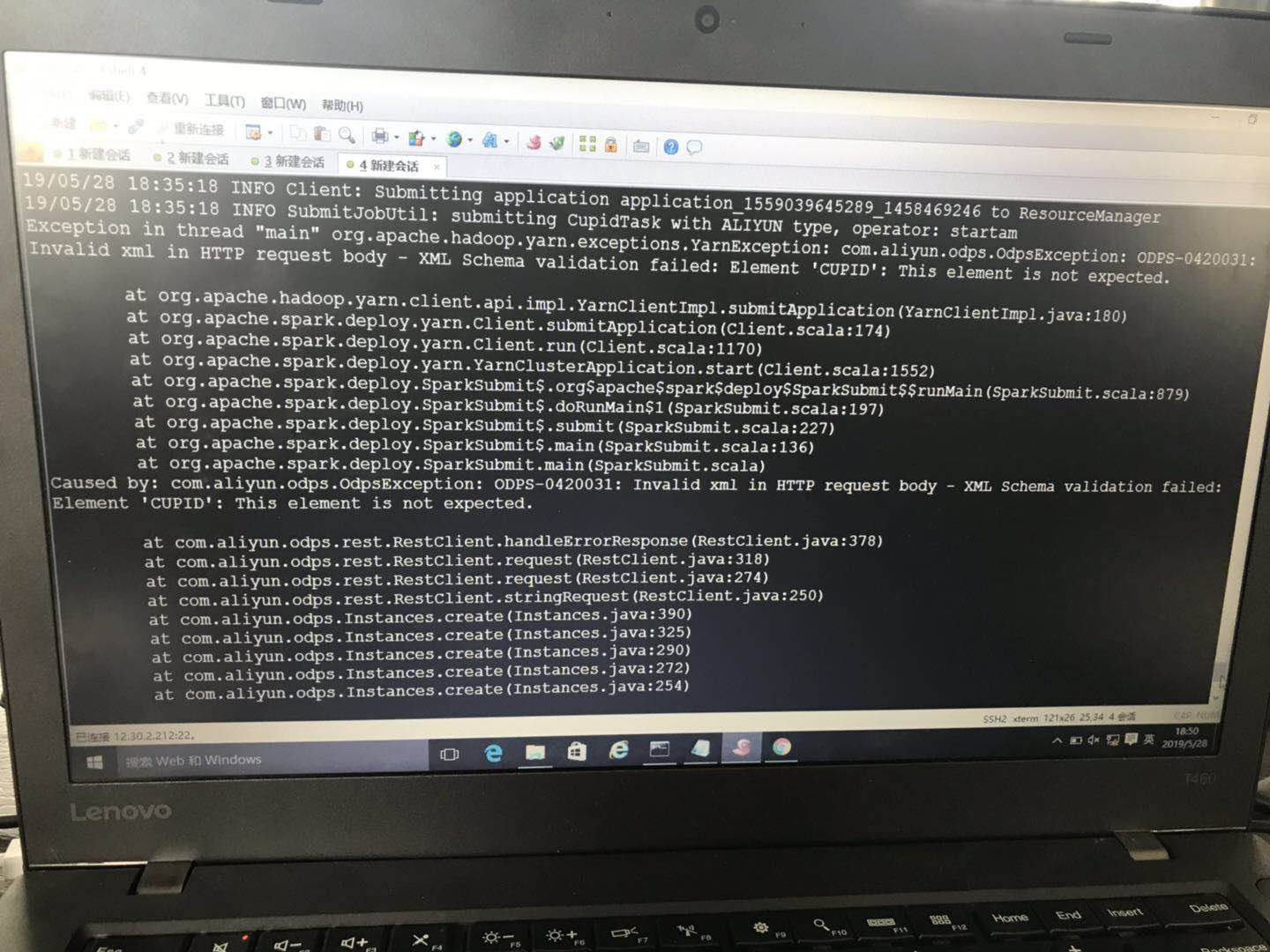

报错内容大致为 发送请求时,对某个xml文件解析出现问题,但是我没有找到任何关于xml文件的信息

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到您描述的问题,看起来是与YARN集群模式下Spark任务提交时的配置或环境问题相关。错误提示中提到的XML文件解析问题可能与Hadoop或YARN的配置有关,尤其是当使用特定JAR包(如odps-spark-datasource)时,可能会涉及到额外的配置需求或兼容性问题。

以下是一些排查和解决此问题的建议:

检查YARN配置:确保YARN集群的配置正确无误,特别是yarn-site.xml、core-site.xml等配置文件。这些配置文件中包含了YARN服务运行所需的参数,如果存在路径错误或其他格式问题,可能导致启动任务时解析XML出错。

Spark版本与Hadoop/YARN兼容性:确认您的Spark 2.3.0版本与阿里云大数据开发平台上的Hadoop和YARN版本兼容。不兼容的版本组合可能会导致各种难以预料的问题。通常,阿里云会推荐使用特定版本的Spark以保证最佳兼容性。

Classpath问题:在使用特定库(如odps-spark-datasource)时,确保所有必要的依赖都已正确添加到类路径中。有时候,缺少或冲突的库会导致间接的解析错误,尽管错误信息可能指向XML文件。

日志详细分析:查看YARN的日志文件,特别是ApplicationMaster的日志,这将提供更详细的错误上下文。错误信息中的XML文件名可能是一个线索,即使直接在你的代码或命令中没有显式提及,也可能是在某个底层库或框架初始化过程中被引用。

资源管理器和节点管理器状态:确认YARN的ResourceManager和NodeManager服务运行正常,没有异常日志。有时,服务端的问题也会表现为客户端提交任务时的错误。

网络和权限:虽然不太常见,但网络问题或文件系统访问权限不足也可能导致类似错误,尤其是在尝试读取或写入某些配置文件时。

更新或回退:如果上述步骤都无法解决问题,考虑更新Spark或相关库到最新稳定版,或者回退到一个已知工作良好的版本组合。

咨询阿里云技术支持:如果问题仍然存在,建议联系阿里云的技术支持团队,他们能提供针对阿里云平台的具体指导和帮助,甚至可能是已知问题的官方解决方案。

希望这些建议能帮助您定位并解决问题。