@TOC

论文名称:Locally Connected Deep Learning Framework for Industrial-scale Recommender Systems

原文地址:Locally Connected Deep

⚡本系列历史文章⚡

【推荐系统论文精读系列】(一)--Amazon.com Recommendations

【推荐系统论文精读系列】(二)--Factorization Machines

【推荐系统论文精读系列】(三)--Matrix Factorization Techniques For Recommender Systems

【推荐系统论文精读系列】(四)--Practical Lessons from Predicting Clicks on Ads at Facebook

【推荐系统论文精读系列】(五)--Neural Collaborative Filtering

【推荐系统论文精读系列】(六)--Field-aware Factorization Machines for CTR Prediction

【推荐系统论文精读系列】(七)--AutoRec Autoencoders Meet Collaborative Filtering

【推荐系统论文精读系列】(八)--Deep Crossing:Web-Scale Modeling without Manually Crafted Combinatorial Features

【推荐系统论文精读系列】(九)--Product-based Neural Networks for User Response Prediction

【推荐系统论文精读系列】(十)--Wide&Deep Learning for Recommender Systems

【推荐系统论文精读系列】(十一)--DeepFM A Factorization-Machine based Neural Network for CTR Prediction

一、摘要

在这项工作中,我们提出了一个局部连接的深度学习框架推荐系统,该框架将DNN的模型复杂性降低了几个数量级。我们利用Wide& Deep模型的思想进一步扩展了框架。实验表明,该方法能在较短的运行时间内取得较好的效果。

二、介绍

在许多实际的推荐系统中,大多数特征都是分类的,这些特征通常被离散化为一种热表示。离散化和特征交叉后的输入特征大小很容易达到数百万甚至数十亿。表1总结了我们使用的真实数据集,其中超过99.9%的数据集是稀疏特征。尽管深度学习模型具有引人注目的优势,但由于参数空间大幅增加,要将其扩展到工业规模仍具有挑战性。如果我们能够找到一种有效的方法来处理特征稀疏问题并压缩模型,那么在行业中实施深度学习模型将是一个很有前途的选择。在本工作中,我们提出了一种通用的局部连接的深度学习框架来处理大规模的工业级推荐任务,该框架将一热的稀疏特征转化为密集的输入,并显著降低了模型的尺寸。我们在多个工业规模的数据集上测试了该框架,并将其部署在支付宝推荐系统上。实验表明,该方法能在较短的时间内取得较好的效果。

三、模型架构

逻辑回归由于其简单、可扩展性强,在工业推荐系统中得到了广泛的应用。在本节中,我们首先介绍LR及其对等物,然后介绍一个有效解决稀疏性和可伸缩性问题的本地连接DNN。

3.1 逻辑回归和它的等价体

LR训练回归模型

M1和M2是等效的3层模型的参数,其中M1是一个只有d值的稀疏“对角”矩阵1,M2是值为1的密集向量。我们将此等效模型称为本地连接网络。在下一节中,我们将这个想法扩展到DNN的案例中。

注解:作者改进的局部连接模型和MLP是有所区别的,我刚开始看的时候以为这不就是MLP嘛,多加了一层,后来看不是,它在输入层和隐层之间的权重不是全连接,而是每个类别特征编码后的分量进行局部连接,意思就是每个特征自己进行全连接,并不是将所有的特征全部进行连接,这也就是为什么要叫做Locally Connected。

而且这样改进后并不会更改模型的结果,因为在隐层和输出层之间的权重全部为1,所以结果是不变的。

关于这个公式的说明:

由于要做到局部连接,即只有对应的特征分量才会进行全连接,所有作者使用对角矩阵,只有需要连接的地方为实值,其余地方都是0,和MLP的公式一个道理,只是这里不连接的地方置为0,这样就能够实现局部连接,不需要的地方是0就不会传递到下一层进行训练了。

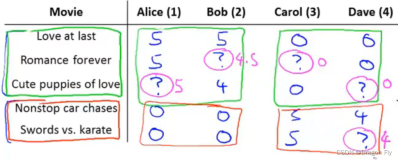

3.2 DNN的局部连接

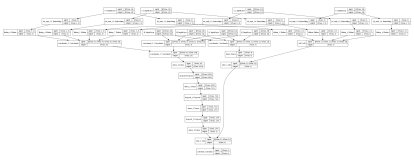

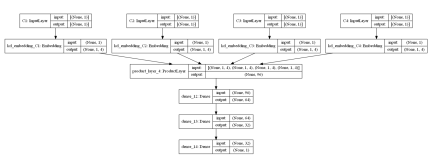

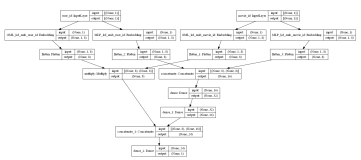

DNN通过多层次非线性变换,从低级特征中分层学习高级抽象,显著优于LR在各种任务中的表现。为了便于解释,我们首先在图4(a)中给出了一个四层DNN。

式中

注解:这两个层不同的地方就是第一个隐层那里,4层结构就是简单的MLP架构,5层就是改进之后的,多引入了一个层用于分类特征局部连接,对应着

使模型复杂关键的地方就是第一个隐层,因为它的权重矩阵为

我们进一步将DNN压缩为5层局部连接的DNN模型(LC-DNN),如图4(b)和图5所示。如图1所示,LR可以对M1进行预训练。在实际的实现中,我们首先训练一个基于离散特征的LR。然后将学习到的LR权值输入LC-DNN,这些权值与其他参数联合训练。

注解:这个模型的意思是首先将不同的类别特征进行OneHot或者Embedding操作将其离散化,然后基于离散后的特征进行局部连接,然后在第一个Feature Embedding层中将局部连接获得的向量与连续性向量进行拼接,然后输出到之后的MLP架构中。

四、实验结果

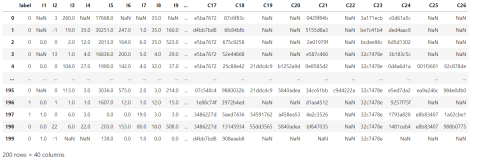

我们在两个真实世界的数据集上测试了我们提出的方法对LR和DNN的性能。表1总结了所使用的数据集。所有模型都是在我们自己的参数服务器[4]实现上实现的,并在集群上进行训练。

4.1 参数大小

首先,在我们的数据集上,从理论上比较LR、四层DNN和

4.2 效果

我们使用接收算子曲线下面积(AUC)来衡量解决方案的质量。从表4中我们可以看出,LC-DNN和LC-W&D的AUC均高于LR和DNN。

4.3 运行时间

图6记录了每个epoch的平均训练时间,以秒为单位。图6显示,我们提出的方法将DNN的运行时间提高了一个数量级。由于集群上分布式实现的自动负载平衡和通信开销,运行时的减少并不像理论估计的那样显著。

五、结论

在这项工作中,我们提出了一个局部连接的深度学习框架推荐系统,该框架将DNN的模型复杂性降低了几个数量级。我们利用Wide& Deep模型的思想进一步扩展了框架。实验表明,该方法能在较短的运行时间内取得较好的效果。

References

[1] H.-T. Cheng, L. Koc, J. Harmsen, et al. Wide & deep learning for recommender systems. In 1st Workshop on Deep Learning for RecSys, pages 7–10, 2016.

[2] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. CoRR, 2015.

[3] Y. LeCun, Y. Bengio, and G. Hinton. Deep learning.Nature, 521(7553):436–444, 2015.

nition. CoRR, 2015.

[3] Y. LeCun, Y. Bengio, and G. Hinton. Deep learning.Nature, 521(7553):436–444, 2015.

[4] E. P. Xing, Q. Ho, W. Dai, et al. Petuum: A new platform for distributed machine learning on big data.IEEE Transactions on Big Data, 1(2):49–67, 2015.