解决问题

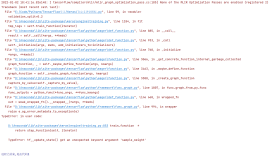

FutureWarning: max_iter and tol parameters have been added in <class 'sklearn.linear_model.stochastic_gradient.SGDClassifier'> in 0.19. If both are left unset, they default to max_iter=5 and tol=None. If tol is not None, max_iter defaults to max_iter=1000. From 0.21, default max_iter will be 1000, and default tol will be 1e-3.

"and default tol will be 1e-3." % type(self), FutureWarning)

类似的问题

linear_model\stochastic_gradient.py:128: FutureWarning: max_iter and tol parameters have been added in <class 'sklearn.linear_model.stochastic_gradient.SGDRegressor'> in 0.19. If both are left unset, they default to max_iter=5 and tol=None. If tol is not None, max_iter defaults to max_iter=1000. From 0.21, default max_iter will be 1000, and default tol will be 1e-3.

"and default tol will be 1e-3." % type(self), FutureWarning)

解决思路

未来警告:在0.19中的<class'sklearn.linear_model.randomatic_gradient.sgdclassifier'>中添加了max_iter和tol参数。如果两个都未设置,则默认为max_iter=5,tol=none。如果tol不是none,max-iter默认为max-iter=1000。从0.21开始,默认的最大值为1000,默认的公差为1e-3。“默认TOL将为1E-3。

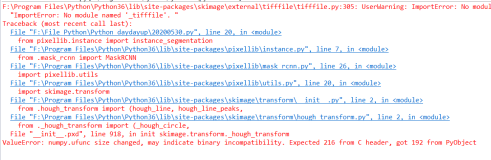

解决方法

此信息提示为警告,而不是error,即使不处理也不会影响代码编程的运行。如果想要去掉,可以更新库至最新版本!

然后根据提示修改使用方法!

stochastic_gradient模块已经被重构,在未来的版本中默认参数有所改变!

然后使用最新版本stochastic_gradient方法,并要知道默认参数已经随着版本升级而改变了。