OpenClaw(前身为Clawdbot、Moltbot)作为一款开源AI个人助手,支持本地部署与多平台兼容,能通过自然语言指令实现设备控制、任务自动化及多工具协同,广泛适配Qwen、Claude、GPT等主流大语言模型。若需让OpenClaw具备更强大的智能交互与任务处理能力,可接入阿里云百炼平台的大模型服务(如通义千问3系列)。本文将严格遵循技术实操逻辑,详细拆解从环境准备、API获取到配置验证的完整流程,确保操作步骤的准确性与可落地性。

一、核心概念与适用场景

在开始配置前,需明确关键概念与适用范围,帮助理解操作的核心意义,避免因认知偏差导致配置失误。

(一)核心工具定义

OpenClaw(原Clawdbot/Moltbot)

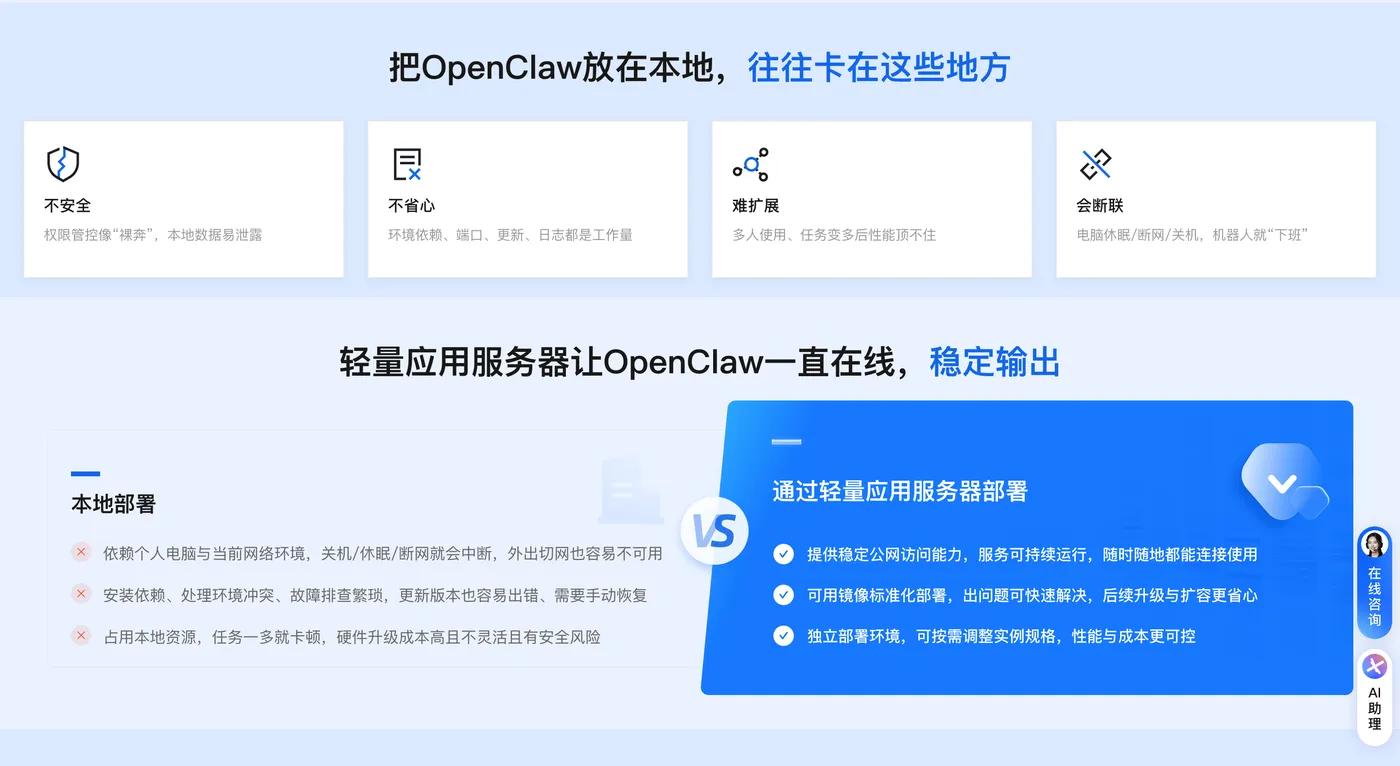

一款开源的本地化AI智能体平台,定位为“24小时在线的个人AI助手”,支持MacOS、Windows、Linux多操作系统部署,访问阿里云 OpenClaw(原Clawdbot)一键部署页面,快速部署。其核心能力包括:通过自然语言处理日常任务(如邮件管理、日程安排、文档生成)、连接各类API与服务构建自定义自动化流程、作为个人知识库提供即时问答,同时支持集成钉钉、iMessage、Telegram等多渠道通信工具,实现跨平台指令交互。

阿里云上线了 OpenClaw(原Clawdbot)一键部署功能,开箱即用,教程:https://www.aliyun.com/activity/ecs/clawdbot

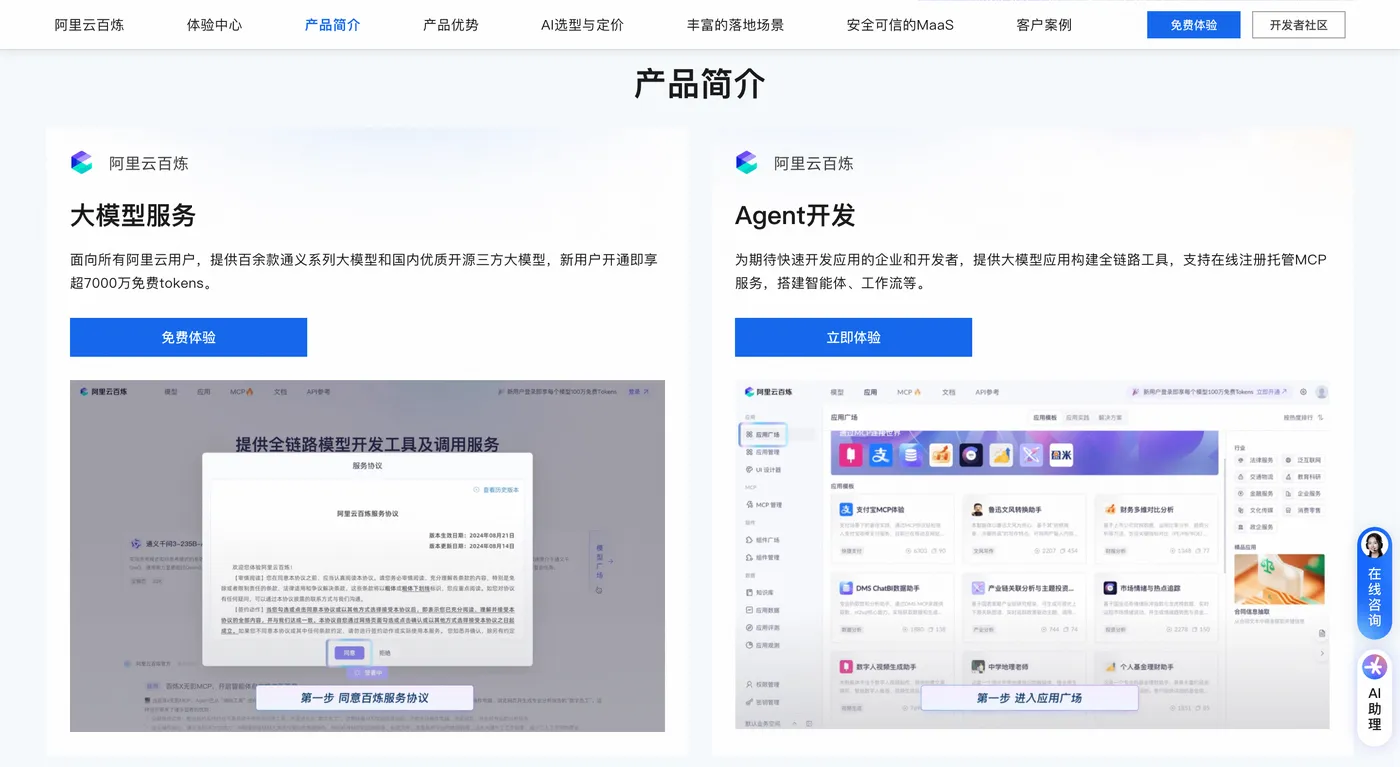

阿里云百炼

阿里云推出的一站式大模型开发与应用构建平台,提供从模型选择、开发调试到部署落地的全流程支持。平台内置通义千问全系列模型(如Qwen3-Max、Qwen-Plus、Qwen-VL等)及第三方开源模型(如Llama、ChatGLM),支持OpenAI-compatible接口规范,可与OpenClaw无缝对接,为其提供智能推理、语言生成、多模态处理等核心能力。

(二)适用场景

本次配置方案适用于以下需求场景,帮助用户明确配置价值:

- 构建24小时在线AI助手:通过OpenClaw部署全天候服务,结合阿里云百炼模型的强推理能力,实现夜间自动处理邮件、生成日报等任务;

- 日常任务自动化:如定时搜索行业资讯并整理成结构化文档、自动同步日程至多个设备、批量处理表格数据等;

- 自定义工具集成:连接企业内部系统或第三方API(如阿里云OSS、GitHub),通过自然语言指令触发复杂工作流(如代码提交后自动生成测试报告);

- 个人知识库搭建:将本地文档、网页收藏等内容导入OpenClaw,借助百炼模型的检索增强生成(RAG)能力,实现精准问答与知识总结。

二、配置前置条件与环境准备

配置前需完成基础环境检查与工具安装,确保后续步骤无依赖冲突,这是保障配置成功的关键前提。

(一)检查Node.js版本

OpenClaw运行依赖Node.js环境,且要求版本≥22,低于该版本会导致服务启动失败或功能异常,需按以下步骤验证与升级:

版本验证

打开终端(MacOS/Linux系统)或PowerShell(Windows系统),输入以下命令查看当前Node.js版本:node -v若输出结果为

v22.x.x(如v22.1.0),则满足要求;若版本低于22(如v20.10.0),需执行升级操作。版本升级(以nvm工具为例)

推荐使用nvm(Node Version Manager)工具管理Node.js版本,操作步骤如下:- 安装nvm(若未安装):

- MacOS/Linux系统:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash # 或使用wget wget -qO- https://raw.githubusercontent.com/nvm-sh/nvm/v0.39.7/install.sh | bash - Windows系统:需安装nvm-windows,访问https://github.com/coreybutler/nvm-windows/releases下载最新安装包,按指引完成安装。

- MacOS/Linux系统:

- 安装并切换Node.js 22版本:

# 安装Node.js 22 nvm install 22 # 切换至22版本 nvm use 22 - 升级完成后,重新执行

node -v验证版本是否生效。

若偏好其他工具(如fnm、brew),可参考对应工具的官方文档完成版本升级,核心目标是确保Node.js版本≥22。

- 安装nvm(若未安装):

(二)安装OpenClaw(原Clawdbot/Moltbot)

根据操作系统选择对应的安装方式,推荐使用官方一键安装脚本,简化依赖配置与环境搭建流程。

MacOS/Linux系统安装

打开终端,输入以下一键安装命令,脚本会自动下载并配置OpenClaw核心程序与依赖:curl -fsSL https://clawd.bot/install.sh | bash脚本执行过程中,会提示阅读《OpenClaw安全说明》,内容包含:OpenClaw的Agent可执行系统命令、读写本地文件,建议新用户从“沙箱模式”与“最小权限”开始使用,降低安全风险。阅读完成后,输入

Yes确认继续。随后进入“Onboarding模式”选择,推荐新手选择

QuickStart(快速启动),系统会默认配置Gateway端口(18789),模型提供方选择Skip for now(后续手动配置阿里云百炼),避免因默认模型选择导致的配置冲突。Windows系统安装

打开PowerShell(需以管理员身份运行),输入以下命令:iwr -useb https://clawd.bot/install.ps1 | iex后续流程与MacOS/Linux一致,完成安全说明确认与QuickStart模式配置。

备选安装方式(全局安装)

若一键脚本安装失败,可通过包管理器(npm/pnpm)全局安装,步骤如下:- npm方式:

npm install -g clawdbot@latest - pnpm方式(需先安装pnpm:

npm install -g pnpm):

安装成功后,终端会显示OpenClaw版本信息(如“Clawdbot 2026.1.24-3 (885167d)”),并提示“Installation complete”,说明安装完成。pnpm add -g clawdbot@latest

- npm方式:

三、获取阿里云百炼API关键信息

OpenClaw调用阿里云百炼模型需三项核心信息:API Key(身份凭证)、base_url(模型调用地址)、model code(模型名称),需按步骤完成获取与保管。

(一)登录阿里云百炼平台

访问阿里云百炼大模型服务平台(https://bailian.console.aliyun.com),使用已完成实名认证的阿里云账号登录。若未完成实名认证,需先通过“账号中心→实名认证”完成认证(个人用户支持身份证刷脸或支付宝授权,企业用户需上传营业执照,审核周期1-3个工作日),否则无法创建API Key与调用模型。

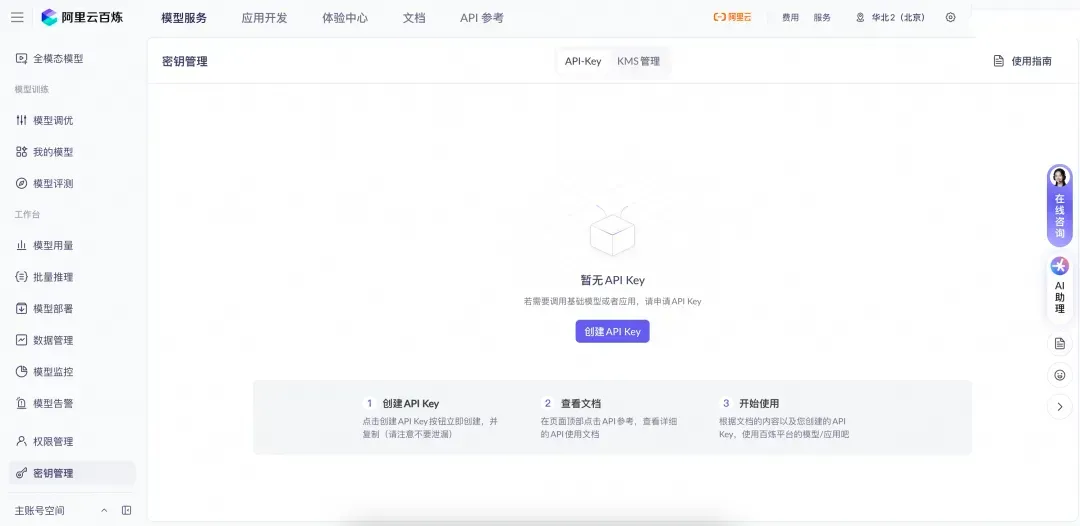

(二)创建并获取API Key

API Key是OpenClaw调用百炼模型的核心凭证,泄露可能导致模型调用额度被盗用,需严格按以下步骤操作:

- 进入密钥管理页面

在百炼平台导航栏中,依次点击“控制台→密钥管理”,选择地域(支持北京、新加坡等,不同地域的API Key独立,建议选择与后续服务器部署地域邻近的区域,降低网络延迟)。

生成API Key

点击页面右上角“创建API-Key”,系统会自动生成一组密钥,包含“Access Key ID”与“Access Key Secret”两个字段。点击每个字段后的“复制”按钮,将密钥粘贴至本地记事本或加密文档中保存,切勿截图或分享给他人。

注意:API Key仅在创建时显示完整内容,后续无法再次查看,需立即保存;若怀疑密钥泄露,需在“密钥管理”页面点击“禁用”或“删除”,并重新创建新密钥,避免产生额外费用。查看模型调用额度

新用户开通百炼平台后,可领取免费调用额度(具体额度以平台当前政策为准),点击“控制台→额度管理”,可查看可用额度、过期时间等信息。若额度已耗尽,需在平台购买调用套餐(如“通用模型套餐”“视觉模型套餐”),否则API Key配置后无法正常调用模型。

(三)确认模型信息

需记录百炼模型的base_url与model code,确保OpenClaw能正确定位并调用目标模型:

base_url(模型调用地址)

阿里云百炼支持OpenAI-compatible接口,通用base_url为:https://dashscope.aliyuncs.com/compatible-mode/v1若后续使用“百炼Coding Plan”套餐(针对开发场景优化的模型服务),base_url需替换为:

https://coding.dashscope.aliyuncs.com/v1model code(模型名称)

推荐选择以下两款适配OpenClaw的主流模型,可根据使用场景选择:- qwen3-max-2026-01-23:通义千问3系列旗舰推理模型(Qwen3-Max-Thinking),支持复杂推理、工具调用与256K上下文窗口,适用于多步骤任务(如代码生成、数据分析);

- qwen-plus:通义千问3系列均衡型模型,兼顾效果、速度与成本,支持1M上下文窗口,适用于日常对话、文档总结等轻量场景。

更多模型及model code可在百炼平台“模型广场”查询,选择时需确认模型支持“OpenAI-compatible接口”,避免因接口不兼容导致调用失败。

四、配置环境变量(保障API Key安全)

为避免将API Key直接写入配置文件导致泄露风险,推荐将其配置到系统环境变量中,通过变量引用的方式调用,步骤如下:

(一)确认默认Shell类型

首先需判断终端使用的Shell类型(常见为zsh或bash),执行以下命令:

echo $SHELL

- 若输出

/bin/zsh,则为zsh用户; - 若输出

/bin/bash,则为bash用户。

(二)配置环境变量(zsh用户)

写入环境变量

执行以下命令,将API Key追加到~/.zshrc文件(zsh的配置文件)中,需将“YOUR_DASHSCOPE_API_KEY”替换为实际获取的百炼API Key:echo "export DASHSCOPE_API_KEY='YOUR_DASHSCOPE_API_KEY'" >> ~/.zshrc使配置生效

执行以下命令,加载更新后的配置文件:source ~/.zshrc验证配置

重新打开一个终端窗口,执行以下命令,若输出之前配置的API Key,则说明环境变量配置成功:echo $DASHSCOPE_API_KEY

(三)配置环境变量(bash用户)

写入环境变量

执行以下命令,将API Key追加到~/.bash_profile文件(bash的配置文件)中:echo "export DASHSCOPE_API_KEY='YOUR_DASHSCOPE_API_KEY'" >> ~/.bash_profile使配置生效

执行以下命令加载配置:source ~/.bash_profile验证配置

重新打开终端,执行echo $DASHSCOPE_API_KEY,确认输出API Key即可。

五、编辑OpenClaw配置文件(对接百炼模型)

OpenClaw的模型配置通过clawdbot.json文件实现,需按指定格式写入百炼模型信息,确保字段准确无误(配置文件严格校验,字段错误会导致Gateway启动失败)。

(一)打开配置文件

推荐使用nano编辑器(轻量且易操作)打开配置文件,执行以下命令:

nano ~/.clawdbot/clawdbot.json

若使用其他编辑器(如vim、VS Code),可替换为对应命令(如vim ~/.clawdbot/clawdbot.json)。

(二)写入模型配置(以qwen3-max-2026-01-23为例)

将以下配置内容粘贴到clawdbot.json文件中,需注意保持JSON格式规范(逗号、引号不可遗漏):

{

"agents": {

"defaults": {

"model": {

"primary": "bailian/qwen3-max-2026-01-23" },

"models": {

"bailian/qwen3-max-2026-01-23": {

"alias": "通义千问 Max Thinking 版" }

}

}

},

"models": {

"mode": "merge",

"providers": {

"bailian": {

"baseUrl": "https://dashscope.aliyuncs.com/compatible-mode/v1",

"apiKey": "${DASHSCOPE_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "qwen3-max-2026-01-23",

"name": "通义千问 Max Thinking 版",

"reasoning": false,

"input": ["text"],

"cost": {

"input": 0.0025, "output": 0.01, "cacheRead": 0, "cacheWrite": 0 },

"contextWindow": 262144,

"maxTokens": 65536

}

]

}

}

}

}

(三)配置字段说明

需理解关键字段的含义,便于后续根据需求调整:

- agents.defaults.model.primary:指定OpenClaw默认使用的模型,格式为“provider/model”(“bailian”为百炼的自定义provider名称,不可修改);

- agents.defaults.models:为模型设置别名,便于在交互中识别(如“通义千问 Max Thinking 版”);

- models.providers.bailian.baseUrl:百炼模型的调用地址,需与之前确认的base_url一致;

- models.providers.bailian.apiKey:引用环境变量中的API Key(

${DASHSCOPE_API_KEY}),避免硬编码; - models.providers.bailian.models.id:模型的model code,需与百炼平台一致;

- contextWindow:模型支持的最大上下文窗口(单位:Token),qwen3-max-2026-01-23为262144 Token(约20万字);

- maxTokens:单次请求的最大输出Token数,qwen3-max-2026-01-23为65536 Token。

(四)适配qwen-plus模型的配置(可选)

若需使用qwen-plus模型,可替换为以下配置:

{

"agents": {

"defaults": {

"model": {

"primary": "bailian/qwen-plus" },

"models": {

"bailian/qwen-plus": {

"alias": "通义千问 Plus" }

}

}

},

"models": {

"mode": "merge",

"providers": {

"bailian": {

"baseUrl": "https://dashscope.aliyuncs.com/compatible-mode/v1",

"apiKey": "${DASHSCOPE_API_KEY}",

"api": "openai-completions",

"models": [

{

"id": "qwen-plus",

"name": "通义千问 Plus",

"reasoning": false,

"input": ["text"],

"cost": {

"input": 0.008, "output": 0.008, "cacheRead": 0, "cacheWrite": 0 },

"contextWindow": 1048576,

"maxTokens": 32000

}

]

}

}

}

}

(五)保存配置文件

使用nano编辑器时,按Ctrl + X,再按Y确认保存,最后按Enter退出编辑器,完成配置文件修改。

六、配置生效与模型调用验证

完成配置后,需重启OpenClaw服务并验证模型是否能正常调用,确保整个对接流程无问题。

(一)重启OpenClaw Gateway服务

执行以下命令,重启Gateway服务(OpenClaw的核心服务,负责模型调用与指令处理):

clawdbot gateway restart

若输出“Restarted LaunchAgent: gui/501/com.clawdbot.gateway”(MacOS系统)或类似提示,说明服务重启成功。

(二)查看模型是否被识别

执行以下命令,查看OpenClaw是否已加载百炼模型:

clawdbot models list

正常情况下,终端会显示类似以下结果:

Clawdbot 2026.1.24-3 (885167d) - No $999 stand required.

Model Input Ctx Local Auth Tags

bailian/qwen3-max-2026-01-23 text 256k no - default, configured, alias:通义千问 Max Thinking 版

若列表中包含目标模型,说明模型已被成功识别。

(三)模型连通性探测(真实请求验证)

执行以下命令,发送真实请求探测模型是否能正常响应(会消耗百炼模型调用额度,需注意成本):

clawdbot models status --probe

若输出类似以下结果,且“Status”列为“ok”,说明模型调用正常:

Clawdbot 2026.1.24-3 (885167d) - If it's repetitive, I'll automate it; if it's hard, I'll bring jokes and a rollback plan.

...

Auth probes

| Model | Profile | Status |

|--------------------------------|------------------|--------------|

| bailian/qwen3-max-2026-01-23 | models.json (api_key) | ok·9.4s |

Probed 1 target in 9.4s

若“Status”列为“error”,需根据提示排查问题(如API Key错误、网络不通、额度不足)。

(四)简单对话场景验证

通过终端发送自然语言指令,验证模型的交互能力,执行以下命令(以“介绍阿里云百炼”为例):

clawdbot agent --agent main --message "介绍下阿里云百炼"

正常情况下,OpenClaw会调用百炼模型生成响应,示例输出如下:

Clawdbot 2026.1.24-3 (885167d) - Because Siri wasn't answering at 3AM.

阿里云百炼(Bailian)是阿里云推出的一站式大模型开发及应用构建平台,旨在帮助开发者和企业快速、低成本地创建基于大模型的AI应用。其核心功能包括:

1. 开箱即用的大模型服务:集成通义千问全系列模型(如Qwen3-Max、Qwen-Plus)及第三方开源模型,提供统一API接口,支持快速切换模型;

2. 低代码应用构建:可视化Prompt工程、拖拽式工作流编排,内置RAG与Agent框架,降低开发门槛;

3. 模型微调能力:支持全参数微调与高效微调(如LoRA),自动化数据处理与模型评估;

4. 企业级安全部署:支持一键部署为API服务或Serverless函数,深度集成阿里云生态(如OSS、MaxCompute)。

若能正常生成符合要求的响应,说明OpenClaw与阿里云百炼的对接已完全成功。

七、常见问题与排查方案

配置过程中可能因环境差异、操作失误出现问题,以下整理高频问题及解决方案,帮助快速定位并解决。

(一)Gateway启动失败(提示配置错误)

现象:执行clawdbot gateway restart后,服务未启动;或执行clawdbot models list无模型显示。

排查步骤:

- 执行

clawdbot doctor命令,查看具体报错信息(该命令会检测配置文件格式、依赖状态等); - 若提示“JSON syntax error”,说明

clawdbot.json格式错误,需重新检查逗号、引号是否遗漏,可使用JSON在线校验工具验证格式; - 若提示“unknown field 'xxx'”,说明配置文件中存在多余字段,需删除未定义的字段(参考本文提供的配置模板);

- 若提示“apiKey not found”,检查环境变量是否配置正确,执行

echo $DASHSCOPE_API_KEY确认是否输出API Key。

(二)模型探测失败(Status为error)

现象:执行clawdbot models status --probe后,模型状态显示“error”。

排查步骤:

- API Key有效性:登录百炼平台“密钥管理”,确认API Key未被禁用或删除,重新创建并更新环境变量;

- 网络连通性:执行

ping dashscope.aliyuncs.com,检查是否能正常访问百炼服务器,若无法ping通,需检查防火墙是否放行出站流量; - 额度状态:查看百炼“额度管理”,确认有可用调用额度,额度耗尽需购买套餐;

- base_url正确性:确认配置文件中的base_url与使用场景匹配(通用场景为

https://dashscope.aliyuncs.com/compatible-mode/v1,Coding Plan为https://coding.dashscope.aliyuncs.com/v1)。

(三)终端指令无响应(提示“gateway closed”)

现象:执行clawdbot agent命令后,提示“Gateway closed (108 abnormal closure)”。

排查步骤:

- 重启Gateway服务:

clawdbot gateway restart; - 检查端口占用:执行

lsof -i :18789(MacOS/Linux)或netstat -ano | findstr :18789(Windows),查看18789端口是否被其他程序占用,若占用需关闭对应程序或修改OpenClaw的Gateway端口(在clawdbot.json中添加"gateway": {"port": 18790}字段,更换为未占用端口)。

八、总结

本文详细拆解了在OpenClaw(原Clawdbot/Moltbot)中配置阿里云百炼API的完整流程,从环境准备、API获取到配置验证,每一步均遵循官方技术规范,确保操作可落地。核心关键点包括:

- 环境依赖:Node.js版本≥22是服务运行的基础,需通过nvm等工具完成升级;

- 安全配置:将API Key写入环境变量,避免硬编码导致泄露;

- 配置规范:严格遵循

clawdbot.json的字段格式,错误配置会导致Gateway启动失败; - 验证流程:通过模型列表查看、连通性探测、对话测试三步,确保模型调用正常。

通过本次配置,OpenClaw可借助阿里云百炼的强模型能力,实现更复杂的任务处理与智能交互。后续若需扩展功能(如集成钉钉、iMessage),可参考OpenClaw官方文档或阿里云相关教程,进一步提升工具的实用性。使用过程中,需定期备份配置文件与凭证,确保服务稳定运行。