NeurIPS 2025!采样成本降 50%+ 准确率提升!南大等团队的RPC方法刷新 LLM 推理上限

论文标题:A Theoretical Study on Bridging Internal Probability and Self-Consistency for LLM Reasoning

作者团队:南京大学、瑞士苏黎世联邦理工学院

发布时间:2025年10月17日

✅Lab4AI平台提供AI导读和AI翻译等工具,辅助论文阅读。您还可以投稿复现这篇论文~

⭐核心贡献

- 理论框架:首次提出用于分析LLM推理中采样式测试时缩放方法的理论框架,将推理误差分解为估计误差和模型误差。

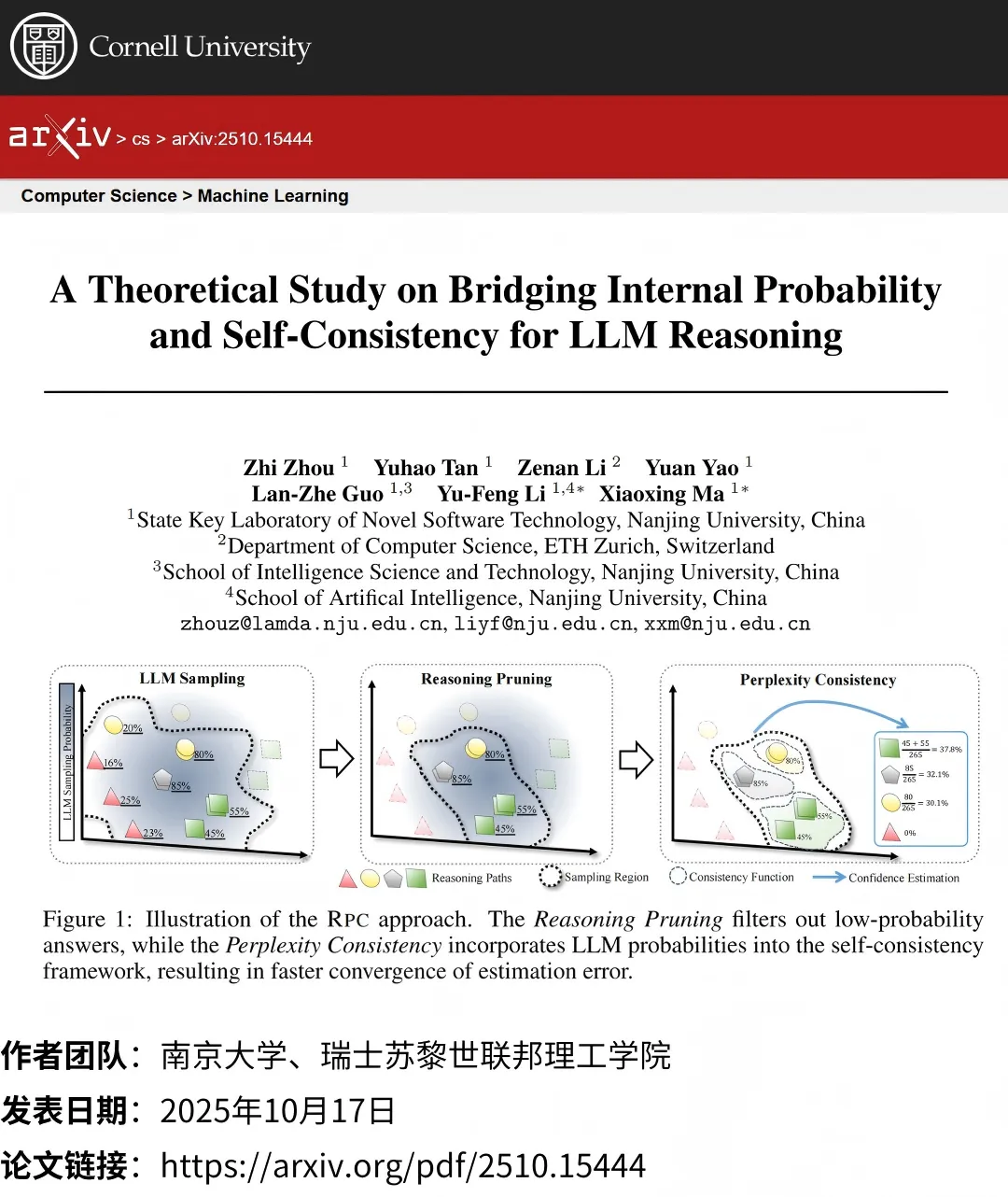

- 方法创新:提出RPC方法,融合自洽性和内部概率的优势,通过Perplexity Consistency和Reasoning Pruning组件解决现有方法的局限性。

- 实证验证:在多个基准数据集上验证RPC的有效性,显著降低采样成本并提升推理性能。

⭐研究方法

- 误差分解理论:将推理误差分解为估计误差(与采样规模和置信度估计策略相关)和模型误差(由LLM固有推理能力决定)。

- 现有方法分析:自洽性估计误差收敛慢(线性),困惑度模型误差大且估计误差优势在低概率路径下退化。

- RPC方法设计:

- Perplexity Consistency:将LLM内部概率融入自洽性框架,以指数级速率降低估计误差。

- Reasoning Pruning:通过混合威布尔分布建模概率分布,自动过滤低概率路径,防止估计误差退化。

⭐研究结果

- 效率提升:RPC在达到与自洽性相同性能时,所需采样数量减少50%以上。

- 性能优化:在7个基准数据集上,RPC平均准确率优于基线方法(如数学推理任务提升1.29%)。

- 可靠性增强:RPC的置信度估计更接近真实置信度(预期校准误差更低)。

- 泛化性验证:在代码生成(如HumanEval)和逻辑推理(如LogiQA)任务中均表现优异。