- 每天9亿次包裹扫描

- 每8毫秒采集一次的工厂数据

- 每小时870万件紧急医疗包流转...

这些数字背后,都离不开同一个名字:Kafka。

当海量数据出现,传统系统常常束手无策。但Kafka却能稳稳接住,让数据高速、有序地流动。

它早已不是普通的“消息队列”,而是支撑现代实时业务的核心引擎。

为什么Kafka能这么快?它用了哪些独特的架构设计扛住千万级流量?

更重要的是,企业想用好Kafka,到底该怎么搭建、怎么应用和管理? 这篇文章,带你一次看透!

一、Kafka为什么这么快?

Kafka的"快",体现在高吞吐+低延迟+能横向扩展这三点上。

说到底,是它在设计、实现和运行环境上,把磁盘和网络I/O的优化做到了极致。

下面从"设计层→实现层→运行层"给大家一步步拆解,为什么它单机能每秒处理百万级消息,集群能到千万级。

1. 设计层:只做append-only log

(1)首先是顺序写盘:

传统消息队列:

比如RabbitMQ,要维护索引、队列、优先级等好多张表,写数据时难免随机操作磁盘。

而Kafka:

把每个分区做成一个只能追加的commit log,生产者写消息就是往文件末尾加,磁盘I/O变成顺序写,速度接近内存。

(2)其次是零拷贝(Zero-Copy)消费:

传统的读和发流程是:

磁盘→内核缓冲区→用户缓冲区→Socket缓冲区→网卡,中间环节多。

而Kafka:

用sendfile系统调用,让数据直接从磁盘通过DMA到网卡,不经过用户态,CPU不用参与搬数据,能省2次上下文切换和2次内存拷贝。

2. 实现层:批量、压缩、索引

(1)先说批量处理(Batching):

生产者端默认:

- 要么等5毫秒(linger.ms=5ms),

- 要么消息攒到16KB(batch.size=16KB)就打包发送,

一次网络往返能发多条消息。

Broker端写入时:

也会攒一批再刷盘,通过log.flush.interval.messages配置,减少磁盘I/O次数。

(2)再看消息压缩:

支持GZIP、Snappy、LZ4、ZSTD等压缩方式,压缩后消息体积能减70%以上,网络带宽和磁盘占用都能大幅下降。

而且:

压缩是按批(batch)来的,压缩比比单条消息压缩高很多。

(3)最后是稀疏索引(Sparse Index):

- 消息在.log文件里顺序存,

- .index文件只记offset和物理位置的对应关系,

- 默认每4KB记一条索引。

查消息时先二分索引找到4KB范围,再顺序扫,兼顾内存占用和查询速度。

3. 运行层:PageCache和横向扩展

由于依赖的是OS PageCache而非JVM堆:

消息直接写到PageCache,由内核异步刷盘,避免Java堆的GC停顿。

读数据时:

如果数据在PageCache里,就像读内存一样快,比从堆里读快得多。

并且分区分段(Partition + Segment):

- 分区并行:一个Topic拆成多个Partition,分布在多台Broker上,能横向扩展吞吐。

- 分段清理:每个Partition再拆成Segment文件,过期的Segment直接删文件,不用在大文件里随机删,开销小。

最重要的是无锁设计:

每个Partition在Broker上对应一个目录,追加写由单个线程处理,没有锁竞争。

可以用:

拉模式(pull)自己控制消费速度,不会像push模式那样出现消费者处理不过来的情况。

简单说,Kafka快的本质就是:用顺序I/O替代随机I/O,用内核优化替代用户态逻辑。

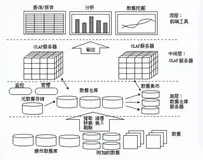

为了更高效的完成实时数据同步,企业使用 Kafka 作为数据同步的中间件时,可以借助数据集成平台FineDataLink暂存来源数据库中的数据,将目标数据库写入数据,实现实时数据同步,并配置后续的数据管道任务和实时任务。

二、Kafka的设计思路:让数据高效流动

Kafka能有这么好的性能,不是偶然的,背后有一套清晰的设计思路:

1. 持久化设计的创新

和传统内存队列不同:

Kafka巧妙利用文件系统和PageCache。

- 数据先写PageCache,

- 再由操作系统异步刷盘。

这样:

可以避免JVM垃圾回收的开销,32GB内存的机器差不多能有28-30GB当缓存。

更重要的是:

就算服务重启,缓存还能用,因为数据一开始就写到了持久化日志里。

2. 效率的三重优化

第一重优化是消息聚合:

把小消息凑成一批处理(message set),减少网络请求次数。

第二重优化是零拷贝传输:

生产者、broker和消费者用相同的二进制格式,数据不用解压重组,通过sendfile系统调用在内核级传输。

第三重优化是批量压缩:

- 在生产者端就用GZIP、Snappy、LZ4等协议压缩消息,

- 在broker端保持压缩状态,

- 到消费者端才解压,能省不少资源。

3. 生产者的负载均衡办法

生产者直接和分区的leader通信,自己决定消息往哪个分区发。

这样做的好处是:

没有传统MQ的路由瓶颈,还支持异步批量发送,要么攒够64KB数据,要么等10ms,灵活平衡延迟和吞吐。

4. 消费者拉取模型的好处

基于pull的模型,让消费者能按自己的处理能力拿数据,不会像push模式那样,消费者处理不过来还一直发。

并且:

配合多线程消费,不同消费者能并行处理自己分到的分区。

这种设计天然支持回溯消费:

如果业务逻辑出错了,重置一下offset就能重放数据,这在实际业务中很有用。

三、Kafka架构的核心:无锁设计和控制器机制

在高吞吐场景下,传统锁机制很容易造成性能瓶颈。

但Kafka靠巧妙的无锁设计解决了这个问题,而控制器则在集群中发挥着关键作用。

1. 无锁设计的实现

你看:

分区日志是严格按顺序追加的,生产者们要写数据的时候,就靠原子CAS操作去竞争写入位置,全程都不用互斥锁。

这样一来:

磁盘顺序写的性能就能完全发挥出来了。

再说说消费者提交偏移量:

它是原子操作,就算好几个消费者同时提交也不会乱套。

而且:

有了幂等生产者和事务支持,还能保证提交操作是Exactly-Once语义,这点在实际业务里可是很重要的。

至于副本同步状态(ISR)的更新:

Kafka用了无锁数据结构加内存屏障来实现,这样就不会因为副本状态变了,就出现全局锁竞争的情况。

这些设计加在一起,才让Kafka在高并发下也能跑得很顺。

2.控制器的功能

控制器在Kafka集群里是个特殊的broker,就像整个分布式系统的“指挥中心”。

所有broker刚启动的时候:

都会想着在ZooKeeper上创建/controller这个临时节点,谁先创建成功,谁就当控制器,其他的就当follower。

而且:

通过controller_epoch机制能检测过期请求,保证集群里始终只有一个“指挥”,不会乱套。要是控制器出了故障:

剩下的broker就会重新竞选。

新的控制器一启动,马上就会忙活起来:

- 重建ControllerContext元数据缓存

- 注册分区/主题/代理变更监听器

- 启动分区和副本状态机

- 检查有没有没完成的分区重分配任务

这些事儿都做完,故障转移就完成了。

另外:

控制器还会盯着每个分区的ISR集合,一旦发现leader不行了,就会自动从ISR里选个新的leader。

一句话总结:

通过unclean.leader.election.enable这个配置,还能在数据一致性和可用性之间找个平衡,特别灵活。

四、企业级Kafka应用的选择

马蜂窝的Kafka发展历程,给中小企业提供了很好的参考,他们分四个阶段建起了稳定的Kafka基础设施:

1. 版本升级策略

从0.8.3升到1.1.1,解决了安全支持不足、监控指标少等问题。

选版本时重点看这些:

- 0.9的安全认证授权

- 0.10的时间戳查询(支持数据重播)

- 0.11的幂等性和事务支持

- 1.x版本在运维上的改进

2. 资源隔离的设计

按功能把集群分开:

- Log集群负责原始数据采集,

- 全量订阅集群供内部实时任务用,

- 个性定制集群给业务方专用。

集群内部:

把像server-event和mobile-event这些大流量主题放到不同broker上,物理隔离,避免流量集中。

3. 安全和监控体系

用SASL/SCRAM加ACL的组合做轻量级鉴权,比复杂的Kerberos方案好用。

建个"雷达"监控平台:

盯着Lag积压、吞吐量这些关键指标。

尤其要注意:

慢消费者,他们可能导致PageCache失效,引发磁盘读放大。

4. 平台化的治理

建了实时订阅平台,统一管理生产/消费申请、用户授权和监控告警,防止业务方乱用资源。

问题来了:

物流巨头DHL曾在实践中遇到了处理平均70KB大消息的问题。

他们的做法是:

- 原来的IBM MQ继续处理核心事务,

- 用Kafka当数据流水线处理分析型大消息,

- 然后慢慢迁移到Azure云上的Kubernetes微服务架构。

用过来人的经验告诉你,这种渐进式改造策略,比一下子全换掉靠谱得多。

五、Kafka在数据流领域的新应用

随着Kafka从消息系统变成分布式流平台,它的应用场景越来越广,不断有新的可能性。

1. 实时物流控制塔

BAADER公司做的食品加工监控系统,把Kafka和MQTT协议结合起来。

做到了:

- 实时处理边缘设备的GPS和传感器数据,

- 实现动态路线规划和精准到达时间预测。

这说明Kafka已经进入运营技术(OT)领域了。

2. 流批一体的数据枢纽

现在的企业经常要往Elasticsearch、HBase、数据仓库等各种系统里灌数据。

Kafka作为统一的数据枢纽,不用给每个系统单独建数据管道。

比如:

Shippeo平台,通过Kafka同时连MySQL、PostgreSQL和Snowflake,把事务系统和分析的压力分开,听着是不是很熟?很多企业都有类似需求。

3. 工业大数据的连接器

在工业4.0场景里,Kafka成了连接IT和OT层的桥梁。

工厂里成千上万台设备产生的时序数据:

- 先在边缘的Kafka集群预处理,

- 再传到云端大数据平台。

这种分层处理方式,平衡了实时性和资源限制。

4. 托管服务

奥地利邮政在云迁移时的评估很有代表性:

- 原生Azure Event Hub功能不够灵活;

- 自己建Kafka集群,运维太麻烦;

- 最后选了Confluent Cloud(Azure托管的)。

这说明:

托管服务会成为越来越多企业的选择,能让团队专心做业务,不用操心基础设施。

结语

说到底,Kafka的“快”不是魔法,而是把硬盘读写和网络传输的潜力发挥到了极致

——顺序写盘、零拷贝、批量打包、无锁设计,招招都冲着效率去。

而企业想真正玩转Kafka,光知道它快还不够。

选对版本、做好隔离、严控安全、搭好监控、平台化管理,这些“组合拳”一个都不能少。DHL、马蜂窝这些先行者的经验告诉我们:稳比快更重要,架构要跟着业务灵活变通。

现在就开始打造属于你的“快”且“稳”的Kafka平台吧!