在现代社会,数据已然成为企业发展的重要战略资源。随着数据量的爆炸性增长,大数据技术不断发展,企业如何高效地存储、处理和分析这些数据,成为了影响其核心竞争力的关键因素。今天,我们将深入探讨大数据的几个关键概念,通过实际案例和代码示例,为你揭开大数据的神秘面纱。

数据湖与数据仓库

在大数据领域,数据湖和数据仓库是两个常见的术语,虽然它们在功能上有所重叠,但实际上有着不同的设计理念和应用场景。

数据湖是一个存储海量原始数据的系统,它可以包含结构化、半结构化和非结构化的数据。数据湖的最大特点是能够保留数据的原始状态,并且支持灵活的处理和分析方式。常见的实现技术包括Hadoop和Amazon S3。

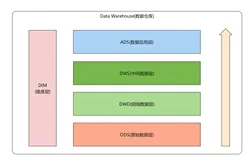

数据仓库则是一个用于存储和管理结构化数据的系统,数据在进入数据仓库之前会经过ETL(Extract, Transform, Load)处理,确保数据的一致性和完整性。数据仓库的设计目的是高效查询和分析。常见的实现技术包括Amazon Redshift和Google BigQuery。

# 使用Python代码示例展示数据湖的实现

from pyspark.sql import SparkSession

# 初始化SparkSession

spark = SparkSession.builder.appName("DataLakeExample").getOrCreate()

# 读取原始数据

data = spark.read.format("csv").option("header", "true").load("s3a://your-bucket/raw-data.csv")

# 将原始数据存储到数据湖

data.write.format("parquet").save("s3a://your-bucket/data-lake")

-- 使用SQL代码示例展示数据仓库的实现

-- 创建数据仓库表

CREATE TABLE sales_data (

order_id INT,

customer_id INT,

product_id INT,

order_date DATE,

quantity INT,

price DECIMAL(10,2)

);

-- 加载数据到数据仓库

COPY sales_data

FROM 's3://your-bucket/processed-data.csv'

CREDENTIALS 'aws_access_key_id=your_access_key;aws_secret_access_key=your_secret_key'

CSV;

实时处理与批处理

在大数据处理中,实时处理和批处理是两种主要的数据处理模式。

实时处理指的是对数据流进行实时分析和处理,常用于需要快速响应的场景,比如金融交易监控、实时推荐系统等。常见的实现技术包括Apache Kafka和Apache Flink。

批处理则是对大批量数据进行离线处理,通常用于数据量大但处理实时性要求不高的场景,比如数据报表生成、历史数据分析等。常见的实现技术包括Apache Hadoop和Apache Spark。

# 使用Python代码示例展示实时处理

from kafka import KafkaConsumer

import json

# 初始化Kafka消费者

consumer = KafkaConsumer(

'your-topic',

bootstrap_servers=['localhost:9092'],

value_deserializer=lambda x: json.loads(x.decode('utf-8'))

)

# 处理实时数据

for message in consumer:

data = message.value

# 在这里进行数据处理

print(data)

# 使用Python代码示例展示批处理

from pyspark.sql import SparkSession

# 初始化SparkSession

spark = SparkSession.builder.appName("BatchProcessingExample").getOrCreate()

# 读取历史数据

data = spark.read.format("csv").option("header", "true").load("s3a://your-bucket/history-data.csv")

# 进行批处理操作

aggregated_data = data.groupBy("product_id").agg({

"quantity": "sum"})

# 将结果存储到数据仓库

aggregated_data.write.format("parquet").save("s3a://your-bucket/aggregated-data")

数据治理与数据安全

数据治理和数据安全是大数据领域不可忽视的重要方面。数据治理包括数据质量管理、数据生命周期管理、数据标准化等内容,目的是确保数据的一致性和可靠性。数据安全则涵盖数据加密、访问控制、隐私保护等,确保数据在存储和传输过程中的安全。

# 使用Python代码示例展示数据加密

from cryptography.fernet import Fernet

# 生成加密密钥

key = Fernet.generate_key()

cipher = Fernet(key)

# 加密数据

data = "Sensitive Information"

encrypted_data = cipher.encrypt(data.encode())

# 解密数据

decrypted_data = cipher.decrypt(encrypted_data).decode()

print(f"Original Data: {data}")

print(f"Encrypted Data: {encrypted_data}")

print(f"Decrypted Data: {decrypted_data}")

结语

大数据技术的不断发展,为企业和社会带来了巨大的变革机遇。从数据湖到数据仓库,从实时处理到批处理,再到数据治理与数据安全,每一个环节都至关重要。在未来,我们需要不断探索和创新,充分发挥大数据的潜力,助力企业迈向智能化、数据驱动的新时代。