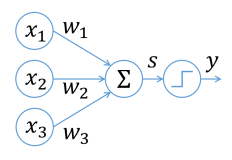

在神经网络的神秘世界里,激活函数扮演着极为关键的角色,它犹如神经元的“激发阈值”与“转换开关”,赋予神经网络处理复杂非线性问题的能力。当我们运用 C 语言来构建神经网络时,如何妥善处理激活函数的计算,成为了决定神经网络性能优劣的重要环节。

激活函数在神经网络中的作用举足轻重。它为神经网络引入了非线性因素,使得神经网络能够拟合各种复杂的函数关系,而非仅仅局限于线性变换。从简单的阶跃函数到常用的 Sigmoid、ReLU 等函数,每一种激活函数都有着独特的特性与适用场景。在 C 语言实现神经网络时,准确地计算这些激活函数的值是让神经网络正常运作并有效学习的基础。

以 Sigmoid 激活函数为例,它的数学表达式为 。在 C 语言中处理其计算时,需要考虑到数值稳定性。由于指数运算在计算机中可能会导致数值溢出,尤其是当 取较大正值或负值时。为了避免这种情况,可以对表达式进行适当的变形,如 。这样,当 为较大正值时,直接计算指数项的分子分母,可有效防止溢出。同时,在计算过程中,要注意数据类型的选择,确保能够容纳计算结果的精度要求。

ReLU(Rectified Linear Unit)函数 则相对简单一些,但在 C 语言实现中也有需要注意的地方。由于其在 处不可导,在反向传播算法计算梯度时,需要特殊处理这一情况。一种常见的做法是规定在 处的梯度为一个特定值,比如 0 或 1,以保证反向传播的顺利进行。并且,在 C 语言代码中,使用条件判断语句来实现 ReLU 函数的计算时,要考虑代码的效率,避免过多的分支预测失败导致性能下降,可以采用一些优化技巧,如将判断条件与数据处理相结合,减少不必要的指令执行。

对于其他一些激活函数,如 Tanh(双曲正切函数)等,同样面临着数值稳定性和计算效率的挑战。Tanh 函数 在计算时也可能出现数值溢出问题,可类比 Sigmoid 函数的处理方式进行优化。

在 C 语言实现神经网络时,激活函数的计算不仅仅局限于单个神经元的前向传播过程。在整个神经网络的训练过程中,激活函数的导数计算在反向传播算法中起着关键作用。因为反向传播是基于链式法则,通过计算激活函数的导数来更新神经网络的权重和偏置。例如,Sigmoid 函数的导数 ,在 C 语言代码中,需要在反向传播阶段准确地计算这一导数,并根据其值来调整权重的更新量。这就要求在设计代码结构时,要将激活函数的计算及其导数计算合理地组织起来,方便在不同阶段的调用和数据传递。

此外,当神经网络的规模较大,涉及到大量神经元和多层结构时,激活函数计算的性能开销就成为了一个不可忽视的问题。在 C 语言中,可以通过一些优化手段来提高计算效率。比如,利用数组和指针来批量处理神经元的数据,减少循环的开销;采用并行计算技术,如果硬件支持的话,利用多线程或 SIMD(单指令多数据)指令集来加速激活函数在多个数据上的计算。

同时,在 C 语言中处理激活函数计算时,还要考虑代码的可维护性和扩展性。随着神经网络研究的不断深入,新的激活函数不断涌现。代码结构应该设计得足够灵活,以便能够方便地添加新的激活函数计算模块,而不会对整个神经网络的代码框架造成过大的冲击。这就需要在代码设计之初,采用合理的抽象和接口设计,将激活函数的计算封装成独立的函数或模块,通过统一的接口与神经网络的其他部分进行交互。

综上所述,在 C 语言实现神经网络时,激活函数的计算是一个充满挑战与机遇的领域。需要我们深入理解各种激活函数的特性,在计算过程中兼顾数值稳定性、计算效率、代码可维护性等多方面的因素。通过精心的设计和优化,才能构建出高效、准确且具有良好扩展性的神经网络,使其在图像识别、自然语言处理等众多领域发挥出强大的威力,推动人工智能技术不断向前发展。

![[深度学习入门]什么是神经网络?[神经网络的架构、工作、激活函数]](https://ucc.alicdn.com/pic/developer-ecology/u4n2puyxrj26a_391330b2e3e64307a81bd65a90b63e99.png?x-oss-process=image/resize,h_160,m_lfit)