一、NLTK库(Natural Language Toolkit)简介

- 定义

- NLTK是一个用于构建自然语言处理(NLP)应用程序的Python库。它提供了易于使用的接口来处理人类语言数据,包括对文本进行分类、标记化、词干提取、标记、解析等操作。

- NLTK包含了大量的语料库(如书籍、新闻文章、网络文本等)和词汇资源(如词性标注字典、命名实体识别标签等),可以用于训练和测试NLP模型。

- 应用场景

- 文本处理:对文本进行预处理,如句子分割、单词切分等。

- 词性标注:确定文本中单词的词性(名词、动词、形容词等)。

- 命名实体识别:识别文本中的人名、地名、组织名等实体。

- 情感分析:分析文本中的情感倾向(正面、负面、中性)。

- 文本分类:将文本分类到不同的类别中,如新闻分类、垃圾邮件分类等。

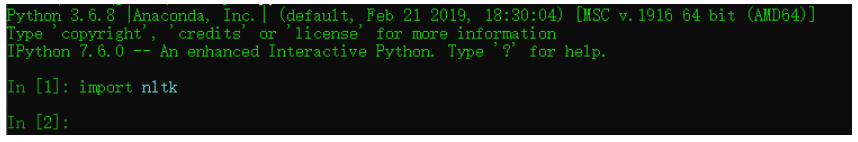

二、NLTK库的使用方法

- 安装

- 使用pip进行安装:

pip install nltk

- 下载相关数据

三、代码示例

1. 句子和单词切分(Tokenization)

import nltk

text = "Natural Language Processing is an interesting field. It has many applications."

sentences = nltk.sent_tokenize(text)

print("Sentences:")

for sentence in sentences:

print(sentence)

words = []

for sentence in sentences:

word_tokens = nltk.word_tokenize(sentence)

words.extend(word_tokens)

print("\nWords:")

for word in words:

print(word)

2. 词性标注(Part - of - Speech Tagging)

import nltk

text = "I love apples. They are delicious."

words = nltk.word_tokenize(text)

tagged_words = nltk.pos_tag(words)

print("Tagged words:")

for word, tag in tagged_words:

print(word, "-", tag)

3. 命名实体识别(Named Entity Recognition)

import nltk

text = "Apple Inc. is headquartered in Cupertino, California."

words = nltk.word_tokenize(text)

tagged_words = nltk.pos_tag(words)

named_entities = nltk.ne_chunk(tagged_words)

print("Named entities:")

print(named_entities)

4. 词干提取(Stemming)

from nltk.stem import PorterStemmer

ps = PorterStemmer()

words = ["running", "runs", "ran", "easily", "fairly"]

for word in words:

stem = ps.stem(word)

print(word, "->", stem)