在深度学习领域,训练一个神经网络通常是一个“一锤定音”的过程,类似于将知识雕刻在石头上:一旦训练完成,几乎不可能编辑网络中的知识,因为所有信息都分布在网络的权重中。然而,谷歌的研究人员提出了一种简单而引人注目的替代方案,即将深度神经网络的表示能力与数据库的灵活性相结合。

谷歌的研究人员提出了一种名为“视觉记忆”的方法,该方法将图像分类任务分解为两个部分:图像相似性(由预训练的嵌入提供)和搜索(通过从知识数据库中快速检索最近邻)。通过这种方式,他们构建了一个简单而灵活的视觉记忆系统,具有以下关键能力:

- 灵活添加数据的能力:从单个样本到整个类别,甚至数十亿规模的数据,都可以灵活添加。

- 删除数据的能力:可以通过“机器遗忘”和内存修剪来删除数据。

- 可解释的决策机制:可以干预以控制其行为。

这些能力共同展示了显式视觉记忆的好处。研究人员希望这能为关于如何在深度视觉模型中表示知识的讨论做出贡献,而不仅仅是将知识“雕刻”在权重中。

视觉记忆方法具有以下几个优势:

- 灵活性:视觉记忆可以灵活地添加和删除数据,这对于处理不断变化的数据需求非常有用。例如,当新的数据集或类别可用时,可以轻松地将它们添加到视觉记忆中,而当某些数据变得过时或不安全时,可以将其删除。

- 可解释性:视觉记忆的决策机制是可解释的,这意味着可以理解和干预其行为。这对于确保模型的公平性和透明度非常重要。

- 可扩展性:视觉记忆可以扩展到数十亿规模的数据,而不需要额外的训练。这对于处理大规模数据集非常有用。

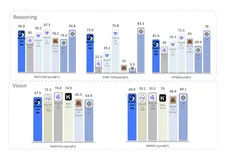

研究人员在多个数据集上进行了实验,包括ImageNet和iNaturalist,并取得了令人印象深刻的结果。例如,他们使用视觉记忆方法在ImageNet上实现了88.5%的top-1准确率,这比之前的DinoV2 ViT-L14 kNN和线性探测方法都更好。

此外,研究人员还展示了视觉记忆在处理新类别和大规模数据方面的灵活性。例如,他们将64个新类别添加到ImageNet训练集的视觉记忆中,并实现了87%的top-1准确率,而没有对模型进行任何训练。

尽管视觉记忆方法具有许多优势,但也有一些限制和挑战需要考虑:

- 对预训练模型的依赖:视觉记忆方法依赖于预训练的嵌入模型,这意味着如果数据分布发生较大变化,可能需要更新嵌入模型。

- 计算成本:虽然视觉记忆可以灵活地添加和删除数据,但在某些情况下,可能需要进行大量的计算来更新内存。

- 数据质量:视觉记忆的性能取决于数据的质量和多样性。如果数据质量较差或多样性不足,可能会影响视觉记忆的性能。