在人工智能领域,大型神经网络的能效问题一直是研究的热点。近日,一项由MIT和清华校友共同完成的研究成果引起了广泛关注。他们提出了一种名为L-Mul的全新算法,通过将浮点数乘法转换为整数加法,实现了对Transformer模型的优化。这一创新性的方法不仅在计算资源上实现了显著的节约,还在多个任务上取得了与传统方法相当甚至更好的性能。

大型神经网络在处理各种任务时,通常需要进行大量的浮点数运算,其中乘法操作占据了绝大部分的计算资源。然而,浮点数乘法相比于整数加法,在硬件实现上要复杂得多,消耗的能量也更多。这使得在实际应用中,尤其是在移动设备等资源受限的场景下,神经网络的能效问题成为了一大挑战。

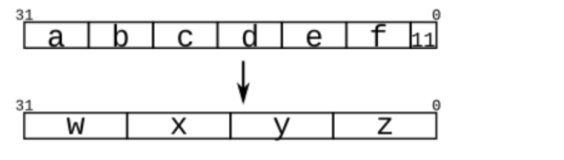

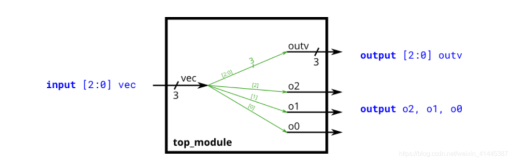

为了解决这一问题,研究团队提出了L-Mul算法。该算法的核心思想是将浮点数乘法转换为整数加法,从而降低计算的复杂性和能耗。具体来说,L-Mul算法通过将浮点数转换为整数,然后利用整数加法来近似实现浮点数乘法的效果。由于整数加法在硬件实现上要简单得多,因此可以显著降低计算的能耗。

研究团队在多个任务上对L-Mul算法进行了评估,包括自然语言理解、结构化推理、数学和常识问答等。结果表明,L-Mul算法在保持较高精度的同时,显著降低了计算的能耗。例如,在Transformer模型中,使用L-Mul算法替换所有的浮点数乘法操作,可以在保持与使用float8_e4m3精度相当的性能的同时,将能耗降低80%以上。

L-Mul算法的提出,为解决大型神经网络的能效问题提供了一种全新的思路。通过将浮点数乘法转换为整数加法,可以在保持较高性能的同时,显著降低计算的能耗。这对于推动人工智能技术在移动设备等资源受限场景下的应用具有重要意义。

然而,L-Mul算法也存在一些潜在的问题和挑战。首先,由于L-Mul算法是通过近似实现浮点数乘法的效果,因此在精度上可能存在一定的损失。虽然研究团队的实验结果表明,这种损失在实际应用中是可以接受的,但在一些对精度要求极高的任务中,可能需要进一步的研究和优化。

其次,L-Mul算法的实现需要对现有的神经网络框架进行一定的修改和适配。这可能会增加开发和部署的复杂性,尤其是对于一些已经在生产环境中运行的系统来说。

最后,L-Mul算法的能效优势主要体现在硬件实现上。虽然研究团队在论文中提到了L-Mul算法在软件实现上的潜力,但在实际应用中,可能需要进一步的研究和优化,以充分发挥其能效优势。

对于未来的研究,我们可以从以下几个方面进行探索:

- 精度优化:进一步研究和优化L-Mul算法的精度,尤其是在对精度要求极高的任务中,探索如何在保持能效优势的同时,提高算法的精度。

- 框架适配:研究如何将L-Mul算法更好地集成到现有的神经网络框架中,降低开发和部署的复杂性,提高算法的易用性。

- 硬件实现:探索L-Mul算法在硬件实现上的潜力,研究如何设计和优化专用的硬件加速器,以充分发挥L-Mul算法的能效优势。

- 应用拓展:将L-Mul算法应用于更多的任务和场景中,探索其在图像处理、语音识别等领域的应用潜力。