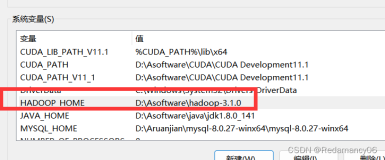

在Hadoop环境中,如果你修改了配置文件(如hadoop-env.sh, core-site.xml, hdfs-site.xml, mapred-site.xml, 或 yarn-site.xml),或者更改了系统级别的环境变量(如JAVA_HOME),为了使这些更改生效,你需要进行以下步骤:

重启Hadoop服务:

- 停止Hadoop的所有相关服务。这通常包括NameNode, DataNode, SecondaryNameNode, ResourceManager, NodeManager等。

- 使用Hadoop的脚本停止服务,例如:

$HADOOP_HOME/bin/stop-dfs.sh $HADOOP_HOME/bin/stop-yarn.sh - 等待所有进程完全停止。

重新启动服务:

- 在确认所有服务都已经停止后,重新启动Hadoop集群。

$HADOOP_HOME/bin/start-dfs.sh $HADOOP_HOME/bin/start-yarn.sh

- 在确认所有服务都已经停止后,重新启动Hadoop集群。

验证更改:

- 一旦服务重启,你可以通过运行Hadoop命令来检查你的更改是否已经应用。例如,你可能想要查看Hadoop的配置设置或运行一个简单的MapReduce作业来测试环境。

格式化NameNode(可选):

- 如果你更改了与HDFS相关的配置,特别是

dfs.namenode.name.dir或dfs.datanode.data.dir,你可能需要重新格式化NameNode。但是,请注意,这将删除所有的现有数据和元数据,所以仅在必要时执行此操作。$HADOOP_HOME/bin/hdfs namenode -format

- 如果你更改了与HDFS相关的配置,特别是

检查日志:

- 查看Hadoop的日志文件,确保没有错误信息,并且服务能够正常启动。日志通常位于

$HADOOP_HOME/logs目录下。

- 查看Hadoop的日志文件,确保没有错误信息,并且服务能够正常启动。日志通常位于

测试集群功能:

- 运行一些基本的Hadoop命令或作业来确保集群按预期工作。例如,使用

hdfs dfs -ls /来列出根目录下的文件,或者提交一个简单的MapReduce任务。

- 运行一些基本的Hadoop命令或作业来确保集群按预期工作。例如,使用

请确保在对生产环境做任何更改之前,都有充分的备份和测试计划,以防止意外的数据丢失或服务中断。