如何使用PySpark进行离线数据分析?

使用PySpark进行离线数据分析涉及多个关键步骤,包括数据读取、清洗、转换、聚合以及分析等。具体如下:

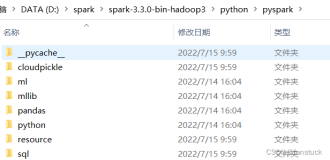

- 环境准备:确保Spark集群正确配置并且PySpark已安装设置。创建一个SparkSession,它是进行数据处理的入口点[^2^]。

- 数据读取:使用

spark.read方法读取不同格式的数据(如CSV、JSON、Parquet等),并将其转换为DataFrame。例如,从CSV文件读取数据,需要使用spark.read.csv("data.csv", header=True, inferSchema=True)。 - 数据清洗:对数据进行必要的清洗工作,如去除重复值、处理缺失值、数据类型转换等。这些操作可以通过DataFrame API提供的方法来完成,如

dropDuplicates(),na.fill(),withColumn()等[^2^]。 - 数据转换:根据分析需求对数据进行转换,这可能包括选择特定的列、应用函数或转换、创建新列等。使用如

select(),withColumn(), 或者自定义的用户定义函数(UDF)来实现这些转换[^1^][^2^]。 - 数据聚合:使用

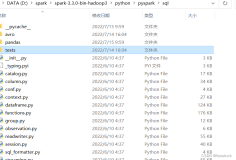

groupBy()和agg()等功能进行数据聚合。这使您可以对数据集按照某一列或多列进行分组,并针对每个组应用统计函数,如求和、平均、最大值、最小值等[^2^]。 - 数据分析:利用Spark MLlib库进行更深入的数据分析和机器学习。MLlib提供了多种机器学习算法和统计方法,如分类、回归、聚类等,可以应用于离线数据分析中[^2^]。

- 结果存储:经过处理和分析后的数据可以被保存回文件系统,或存储到数据库等其他目标存储中。使用

ds/df.write.mode(SaveMode).format("类型").option.save将数据写回不同的存储系统中[^1^]。 - 性能优化:在处理大规模数据时,考虑使用数据分区、缓存策略等优化技术和策略来提高作业的执行速度和资源利用率。通过合理的分区和缓存策略、使用广播变量和累加器、调整作业的并行度等方式来优化分布式计算过程[^2^]。

- 故障处理:在大规模的分布式计算环境中,故障处理和调试是不可避免的。PySpark提供了一些工具和技术,帮助您诊断和解决分布式作业中的问题,如查看日志、监控资源使用情况、利用调试工具等[^2^]。

通过以上步骤,您可以有效地使用PySpark进行离线数据分析,从而在大数据环境中获得有价值的见解和信息。