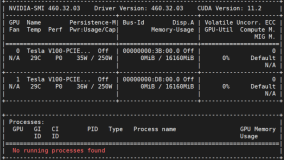

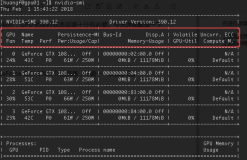

这是nvidia-smi命令的一部分输出,用于显示一块NVIDIA Tesla T4 GPU的信息。下面是对每个部分的详细说明:

Driver Version: 显示当前正在使用的NVIDIA驱动程序的版本号,这里是440.33.01。

CUDA Version: 显示CUDA(Compute Unified Device Architecture)的版本号,这里是10.2。

GPU Information:

- GPU Name: 显示GPU的名称,这里是Tesla T4。

- Persistence-M: 显示GPU是否处于持续性模式。在这里,它处于关闭状态(Off)。

- Bus-Id: 显示GPU的总线ID。

- Disp.A: 显示GPU是否与显示器相关(通常为Display A)。

- Volatile Uncorr. ECC: 显示GPU的易失性不可纠正ECC(错误纠正码)状态。

Fan, Temperature, Performance, Power:

- Fan: 显示风扇的状态。

- Temp: 显示GPU的温度,这里是75摄氏度。

- Perf: 显示GPU的性能模式,这里是P0。

- Pwr:Usage/Cap: 显示GPU的功耗使用情况和上限,这里是32W使用 / 70W上限。

Memory Usage:

- Memory-Usage: 显示GPU显存的使用情况,这里是2988MiB已使用 / 15109MiB总显存。

GPU Utilization and Compute Mode:

- GPU-Util: 显示GPU的利用率,这里是0%。

- Compute M.: 显示GPU的计算模式,这里是默认模式。

Processes and GPU Memory Usage:

- Processes: 列出正在运行的进程以及它们在GPU上使用的显存。

- GPU Memory: 显示每个进程在GPU上使用的显存量。

在这个示例中,有两个进程正在使用这块GPU:

- PID 9354的进程名为"bin/face-general-service",使用了2342MiB的显存。

- PID 11003的进程名为"bin/face-general-service-8816",使用了635MiB的显存。

这个输出提供了关于GPU的各种信息,包括硬件状态、性能指标和正在运行的进程的使用情况,帮助你监控和管理GPU的使用情况。