在数字化浪潮中,许多企业面临着数据库升级、扩容或整合的需求。TiDB Data Migration (DM) 作为一种高效的数据迁移解决方案,正在被越来越多的企业所采用。

以某电商平台为例,随着业务的发展,原有的MySQL数据库已无法满足其日益增长的数据处理需求。为了提升性能和扩展性,该平台决定迁移到TiDB数据库。在这个过程中,TiDB DM发挥了重要作用。

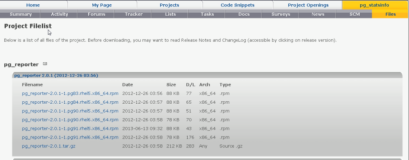

首先,该平台通过TiUP工具部署了DM集群,包括DM-master、DM-worker和dmctl等组件。然后,配置了源数据库(MySQL)和目标数据库(TiDB)的连接信息,以及迁移任务的具体参数。在这个过程中,DM支持全量和增量的数据迁移,可以根据实际需求进行选择。

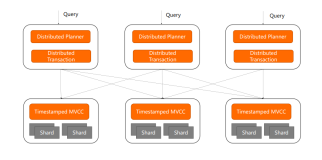

接下来,通过dmctl工具启动了迁移任务。DM-worker从MySQL数据库中读取binlog,并将其编排后输出到TiDB集群。在这个过程中,DM的异步迁移特性使得源库的修改可以实时同步到目标库,保证了数据的一致性和完整性。

迁移过程中,该平台遇到了部分数据格式不兼容的问题。幸运的是,DM提供了数据过滤功能,允许用户根据需求选择需要迁移的数据。通过配置过滤规则,该平台成功过滤了不兼容的数据,确保了迁移的顺利进行。

迁移完成后,该平台通过dmctl工具查看了迁移任务的状态和结果。所有数据均成功迁移至TiDB数据库,且性能得到了显著提升。同时,由于DM的易用性和稳定性,整个迁移过程未对业务造成任何影响。

总结来说,TiDB Data Migration (DM) 在该电商平台的数据库迁移过程中发挥了重要作用。通过其高效、稳定、易用的特性,帮助企业顺利完成了数据迁移任务,提升了数据处理能力和业务效率。

当然,在实际应用中,不同的企业和场景可能会有不同的需求和挑战。因此,在使用TiDB DM进行数据迁移时,建议结合具体场景进行配置和优化,遵循最佳实践,以确保迁移的顺利进行和数据的准确性。

总之,TiDB DM作为一款高效的数据迁移工具,为企业提供了灵活、可靠的数据迁移解决方案。通过深入了解其原理和应用方法,并结合实际案例进行操作,企业可以更好地应对数据库迁移的挑战,为业务发展提供有力支持。