分享105个ASP整站程序源码,总有一款适合您

105个ASP整站程序源码下载链接:https://pan.baidu.com/s/148X7V8o435Scu0lUgWMwFQ?pwd=8mwj

提取码:8mwj

Python采集代码下载链接:采集代码.zip - 蓝奏云

import os import shutil import requests from bs4 import BeautifulSoup from framework.base.BaseFrame import BaseFrame from sprider.access.SpriderAccess import SpriderAccess from sprider.plugin.SpriderTools import SpriderTools from sprider.plugin.UserAgent import UserAgent class CNSourceCoder: base_url = "http://www.downcode.com" max_pager = 10 # 每页的数量 影响再次采集的起始位置. word_image_count = 5 # word插入图片数量 同时也是明细采集图片和描述的数量 page_end_number = 0 word_content_list = [] haved_sprider_count = 0 # 已经采集的数量 sprider_detail_index = 0 # 明细方法采集的数量 累加

七彩天空整站程序

Wj8.Net春来春往酷站大全

离子星全站(含QQ迷你门户)

七夕情人节

聂枫设计 V2.1

合肥高校联盟 V2.0 完整版

民政信息

家住蕲春全站V2.1

金无忧多用户博客

仿百度贴吧

52ks博摘

紫色雨真爱永恒版

我就爱乐娱乐站

宇森流量广告交易平台文本链

汉中泰奇互动整站

优秀企业整站(英文版)

优秀企业通用网站

媒体中国韩国酷站网址大全

美加喜房产中介程序

飞马驿站全站程序

老崔家园整站程序[后台管理补丁]

网络电话联盟网 Joekoe 免费版1.2修改版

飞闪年华整站

商丘旅游网(大飞十运会商丘华夏文明之火记念版)

浪漫千年整站系统 V2.10(古香古色版)

嘟嘟网

虫虫工作室

YUKI工作室 V1.0

八零秀2004

西安华西大学西部网V1.0

幻味空间论坛

漂亮的企业建站系统 中英文双语豪华版

斯莫基风格(动易2005+动网7.1整合版)V 1.0 Sp1

晨昏设计1.0版

蚱蜢DJ联盟整站程序

电子商务咨询网

269E在线

无忧传奇官方站点(沉香飞燕)提供下载

易家产品展示系统

第九互动V8.0整站正式版

当石头还是鸟的时候-个人站

北回归线精美整站 V1.0 修正版

无忧传奇官方站点(火龙飞天)提供下载

红土飞扬网整站免费完整版程序 V1.0

拓网工坊 V3.0版

唯C动力整站程序

闪耀吧动漫网整站程序Html版(带完整数据库)

站长之家.Cms.全能能商务版

无忧传奇官方站点(“冰”荒马乱版)提供下载

翱翔设计(天绿色)音乐版V4.0

大连普兰店公安信息网全站程序

智慧中国—动易程序智慧中国美化版

无痕医药信息网

翼动留言板 V1.0

一分流水整站程序 5.0

梦缘网络

QQ网址ASP生成HTML版

FLASH动漫娱乐网第二版

幻雪企业系统

[静茵]光华网全站程序(源于中青网V3.0)

『E网动漫』全站程序

轻狂免费资源网V1.0

中华青年网V3.0正式版

中国浙江收藏网

七彩谷商城成人用品销售程序

酷妖之家全站程序 V4.0

幻雪千年2005预览版

横县信息港2005

520小屋村(免费个人小屋)

写E意全站程序 V1.1

中国媒体爱好者 整站系统 V1.0

Crazyhit旅行社整站系统

孤单·键盘 个人网页

WEB网址大全管理程序源码下载(ASP+数据库)

锡安诗歌音乐程序

北京物资学院女足网站 FIFA V2.0

无忧传奇官方站点(仿魔兽世界)提供下载

中娱文学交流俱乐部

虫虫上网助手Html版

动易中国流行前线2005SP1

尚奈克斯房产网

蓝色理想

创业者同盟网站系统V1.0

天翼工作组网站系统 V0.1

English外贸企业网站(英文版本) 贵州网联(中国一建站)

江南网游V2.0版整站

中小学校网站整站程序

啊Zhuの网络

江西人才网

巴州学生在线整站V1.0

桂子山在线

啊猪动漫吧

心灵视觉Ver1.00正式版

无忧传奇官方站点(豪华版 生成HTM)

攀西信息网(乔客修改版)

多乐商务网2.0完整板(阿里巴巴原码泄漏修改版)

世纪风情网[门户网站]

攀枝花学院学报

蓝琼天空 FreePower362_full 美化版

江苏生活网大型综合站

V265.Com娱乐资源站整站

坤龙论坛

站络中国修改版(精简)

嘉缘人才管理系统V2.15免费版

中国E域在线美化无错第二版

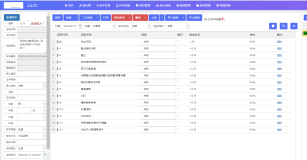

def sprider(self,sprider_name,sprider_count,start_number, pager_number,sprider_type,is_show_browse,root_path, first_column_name,second_column_name,is_record_db): """ http://www.downcode.com/sort/j_1_2_1.shtml :param sprider_name: :return: """ self.first_folder_name=sprider_type.upper() self.base_path=root_path self.first_column_name = first_column_name self.second_column_name = second_column_name self.sprider_start_count=start_number self.is_record_db=is_record_db BaseFrame().debug("开始采集[源码下载站]" + self.first_folder_name + "源码...") BaseFrame().right("本次采集参数:sprider_count(采集数量):" + str(sprider_count) + "") BaseFrame().right("本次采集参数:sprider_name(采集名称):" + sprider_name + "") sprider_url = self.base_url + "/{0}/{1}_1.shtml".format(self.first_column_name, self.second_column_name)# 根据栏目构建URL BaseFrame().debug("本次采集参数:sprider_url:" + sprider_url) self.second_folder_name = str(sprider_count) + "个" + sprider_name # 二级目录也是wordTitle self.merchant = int(self.sprider_start_count) // int(self.max_pager) + 1 # 起始页码用于效率采集 self.file_path = self.base_path + os.sep + self.first_folder_name + os.sep + self.second_folder_name BaseFrame().right("本次采集参数:file_path=" + self.file_path + "") # 浏览器的下载路径 self.down_path = self.base_path + os.sep + self.first_folder_name+ os.sep + self.second_folder_name+ "\\Temp\\" BaseFrame().right("本次采集参数:down_path=" + self.down_path + "") # First/PPT/88个动态PPT模板/动态PPT模板 self.save_path = self.base_path + os.sep + self.first_folder_name + os.sep + self.second_folder_name + os.sep + sprider_name BaseFrame().right("本次采集参数:save_path=" + self.save_path + "") if os.path.exists(self.down_path) is True: shutil.rmtree(self.down_path) if os.path.exists(self.down_path) is False: os.makedirs(self.down_path) if os.path.exists(self.save_path) is True: shutil.rmtree(self.save_path) if os.path.exists(self.save_path) is False: os.makedirs(self.save_path) response = requests.get(sprider_url, timeout=10, headers=UserAgent().get_random_header(self.base_url)) response.encoding = 'gb2312' soup = BeautifulSoup(response.text, "html5lib") #print(soup) element_list = soup.find_all('div', attrs={"class": 'j_text_sort_a'}) page_end_number = 1 page_end_url = "" page_end_title = soup.find("a", attrs={"title": '最后页'}) page_end_url = page_end_title.get("href") if page_end_url is None or page_end_url == "": page_end_number = 1 else: page_end_number = (page_end_url.split(".shtml")[0].split("_")[3]) self.page_count = self.merchant while self.page_count <= int(page_end_number): # 翻完停止 try: if self.page_count == 1: self.sprider_detail(element_list, page_end_number,sprider_count) pass else: if int(self.haved_sprider_count) == int(sprider_count): BaseFrame().debug("sprider采集到达数量采集停止...") BaseFrame().debug("开始写文章...") SpriderTools.builder_word(self.second_folder_name, self.word_content_list, self.file_path, self.word_image_count, self.first_folder_name) SpriderTools.copy_file(self.word_content_list, self.save_path, self.second_folder_name, self.file_path) SpriderTools.gen_passandtxt(self.second_folder_name, self.word_content_list, self.file_path) BaseFrame().debug("文件编写完毕,请到对应的磁盘查看word文件和下载文件!") break next_url = self.base_url + "/{0}/{1}_{2}.shtml".format(self.first_column_name, self.second_column_name, self.page_count) response = requests.get(next_url, timeout=10, headers=UserAgent().get_random_header(self.base_url)) response.encoding = 'gb2312' soup = BeautifulSoup(response.text, "html5lib") element_list = soup.find_all('div', attrs={"class": 'j_text_sort_a'}) self.sprider_detail(element_list, page_end_number,sprider_count) pass self.page_count = self.page_count + 1 # 页码增加1 except Exception as e: BaseFrame().error("sprider()执行过程出现错误:" + str(e))

最后送大家一首诗:

山高路远坑深,

大军纵横驰奔,

谁敢横刀立马?

惟有点赞加关注大军。