截取元素

当然,我们创建Tensor张量,是为了使用里面的数据,那么就不可避免的需要获取数据进行处理,具体截取元素的方式如表:

| 函数 | 意义 |

| index_select(input,dim,index) | 在指定维度选择一些行或者列 |

| nonzero(input) | 获取非0元素的下标 |

| masked_select(input,mask) | 使用二元值进行选择 |

| gather(input,dim,index) | 在指定维度上选择数据,输出的维度与index一致(index的类型必须是LongTensor类型的) |

| scatter_(input,dim,index,src) | 为gatter的反操作,根据指定索引补充数据(将src中数据根据index中的索引按照dim的方向填进input中) |

示例代码如下所示:

import torch # 设置随机数种子,保证每次运行结果一致 torch.manual_seed(100) t1 = torch.randn(2, 3) # 打印t1 print(t1) # 输出第0行数据 print(t1[0, :]) # 输出t1大于0的数据 print(torch.masked_select(t1, t1 > 0)) # 输出t1大于0的数据索引 print(torch.nonzero(t1)) # 获取第一列第一个值,第二列第二个值,第三列第二个值为第1行的值 # 获取第二列的第二个值,第二列第二个值,第三列第二个值为第2行的值 index = torch.LongTensor([[0, 1, 1], [1, 1, 1]]) # 取0表示以行为索引 a = torch.gather(t1, 0, index) print(a) # 反操作填0 z = torch.zeros(2, 3) print(z.scatter_(1, index, a))

运行之后,效果如下:

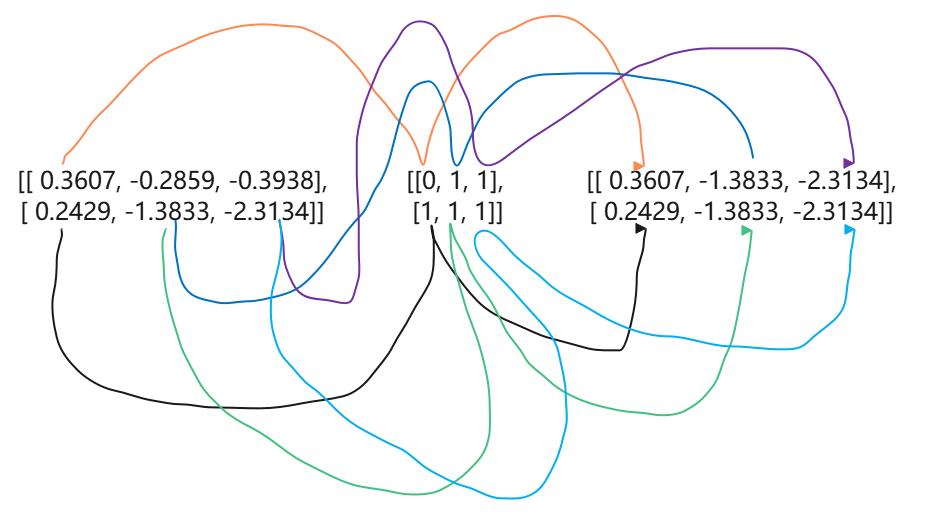

我们a = torch.gather(t1, 0, index)对其做了一个图解,方便大家理解。如下图所示:

当然,我们直接有公司计算,因为这么多数据标线实在不好看,这里博主列出转换公司供大家参考:

当dim=0时,out[i,j]=input[index[i,j]][j] 当dim=1时,out[i,j]=input[i][index[i][j]]

简单的数学运算

与Numpy一样,Tensor也支持数学运算。这里,博主列出了常用的数学运算函数,方便大家参考:

| 函数 | 意义 |

| abs/add | 绝对值/加法 |

| addcdiv(t,v,t1,t2) | t1与t2逐元素相除后,乘v加t |

| addcmul(t,v,t1,t2) | t1与t2逐元素相乘后,乘v加t |

| ceil/floor | 向上取整/向下取整 |

| clamp(t,min,max) | 将张量元素限制在指定区间 |

| exp/log/pow | 指数/对数/幂 |

| mul(或*)/neg | 逐元素乘法/取反 |

| sigmoid/tanh/softmax | 激活函数 |

| sign/sqrt | 取符号/开根号 |

需要注意的是,上面表格所有的函数操作均会创建新的Tensor,如果不需要创建新的,使用这些函数的下划线"_"版本。

示例如下:

t = torch.Tensor([[1, 2]]) t1 = torch.Tensor([[3], [4]]) t2 = torch.Tensor([5, 6]) # t+0.1*(t1/t2) print(torch.addcdiv(t, 0.1, t1, t2)) # t+0.1*(t1*t2) print(torch.addcmul(t, 0.1, t1, t2)) print(torch.pow(t,3)) print(torch.neg(t))

运行之后,效果如下:

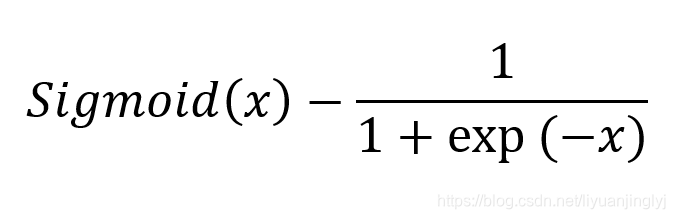

上面的这些函数都很好理解,只有一个函数相信没接触机器学习的时候,不大容易理解。也就是sigmoid()激活函数,它的公式如下:

归并操作

简单的理解,就是对张量进行归并或者说合计等操作,这类操作的输入输出维度一般并不相同,而且往往是输入大于输出维度。而Tensor的归并函数如下表所示:

| 函数 | 意义 |

| cumprod(t,axis) | 在指定维度对t进行累积 |

| cumsum | 在指定维度对t进行累加 |

| dist(a,b,p=2) | 返回a,b之间的p阶范数 |

| mean/median | 均值/中位数 |

| std/var | 标准差/方差 |

| norm(t,p=2) | 返回t的p阶范数 |

| prod(t)/sum(t) | 返回t所有元素的积/和 |

示例代码如下所示:

t = torch.linspace(0, 10, 6) a = t.view((2, 3)) print(a) b = a.sum(dim=0) print(b) b = a.sum(dim=0, keepdim=True) print(b)

运行之后,效果如下:

需要注意的是,sum函数求和之后,dim的元素个数为1,所以要被去掉,如果要保留这个维度,则应当keepdim=True,默认为False。

比较操作

在量化交易中,我们一般会对股价进行比较。而Tensor张量同样也支持比较的操作,一般是进行逐元素比较。具体函数如下表:

| 函数 | 意义 |

| equal | 比较张量是否具有相同的shape与值 |

| eq | 比较张量是否相等,支持broadcast |

| ge/le/gt/lt | 大于/小于比较/大于等于/小于等于比较 |

| max/min(t,axis) | 返回最值,若指定axis,则额外返回下标 |

| topk(t,k,dim) | 在指定的dim维度上取最高的K个值 |

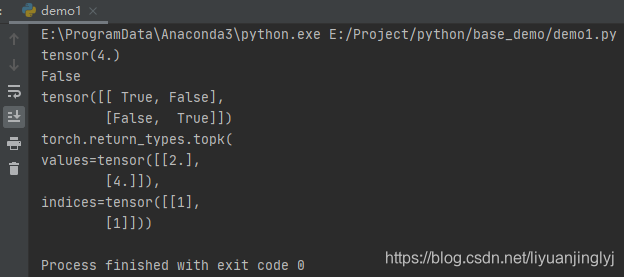

示例代码如下所示:

t = torch.Tensor([[1, 2], [3, 4]]) t1 = torch.Tensor([[1, 1], [4, 4]]) # 获取最大值 print(torch.max(t)) # 比较张量是否相等 # equal直接返回True或False print(torch.equal(t, t1)) # eq返回对应位置是否相等的布尔值与两者维度相同 print(torch.eq(t, t1)) # 取最大的2个元素,返回索引与值 print(torch.topk(t, 1, dim=0))

运行之后,输出如下:

矩阵运算

机器学习与深度学习中,存在大量的矩阵运算。与Numpy一样常用的矩阵运算一样,一种是逐元素相乘,一种是点积乘法。函数如下表所示:

| 函数 | 意义 |

| dot(t1,t2) | 计算t1与t2的点积,但只能计算1维张量 |

| mm(mat1,mat2) | 计算矩阵乘法 |

| bmm(tatch1,batch2) | 含batch的3D矩阵乘法 |

| mv(t1,v1) | 计算矩阵与向量乘法 |

| t | 转置 |

| svd(t) | 计算t的SVD分解 |

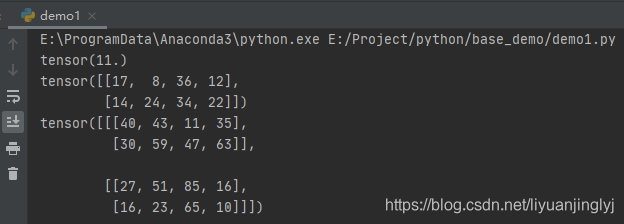

这里有3个主要的点积计算需要区分,dot()函数只能计算1维张量,mm()函数只能计算二维的张量,bmm只能计算三维的矩阵张量。示例如下:

# 计算1维点积 a = torch.Tensor([1, 2]) b = torch.Tensor([3, 4]) print(torch.dot(a, b)) # 计算2维点积 a = torch.randint(10, (2, 3)) b = torch.randint(6, (3, 4)) print(torch.mm(a, b)) # 计算3维点积 a = torch.randint(10, (2, 2, 3)) b = torch.randint(6, (2, 3, 4)) print(torch.bmm(a, b))

运行之后,输出如下: